在人工智能技术飞速发展的今天,大语言模型(LLM)的应用场景正不断拓展,但模型与外部系统之间的连接方式却成为制约其潜力发挥的关键瓶颈。为了解决这一难题,由AI领域顶尖公司Anthropic(Claude模型背后的开发团队)于2024年11月重磅推出的Model Context Protocol(MCP,模型上下文协议),正在为AI应用的开发打开新的可能。作为一种全新的开源通信协议,MCP以标准化的方式定义了AI模型与外部数据、工具之间的交互规范,为开发者构建更智能、更具交互能力的AI应用提供了通用接口。这一创新性协议的出现,标志着人工智能与现实世界交互方式即将进入一个新的阶段,也为开发者创造更多可能性。

什么是 MCP?我们为什么需要它?

MCP(模型上下文协议)是一种标准化的通信协议,专为 AI 工具(如聊天机器人、代码助手、AI Agent 等)与外部系统的集成而设计。它为 AI 引入了“使用工具”的能力框架,使其不仅能理解自然语言,还能主动调用系统资源、访问数据或执行操作。

MCP Server 的出现,正在重塑 AI 的能力边界,使其从单纯的对话机器演化为能够完成实际任务的智能助手。在 MCP 出现之前,开发者若希望让 AI 工具访问 Gmail、Google Drive 或天气 API 等外部系统,通常需要为每个集成单独编写定制逻辑,硬编码对每一个 API 的连接方式。这不仅增加了开发成本,也阻碍了 AI 工具的可扩展性与通用性。 MCP 为模型与系统之间的通信建立统一标准,降低接入门槛、提升开发效率,正如 HTTP 之于 Web 应用,支撑起智能系统互联互通。

总的来说,MCP 把过去“一个模型对一个系统”的烟囱式集成,变成了“多模型对多能力”的标准化连接网络。这是推动 AI 工具平台化和生态化的关键一步。

可以将MCP视为AI领域的"万能适配器",就像蓝牙技术能够将手机无线连接到耳机、键盘、智能家居等各类设备那样,MCP构建了一个通用协议层,让不同架构的AI模型可以无缝接入数据库、传感器、API接口等多元化资源,实现即插即用的智能化协作。

MCP 架构

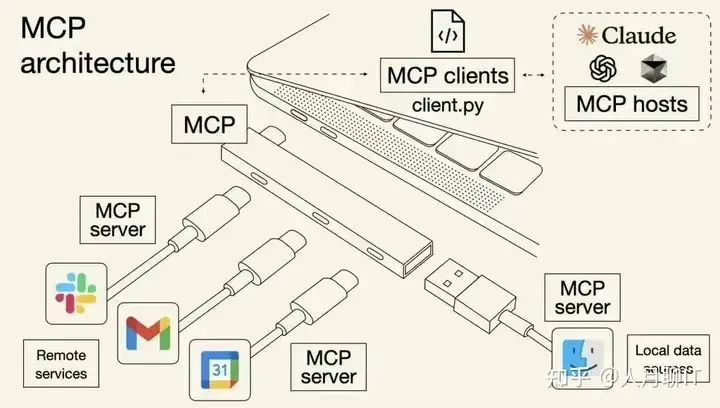

MCP 的属于客户端-服务器架构模式,其中 MCP 客户端(如:Claude Desktop、IDE 或其他 AI 工具)可以连接到多个 MCP 服务器,MCP 服务器可以安全访问你的计算机本地文件、数据库、远程服务(外部系统)等。

MCP 就是对 AI 能力的扩展,我们可以通过标准化的接口将 AI 应用连接到各种数据源和工具,从而扩展 AI 的功能,比如:

- MCP 可以让 AI 应用读取我们的数据库里面的数据。

- MCP 可以让 AI 应用自动调用本地浏览器进行操作。

有了 MCP,AI 就不止于它现有的能力,还可以开发任意属于自己的 MCP,让 AI 应用更有价值。

MCP采用客户端-服务器架构,多个服务可以连接到任何兼容的客户端。客户端可以是Claude Desktop、IDE或其他AI工具,服务器则充当适配器,暴露数据源。

MCP通过Client、Host、Server将大模型与外部交互抽象成了“客户端-服务器”架构。任何支持 MCP 的 AI 应用(MCP Host)均可直接配置并使用应用市场的MCP Server(官方、三方),无需预编码适配,类似于 USB 设备插入即用。当LLM需要完成特定任务时,可以像“即插即用”般调用这些模块,实时获得精准的上下文支持,从而实现能力的弹性扩展。

MCP 其实是Prompt Engineering 发展的产物。大模型是 AI 应用的大脑,Prompt 则负责给大模型指引和参考资料。使用 Prompt Engineering 加速大模型应用的落地是如今的主流做法。具体而言,结构化的 Prompt 可以给大模型提供:

• 额外的参考资料,如使用 RAG、联网搜索来增强大模型的回复。

• 调用工具的能力,从而实现 Agent。如提供文件操作工具、爬虫工具、浏览器操作工具(Manus使用的Brower Use)。

MCP通信机制

本地通信时采用标准输入输出,远程通信则通过SSE进行。

这两种通信方式中的消息,都采用了JSON格式进行消息传输,使MCP通信过程能够标准化,并带来了可扩展性。

调用流程图:

- 用户发送消息:用户通过客户端应用程序发送一条消息。

- 客户端传递消息:客户端将用户的消息传递给 LLM。

- LLM 请求工具或数据:LLM 可能需要额外的工具或数据来处理请求,因此向客户端发出请求。

- 客户端向 MCP 服务器请求:客户端根据 LLM 的需求,通过 MCP 协议向 MCP 服务器发送请求。

- MCP 服务器访问数据源:MCP 服务器根据请求访问相应的数据源。

- 数据源返回数据:数据源将所需的数据返回给 MCP 服务器。

- MCP 服务器返回工具或数据:MCP 服务器将获取到的工具或数据返回给客户端。

- 客户端提供工具或数据给 LLM:客户端将工具或数据传递给 LLM。

- LLM 返回处理结果:LLM 使用提供的工具或数据生成处理结果,并返回给客户端。

- 客户端显示最终结果:客户端将 LLM 的处理结果展示给用户。

MCP 的调用机制需要客户端、MCP服务端、LLM 三方配合。

比如一个查询天气的 Spring Boot 应用,按照官方标准实现具体的服务接口,在本地启动。

将服务在客户端进行配置,就像在注册中心注册一样,通常是启动命令,例如 npx 或者java,意思就是客户端打开后,在本地同时启动MCP服务。例如下面这个配置文件内容,配置了两个服务,一个用 Java 实现的,一个是 Node。

MCP与Function Call

Function Call本质上是某些大模型(如 GPT-4)提供的专有能力,允许 AI 通过结构化请求调用外部工具(例如查询天气、执行计算)。宿主应用收到请求后执行操作并返回结果。其核心是模型厂商内部的功能扩展接口,无统一标准,实现依赖特定厂商。

回顾 Function call或者RAG,都需要手工地执行工具检索、手工地将信息加入到 prompt 中,prompt 本身也需要精心地手工设计。尤其是不同大模型的Function call遵循不同的调用结构和参数格式,彼此之间基本无法互通。

MCP的爆发源于它击中了Prompt Engineering的核心矛盾——动态意图理解与静态工具调用之间的割裂。传统开发模式下,Function call需要开发者预先编写工具调用逻辑、设计Prompt模板、手动管理上下文,这一过程不仅效率低下,还导致AI应用难以规模化。

MCP 的核心优势在于统一了各家大模型原本差异化的 Function Calling 标准,形成通用协议。它不仅支持 Claude,还能兼容市面上几乎所有主流大模型,堪称 AI 领域的“USB-C 接口”。基于标准化通信规范(如 JSON-RPC 2.0),MCP 解决了模型与外部工具、数据源间的兼容性问题,开发者只需按协议开发一次接口,即可被多模型调用。

也是由于两者都能实现与外部数据的联动,MCP在刚问世时,开发者常纠结“它是Function Call的简化版,还是AI交互的HTTP标准?”但随着生态发展,MCP相比Function Call的开放性优势逐渐被认知的更加清晰:

1、Function Call的“私有协议困局”,类似手机厂商的私有快充协议,主流AI厂商各自定义封闭的调用协议(JSON Schema、Protobuf等),导致开发者为不同平台重复开发适配逻辑。切换AI服务商时,工具调用体系需“推倒重来”,跨平台成本高企,拖慢AI能力的规模化落地。

2、MCP通过统一通信规范和资源定义标准,MCP让开发者“一次开发,全平台通用”——同一工具可无缝适配GPT、Claude等不同模型。这如同AI世界的“书同文、车同轨”,终结“重复造轮子”的窘境。

3、Function Call仍是高频轻量任务的“王者”:它像模型的“贴身助手”,也是 MCP 协议链接各方的基础,运行时直接调用(如快速计算、简单查询),响应极快。

4、MCP则擅长“复杂任务外包”:模型像“指挥官”下达需求(如抓取网页),MCP Server作为“快递员”按需响应,通过HTTP/SSE协议“送货上门”,全程无需开发者手动干预。

MCP的出现让Function Call们不得不“卷”起来——推动工具调用更标准化、更便捷。

Function Call是AI的“即时小助手”,MCP是“按需响应的快递员”——两者更好的模式是协同发展。

Function Call代表“代码控”思维:开发者需精细控制工具细节;而MCP转向“意图派”模式:开发者只需定义能力边界,具体执行由大模型动态决策。两者并存,让开发者既能享受高频任务的高效,又能解锁复杂场景的灵活性。

MCP具备哪些优势:

1.一致性:以后不管是访问本地资源(数据库、文件、服务),还是访问远程资源(如Slack、GitHub API),都能用同一个协议。

2.全面性:而且支持的数据形式非常多样,包括文件内容、数据库记录、API响应、实时系统数据、屏幕截图和图像、日志文件等,基本上覆盖了所有类型。

3.安全性:MCP服务器还内置了安全机制,允许服务器自己控制资源,不用把API密钥交给大模型。

MCP 的核心价值在于:让用户为不可控的 Agent 添加工具。例如在使用 Claude Desktop、Cursor 等应用时,普通用户无法修改底层 Agent 的代码,但通过 MCP 协议就能为其扩展新工具。

未来展望

MCP“万能插头”优势让开发AI应用进一步解耦,大大降低了技术门槛,让“人人都是AI开发者”变得触手可及。

AI厂商

技术重心从工具适配转向协议兼容。MCP协议如同AI领域的“通用插座”,使得模型厂商只需确保与协议标准的兼容性,就能自动接入所有MCP生态工具。例如OpenAI通过支持MCP协议,其模型无需单独开发接口即可调用GitHub、Slack等数千种工具服务。这种转变让大模型厂商能够专注于核心算法优化,而非重复开发工具适配层。

工具开发者

MCP实现了“一次开发、全生态通用”的技术普惠。开发者将功能封装为MCP Server后,就能被所有兼容协议的AI应用调用。如PostgreSQL官方开发的数据库Server已被500多个AI应用集成,而无需针对每个模型单独适配。这让所有应用都找到了快速AI化的路径,就像十几年前“所有行业都值得用互联网重做一遍”一样;现在,所有产品都值得做一次MCP适配改造。

应用开发者

MCP打破了技术能力的边界,并加速交互范式从GUI(图形界面)向LUI(语言界面)的跃迁。通过协议标准化,开发者无需理解底层技术细节即可组合各类资源:教育机构用自然语言指令调用多语种资料库生成定制教案,零售企业通过语音指令整合ERP系统和AI模型管理库存。MCP的协议兼容性使得自然语言交互可直接映射到具体功能实现,例如腾讯地图MCP Server支持用户用“找附近人均200元的川菜馆”等口语化指令完成复杂搜索,替代传统GUI中的多级菜单操作。这种转型在制造业尤为显著——某工厂工程师通过语音指令调度MCP连接的设备集群,响应速度比传统工控界面提升5倍。

LUI开发效率的革命性提升

■ 传统GUI困境:需为不同平台(Web/iOS/Android)开发独立界面组件,维护成本占开发资源的60%;

■ MCP+LUI优势:开发者只需用自然语言描述功能需求(如生成周报图表),MCP自动匹配数据库查询、可视化工具等Server,并通过协议标准化输出结果。

MCP对交互层的解耦正在重构人机交互的底层逻辑。就像iPhone用触摸屏取代键盘,MCP协议通过统一的功能调用标准,使自然语言成为连接用户意图与系统能力的“终极接口”,标志着AI发展进入生态竞争新阶段。它构建了智能时代的“数字神经系统”,其价值不仅在于统一的功能调用标准,更在于开创了开放协作的新范式,让模型、工具、数据在统一协议下自由流动