文章目录

ollama 基本信息

- https://ollama.com/

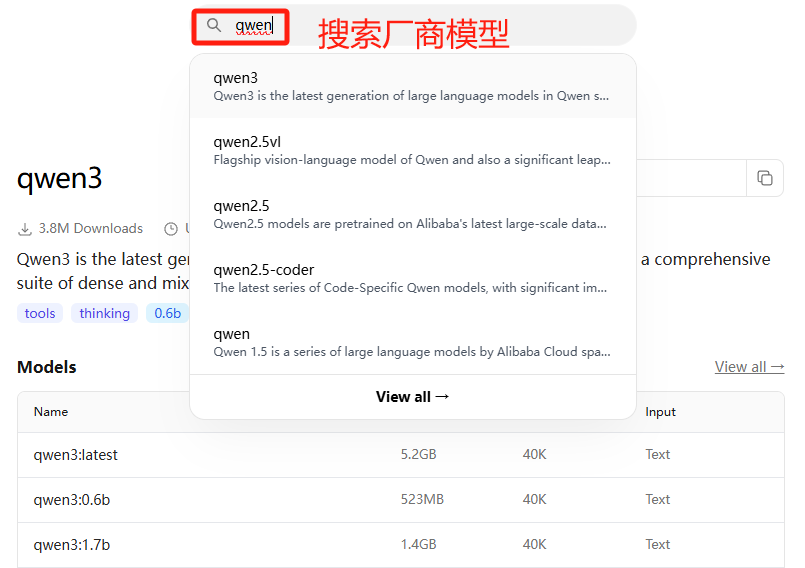

ollama 运行模型

命令行执行即可

0.6B parameter model

ollama run qwen3:0.6b

1.7B parameter model

ollama run qwen3:1.7b

4B parameter model

ollama run qwen3:4b

ollama 模型管理

要删除 Ollama 中的本地模型,可以通过命令行工具(CLI)或 API 操作。以下是具体步骤和注意事项:

🔧 方法一:使用命令行删除单个模型

查看已安装模型列表

运行以下命令确认模型名称和版本:ollama list示例输出:

NAME ID SIZE MODIFIED deepseek-r1:8b 28f8fd6cdc67 4.9 GB 10 hours ago qwen2.5-3b:latest fe5cd25d719e 2.1 GB 24 hours ago删除指定模型

使用ollama rm <模型名称>命令删除目标模型:ollama rm deepseek-r1:8b输出:

deleted 'deepseek-r1:8b'

⚙️ 方法二:批量删除所有模型

若需清理全部模型,可结合命令一次性删除:

ollama list | awk '{print $1}' | xargs -I {} ollama rm {}

- 作用:自动获取所有模型名称并逐一删除。

- 注意:此操作不可逆,需谨慎使用!

🗑️ 方法三:彻底卸载 Ollama(含所有数据)

如果不再需要 Ollama,可完全卸载并清理残留文件:

卸载软件

- Windows:

winget uninstall ollama - macOS (Homebrew):

brew uninstall ollama - Linux:

sudo rm /usr/local/bin/ollama sudo rm -rf /usr/share/ollama

- Windows:

删除数据目录

- 所有系统:手动删除 Ollama 的数据存储目录:

- Windows:

C:\Users\<用户名>\.ollama - macOS/Linux:

~/.ollama

rm -rf ~/.ollama # Linux/macOS - Windows:

- 所有系统:手动删除 Ollama 的数据存储目录:

⚠️ 注意事项

模型恢复

删除后模型无法恢复,需重新通过ollama pull下载。服务状态

删除模型前无需停止 Ollama 服务,但卸载软件前需终止相关进程:pkill ollama # macOS/Linux Stop-Process -Name "ollama" -Force # Windows缓存清理

若曾通过 Hugging Face 独立下载模型,需额外清理缓存:rm -rf ~/.cache/huggingface/hub/models--deepseek-ai*

✅ 验证是否删除成功

- 运行

ollama list,若无输出则说明所有模型已清除。 - 检查磁盘空间:删除后原模型占用的空间(如 4.9GB)应被释放。

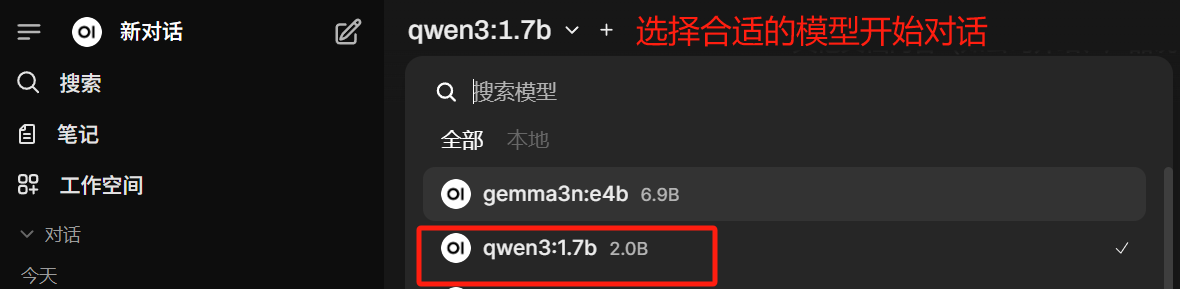

open-webui 安装 开启大模型交互

open-webui pip 安装

conda activate base

pip install open-webui

open-webui 启动服务

open-webui serve --port 8082

浏览器访问 http://IP:8082/ :

- http://IP:8082/

- 邮箱注册账号,即可通过 open-webui 开启大模型交互

❤️ 时不我待,一起学AI