@article{tang2025videofusion,

title={VideoFusion: A Spatio-Temporal Collaborative Network for Multi-modal Video Fusion and Restoration},

author={Tang, Linfeng and Wang, Yeda and Gong, Meiqi and Li, Zizhuo and Deng, Yuxin and Yi, Xunpeng and Li, Chunyu and Xu, Han and Zhang, Hao and Ma, Jiayi},

journal={arXiv preprint arXiv:2503.23359},

year={2025}

}

| 论文级别:arXvi |

| 影响因子: - |

文章目录

📖论文解读

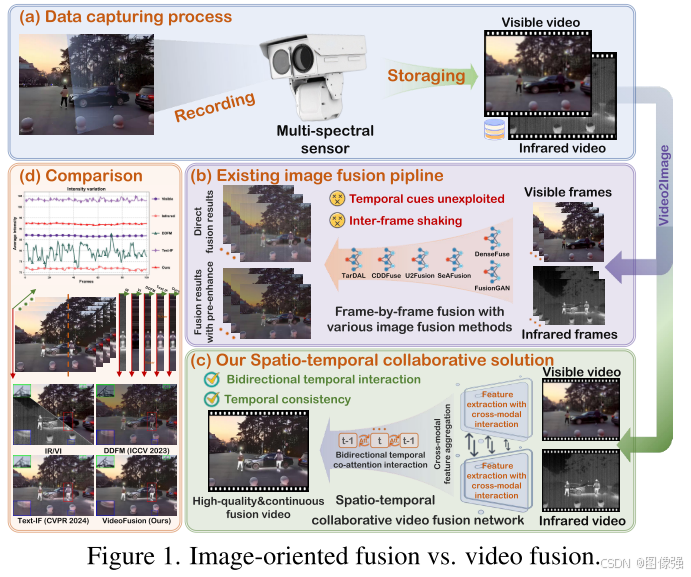

与图像相比,视频更好地与真实世界的采集场景保持一致,并具有宝贵的时间线索。然而,现有的多传感器融合研究主要是从多个图像而不是视频中整合互补的上下文。这主要源于两个因素:

1)大规模多传感器视频数据集的稀缺,限制了视频融合的研究;

2)在统一框架中联合建模空间和时间依赖性的固有困难。

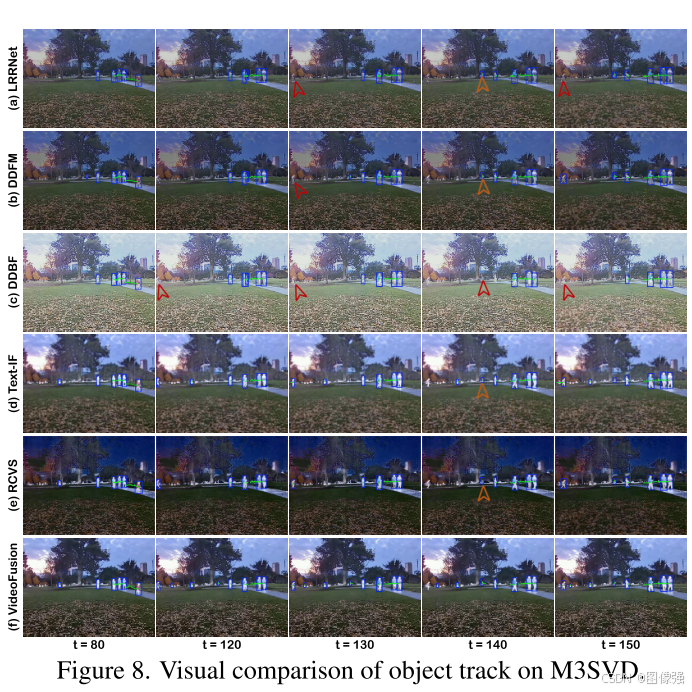

该文弥补了这一困境。首先,构建了M3SVD,一个基准数据集,包含220个时间同步和空间配准的红外-可见光视频对,包括153,797帧,填补了视频融合社区的数据缺口。

其次,提出了VideoFusion,一个多模态视频融合模型,它充分利用了跨模态互补性和时间动态性,从(可能退化的)多模态输入中生成时空相干视频。具体而言,1)为跨模态信息交互和增强开发了差分增强模块; 2)采用完整的模态引导融合策略自适应地融合多模态特征; 3)设计了双时态共注意机制,动态聚合前后向时态上下文,增强跨框架特征表示。

大量的实验表明,VideoFusion优于现有的面向图像的融合范例在连续的情况下,有效地减轻时间的不一致性和干扰。

说重点就是

以往的方法是“图像融合”,忽略了真实世界中,传感器输入的为连续图像帧,即视频。

之前没人做,是因为1)缺乏数据集,而且2)建立时空模型由困难。

1)该文发布了M3SVD,一个新的红外与可见光视频数据集;

2)提出了VideoFusion,一个用于多模态视频融合与恢复的时空协同网络。

🔑关键词

原文没有,大概是:

视频融合;

红外与可见光融合;

多模态融合;

时空协同;

💭核心思想

将传统的图像融合,更新为在真实世界中更实用的视频融合

- 不同的模式通常是互补的,但也包含冗余信息。因此,设计了一个跨模态差分增强模块,利用互补但非冗余的差分信息跨模态实现跨模态信息的交互和恢复

- 开发了一个完整的模态引导融合模块来整合增强的特征,该模块采用综合红外和可见光特征的总和作为查询来聚合跨模态互补性

- 考虑到跨帧功能可以提供动态线索,以增强场景描述,设计了一个双向的时间共同注意机制,整合信息功能,从相邻的时间帧在向前和向后的方向到当前帧。具体来说,它将前向注意力(当前帧和前一帧之间)与后向注意力(当前帧和下一帧之间)相结合,从而更好地利用时间线索进行全面的跨时间感知并保持时间一致性。

🎖️本文贡献

- 多模态多场景视频数据集(M3SVD),包括220个时间同步和空间注册的红外可见光视频与153,797帧。

- 提出了一个突破性的时空协作网络,用于红外和可见光视频融合和恢复,开创了跨模态互补和跨帧时间线索的联合建模,推进了视频融合任务。

- 设计了一个双时间的共同注意力机制与变化的一致性损失,利用向前和向后的时间线索,再加上一个差分增强模块,利用跨模态互补的背景下,强大的信息恢复和整合。

🪅相关背景知识

- 视频融合

- 图像融合

- 深度学习

- 神经网络

🪢网络结构

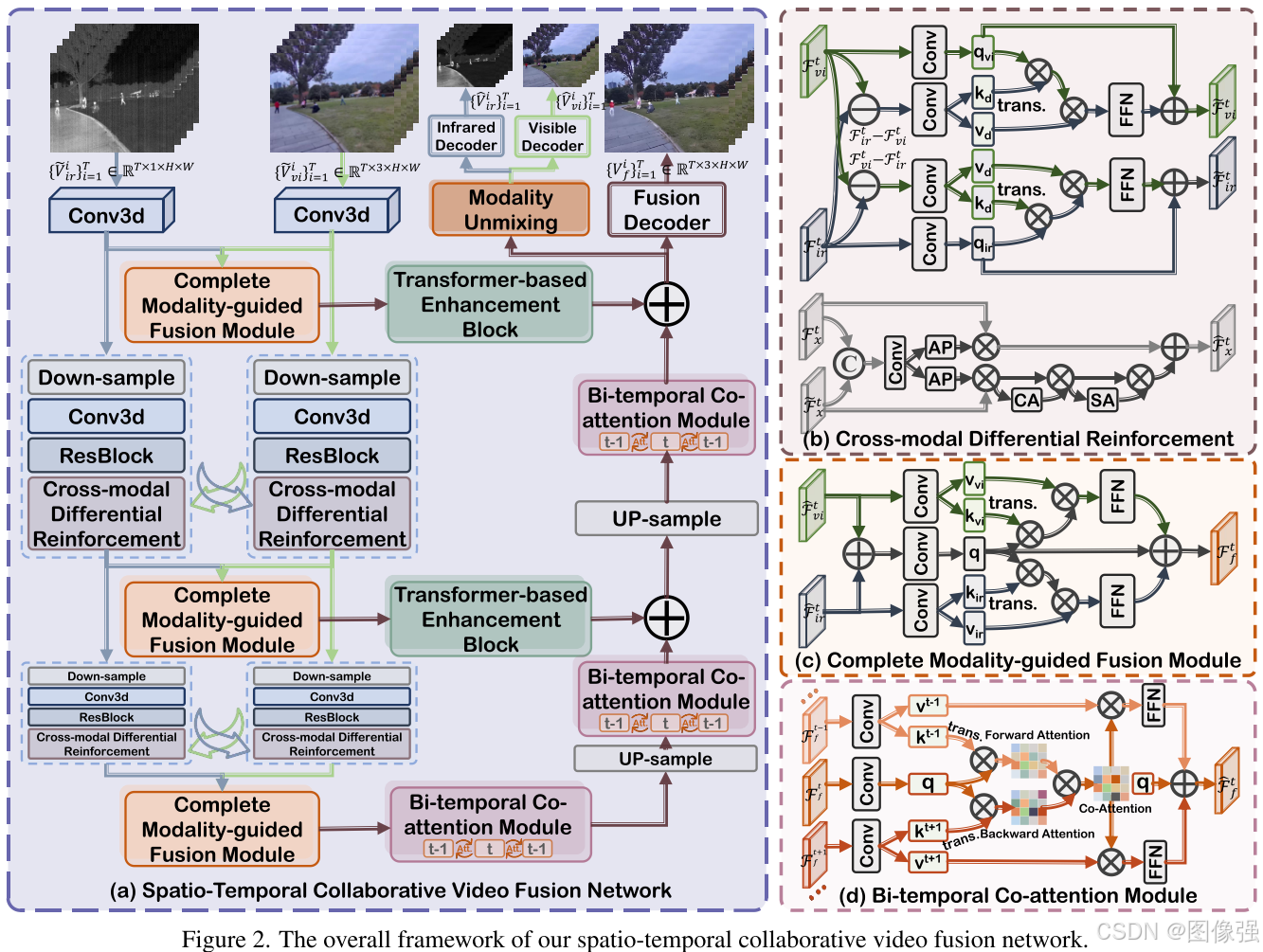

作者提出的网络结构如下所示。

图2的左边是网络的主干框架

首先,使用【三维卷积】从【低质量的】红外/可见光【视频序列】中提取【浅层特征】;

其次,【CmDRM模块】(下采样、三维卷积、残差块、跨模态差分增强模块)提取【多尺度时间特征】;CmDRM通过在特征提取过程中自适应整合互补的跨模态差分信息来增强单模态表示。

然后,【完整模态引导融合模块】(黄色的complete modality-guided fusion modules)聚合跨模态互补上下文,生成信息丰富的【多尺度融合特征】,为了加强特征表示,引入了基于Transformer的增强块(绿色的),然后在解码阶段引入了双时间共注意模块(BiCAM)(粉色的),该模块建立了超越基于conv3d的交互的动态时间依赖性。

最后,【融合解码器】(Fusion Decoder)重建高质量【融合视频】,而具有专用红外/可见光解码器的【模态解混模块】(modality unmixing module)产生恢复【无退化的红外/可见光视频】。

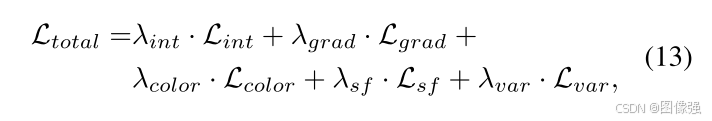

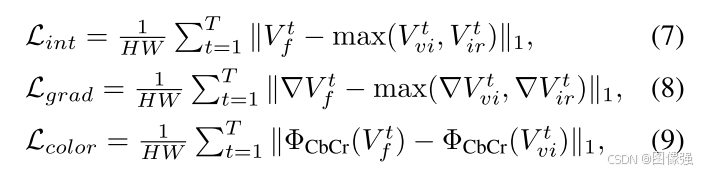

📉损失函数

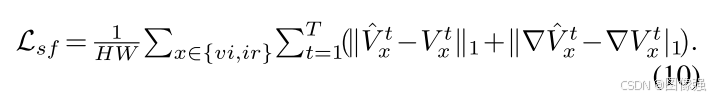

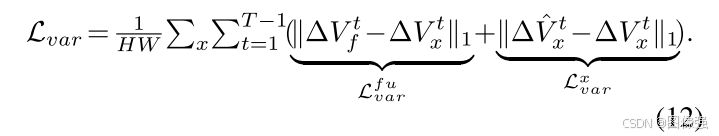

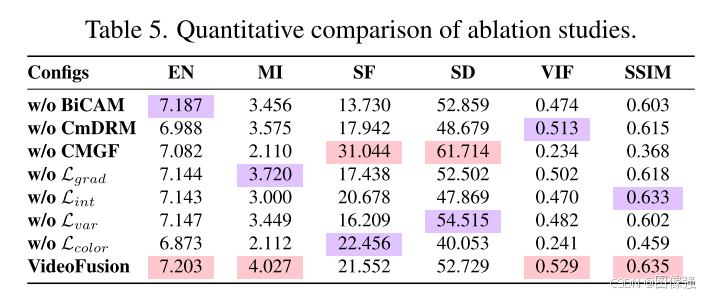

损失函数主要由强度、梯度和色彩损失构成,此外,还加入了场景保真度损失Lsf和变分一致性损失Lvar。

强度、梯度和色彩损失定义如下:

场景保真度损失定义如下:

变分一致性损失定义如下:

🔢数据集

这篇文章使用了自制的数据集M3SVD,小编已联系作者团队请求数据集,对方给出的回答是,数据集会随着论文正式发表一同公布。

图像融合数据集链接

[图像融合常用数据集整理]

🎢训练设置

网络的关键参数设为T = 7,其中N1、N2、N3分别设为2、2、4,C1、C2、C3分别设为32、64、128。 经验地将平衡各种损耗项的超参数设为λgrad = 1, λsf = 10, λint = 15, λcolor = 100, λvar = 100。使用AdamW优化器(β1 = 0.9和β2 = 0.999)训练的VideoFusion 20个epoch。 学习率初始化为1 × 10−4,并根据余弦退火计划逐渐降低到1 × 10−5。 M3SVD数据集包含200个视频,其中可见光和红外视频分别受到模糊和条纹噪声的污染。 特别是,高斯模糊的核大小为15,标准偏差均匀采样从[0.9,2.1]被用于降级可见视频。 此外,本文还引入了一种物理噪声发生器[3]来模拟红外视频中的条纹噪声。 所有实验均在pytorch平台上进行,使用NVIDIA RTX 4090 gpu和2.50 GHz Intel® Xeon® Platinum 8180 CPU。

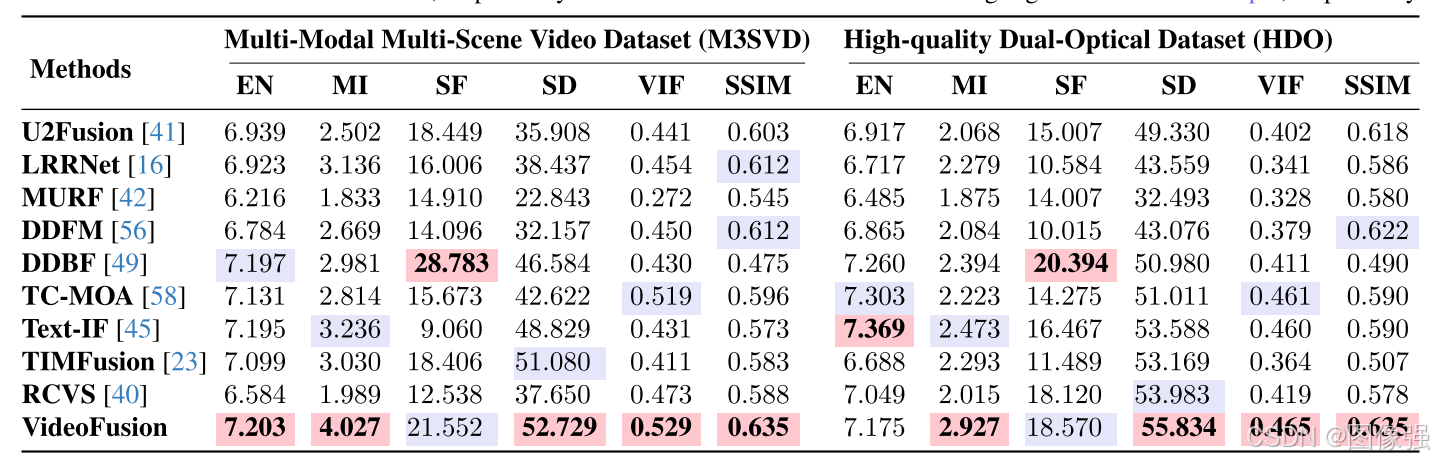

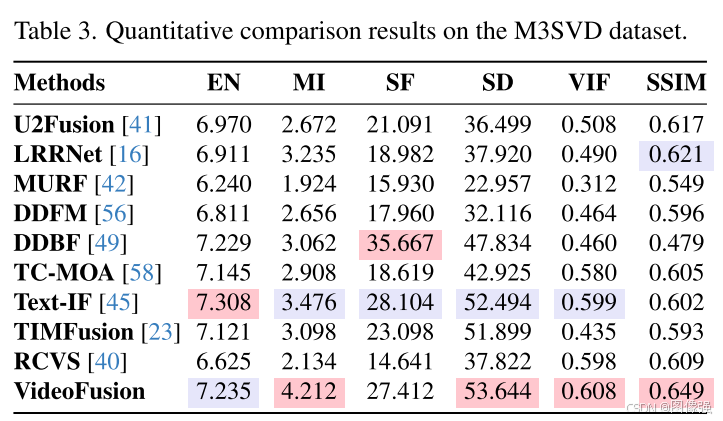

🔬实验

📏评价指标

- EN

- MI

- SF

- SD

- VIF

- SSIM

扩展学习

[图像融合定量指标分析]

🥅Baseline

- U2Fusion

- LRRNet

- MURF

- DDFM

- DDBF

- TC-MOA

- Text-IF

- TIMFusion

- RCVS

✨✨✨扩展学习✨✨✨

✨✨✨强烈推荐必看博客[图像融合论文baseline及其网络模型]✨✨✨

🔬实验结果

更多实验结果及分析可以查看原文:

📖[论文下载地址]

🧷总结体会

视频融合是IVIF向实际部署应用中的关键里程碑,非常好的一篇论文,稳稳是1区TOP期刊的水平。

🚀传送门

📑图像融合相关论文阅读笔记

📑[SMAE-Fusion: Integrating saliency-aware masked autoencoder with hybrid attention transforme]

📑[CFNet: An infrared and visible image compression fusion network]

📑[Conti-Fuse: A novel continuous decomposition-based fusion framework for infrared and visible images]

📑[SDCFusion_A semantic-driven coupled network for infrared and visible image fusion]

📑[CrossFuse: A novel cross attention mechanism based infrared and visible image fusion approach]

📑[PSFusion:Rethinking the necessity of image fusion in high-level vision tasks: A practical infrared and visible image fusion network based on progressive semantic injection and scene fidelity]

📑[SGFusion: A saliency guided deep-learning framework for pixel-level image fusion]

📑[MUFusion: A general unsupervised image fusion network based on memory unit]

📑[(TLGAN)Boosting target-level infrared and visible image fusion with regional information coordination]

📑[ReFusion: Learning Image Fusion from Reconstruction with Learnable Loss via Meta-Learning]

📑[YDTR: Infrared and Visible Image Fusion via Y-Shape Dynamic Transformer]

📑[CS2Fusion: Contrastive learning for Self-Supervised infrared and visible image fusion by estimating feature compensation map]

📑[CrossFuse: A novel cross attention mechanism based infrared and visible image fusion approach]

📑[(DIF-Net)Unsupervised Deep Image Fusion With Structure Tensor Representations]

📑[(MURF: Mutually Reinforcing Multi-Modal Image Registration and Fusion]

📑[(A Deep Learning Framework for Infrared and Visible Image Fusion Without Strict Registration]

📑[(APWNet)Real-time infrared and visible image fusion network using adaptive pixel weighting strategy]

📑[Dif-fusion: Towards high color fidelity in infrared and visible image fusion with diffusion models]

📑[Coconet: Coupled contrastive learning network with multi-level feature ensemble for multi-modality image fusion]

📑[LRRNet: A Novel Representation Learning Guided Fusion Network for Infrared and Visible Images]

📑[(DeFusion)Fusion from decomposition: A self-supervised decomposition approach for image fusion]

📑[ReCoNet: Recurrent Correction Network for Fast and Efficient Multi-modality Image Fusion]

📑[RFN-Nest: An end-to-end resid- ual fusion network for infrared and visible images]

📑[SwinFuse: A Residual Swin Transformer Fusion Network for Infrared and Visible Images]

📑[SwinFusion: Cross-domain Long-range Learning for General Image Fusion via Swin Transformer]

📑[(MFEIF)Learning a Deep Multi-Scale Feature Ensemble and an Edge-Attention Guidance for Image Fusion]

📑[DenseFuse: A fusion approach to infrared and visible images]

📑[DeepFuse: A Deep Unsupervised Approach for Exposure Fusion with Extreme Exposure Image Pair]

📑[GANMcC: A Generative Adversarial Network With Multiclassification Constraints for IVIF]

📑[DIDFuse: Deep Image Decomposition for Infrared and Visible Image Fusion]

📑[IFCNN: A general image fusion framework based on convolutional neural network]

📑[(PMGI) Rethinking the image fusion: A fast unified image fusion network based on proportional maintenance of gradient and intensity]

📑[SDNet: A Versatile Squeeze-and-Decomposition Network for Real-Time Image Fusion]

📑[DDcGAN: A Dual-Discriminator Conditional Generative Adversarial Network for Multi-Resolution Image Fusion]

📑[FusionGAN: A generative adversarial network for infrared and visible image fusion]

📑[PIAFusion: A progressive infrared and visible image fusion network based on illumination aw]

📑[CDDFuse: Correlation-Driven Dual-Branch Feature Decomposition for Multi-Modality Image Fusion]

📑[U2Fusion: A Unified Unsupervised Image Fusion Network]

📑综述[Visible and Infrared Image Fusion Using Deep Learning]

📚图像融合论文baseline总结

📑其他论文

📑[3D目标检测综述:Multi-Modal 3D Object Detection in Autonomous Driving:A Survey]

🎈其他总结

🎈[CVPR2023、ICCV2023论文题目汇总及词频统计]

✨精品文章总结

✨[图像融合论文及代码整理最全大合集]

✨[图像融合常用数据集整理]

🌻【如侵权请私信我删除】

如有疑问可联系:420269520@qq.com;

码字不易,【关注,收藏,点赞】一键三连是我持续更新的动力,祝各位早发paper,顺利毕业~