从OpenAPI到MCP服务器:AutoMCP如何让LLM工具集成自动化?

论文标题:Making REST APIs Agent-Ready: From OpenAPI to Model Context Protocol Servers for Tool-Augmented LLMs

研究背景:LLM工具集成的“插座难题”

想象一下,如果你有一个超级智能的助手(就像LLM),想让它帮你操作各种APP——比如查天气、发邮件、管理项目,你需要给它配一套“万能遥控器”。但现实是,每个APP的“接口”都不一样,你得为每个APP单独写代码让助手能看懂,这就像给每个电器都接一根独特的电线,麻烦又容易出错。

这就是LLM工具集成领域的现状:大语言模型(LLMs)已经从单纯的文本生成工具,进化成能调用外部工具完成实际任务的“智能代理”,比如订机票、分析数据等。但要让LLM顺畅地调用这些工具(比如REST API),一直是个大难题。

过去,开发者得手动写一堆“胶水代码”:把API的功能翻译成LLM能理解的格式、处理身份验证、处理请求和响应的转换……这些工作重复又繁琐,就像每次换个电器都要重新接一次线。

为了解决这个问题,Anthropic在2024年底推出了Model Context Protocol(MCP),相当于给所有工具统一了“插座标准”。MCP让工具以“服务器”的形式存在,LLM作为“客户端”可以自动发现、调用这些工具,不用再硬编码各种细节。

但新问题来了:虽然“插座标准”统一了,但造“插座”(也就是MCP服务器)的过程还是手动的。开发者还是得把现有的REST API一点点改成MCP服务器,重复写认证逻辑、参数解析等 boilerplate 代码,这让MCP本想解决的“集成难题”又绕回了原点。

论文里提到一个惊人的数据:MCP推出后6个月内,GitHub上有22,722个带MCP标签的仓库,但其中只有不到5%包含能实际运行的MCP服务器,而且这些服务器大多是单人维护的小项目,充斥着重复代码。这说明,手动构建MCP服务器已经成了LLM工具生态发展的“绊脚石”。

主要作者及单位信息

本文由三位研究者共同完成:

- Meriem Mastouri,来自美国密歇根大学弗林特分校(University of Michigan - Flint);

- Emna Ksontini,来自美国北卡罗来纳大学威尔明顿分校(University of North Carolina Wilmington);

- Wael Kessentini,来自美国德保罗大学(DePaul University)。

创新点:AutoMCP——MCP服务器的“自动造插座机”

这篇论文的最大亮点,是提出了AutoMCP——一个能自动把OpenAPI规范转换成MCP服务器的工具,就像一台“自动造插座机”,把电器的“接口图纸”(OpenAPI)直接变成符合标准的“插座”(MCP服务器)。

它的独特之处在于:

- 完全自动化:从OpenAPI规范(描述REST API的通用格式)直接生成可运行的MCP服务器,涵盖认证处理、参数解析、请求转换等所有细节,不用写一行胶水代码;

- 兼容性强:支持OpenAPI 2.0和3.0版本,能处理多种认证方式(如API key、OAuth2等);

- 修复成本低:针对OpenAPI规范中的常见问题,只需少量修改(平均每个API改19行)就能让生成成功率接近100%。

研究方法:从“数插座”到“测试插座”

为了验证AutoMCP的有效性,研究者做了三步关键工作:

第一步:摸清MCP服务器的“现状家底”

他们分析了GitHub上22,722个带MCP标签的仓库,发现只有1,164个包含能实际运行的MCP服务器。这些服务器大多是“小作坊产品”:

- 一半以上只有1个维护者;

- 代码量中位数920行,但重复的 boilerplate 代码占了很大比例;

- 82%的提交来自主维护者,团队协作很少。

这一步就像先“数清楚现在有多少个合格的插座”,证明手动造插座确实效率低、成本高。

第二步:造“自动造插座机”——AutoMCP的设计

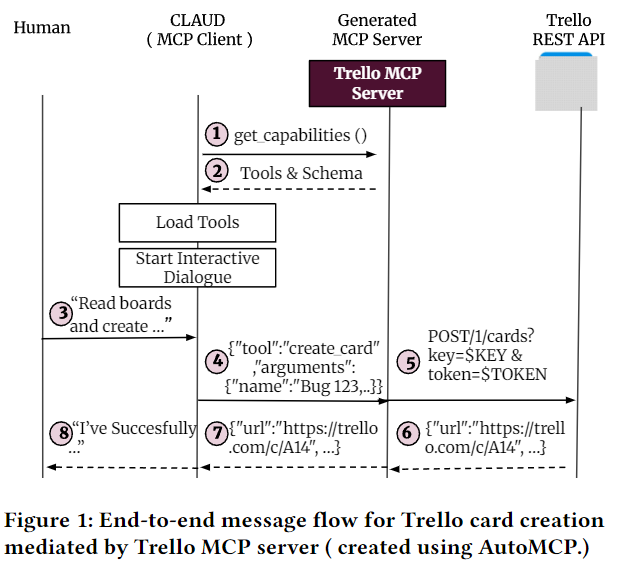

AutoMCP的工作流程很像一条生产线:

- 解析图纸:读取OpenAPI规范(支持YAML/JSON格式),处理里面的引用和版本差异;

- 处理安全门:提取认证信息(如API key位置、OAuth2流程),生成对应的环境配置和登录逻辑;

- 造插座零件:为每个API端点生成MCP工具定义,包括输入输出格式、请求转换逻辑;

- 组装成品:输出完整的MCP服务器代码,能直接运行,支持和LLM客户端(如Claude)通信。

第三步:测试“插座”好不好用

研究者用50个真实世界的API(涵盖10多个领域,共5,066个端点)测试AutoMCP:

- 从每个API中抽样测试工具调用,共1,023次;

- 初始成功率76.5%,失败原因全是OpenAPI规范的问题(如认证信息不全、URL格式错误等);

- 针对性修复后,成功率飙升至99.9%。

他们还把AutoMCP生成的服务器和17个官方手动开发的MCP服务器对比,发现AutoMCP覆盖的工具更多(14/17的案例中超过官方),但代码量却少得多(比如Resend的官方服务器有704,128行代码,AutoMCP生成的只有959行)。

主要贡献:让LLM工具集成“插电即用”

这篇论文的核心价值,可以总结为三个“减少”:

- 减少开发时间:AutoMCP自动生成MCP服务器,省去了手动写胶水代码的重复劳动。比如GitHub的官方MCP服务器要写大量手动代码,而AutoMCP只需基于OpenAPI规范一键生成;

- 减少失败概率:通过分析5类OpenAPI规范的常见问题(如安全方案缺失、URL格式错误),给出了简单的修复方法,让生成的服务器几乎不会出错;

- 减少生态瓶颈:指出MCP的推广瓶颈不是技术标准,而是规范质量,为LLM工具生态的发展指明了方向——未来重点要优化OpenAPI规范的完整性。

总结:从“手动接线”到“插电即用”

这篇论文解决了LLM工具集成中的一个关键问题:MCP服务器手动构建效率低、重复性高。通过AutoMCP,开发者可以把精力从写胶水代码转向优化API规范,让LLM调用外部工具像“插电”一样简单。

解决的主要问题:MCP作为LLM工具集成的标准,因服务器构建手动化导致推广受限;

主要成果:提出AutoMCP工具,实现从OpenAPI到MCP服务器的自动化生成,成功率近100%,并揭示了OpenAPI规范质量的重要性。

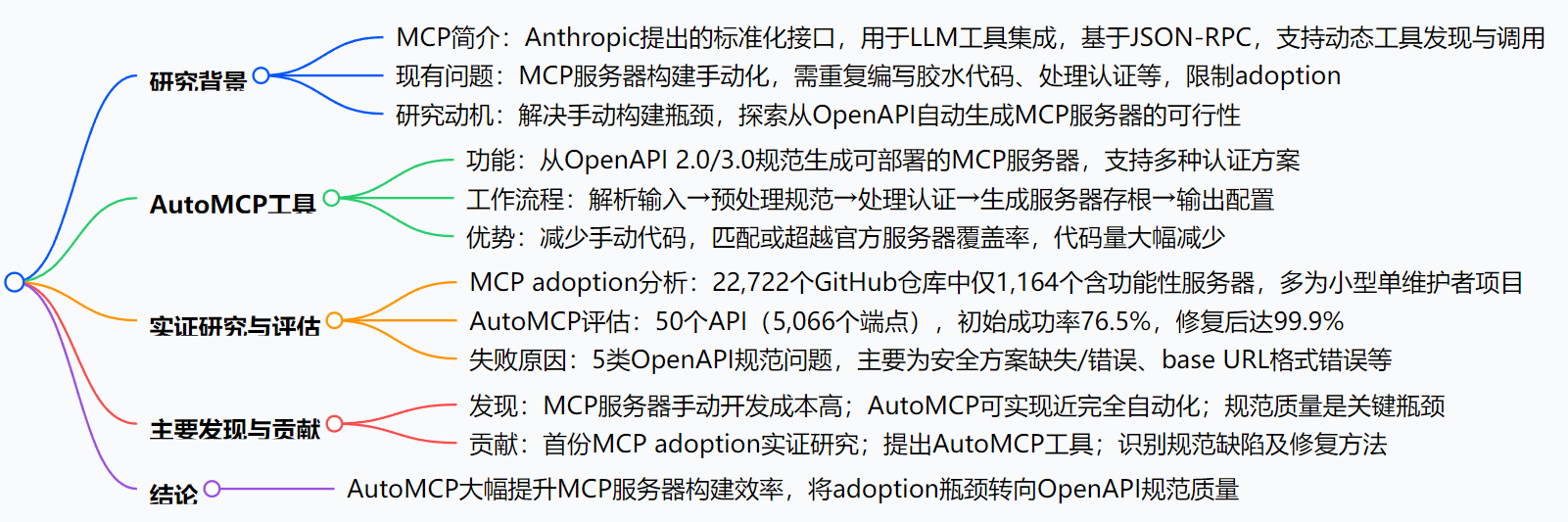

思维导图:

详细探究:

一、研究背景与动机

- MCP的提出:Anthropic于2024年末推出Model Context Protocol (MCP),作为LLM与工具集成的标准化接口,采用 schema-driven、JSON-RPC架构,支持动态工具发现与调用,旨在解决手动集成的繁琐问题。

- 现有瓶颈:MCP服务器构建仍需手动完成,开发者需转换REST端点、定义schema、处理认证等,重复且低效,限制了其adoption。

- 研究目标:探索MCP服务器构建的自动化可能性,提出解决方案并评估其有效性。

二、MCP Adoption实证研究

- 数据规模:分析2024年10月至2025年4月间22,722个含MCP标签的GitHub仓库,仅1,164个含功能性服务器。

- 服务器特征:

- 规模:中位数920行代码,8%的仓库占总代码量的42%,呈重尾分布;

- 团队:中位数1名贡献者,73%的提交集中在主维护者,工作负载高度集中;

- 开发强度:中位数每月31行代码变更,与代码规模中度相关。

三、AutoMCP设计与实现

- 核心功能:将OpenAPI 2.0/3.0规范转换为可部署的MCP服务器,解析端点、认证方案等,生成完整运行逻辑。

- 工作流程(Algorithm 1):

- 解析输入:加载OpenAPI规范(YAML/JSON);

- 预处理:统一版本、解析$ref引用、验证规范;

- 认证处理:提取安全方案,生成.env文件及OAuth处理逻辑;

- 生成存根:为每个端点创建处理函数,注册为MCP工具;

- 输出配置:生成可执行服务器代码及环境配置。

四、AutoMCP评估结果

| 项目 | 详情 |

|---|---|

| 评估对象 | 50个真实API,覆盖10+领域,共5,066个端点,基于OpenAPI 2.0/3.0规范 |

| 初始成功率 | 对1,023个抽样工具调用,76.5%(783个)成功 |

| 失败原因 | 5类OpenAPI规范问题:安全方案缺失/错误(14.4%端点)、base URL格式错误(9.7%)、端点级认证缺失(23%)、未文档化头信息(10.9%)、参数类型不匹配(0.4%) |

| 修复效果 | 平均每API修改19行规范,成功率提升至99.9%(1,022/1,023) |

| 与官方服务器对比 | 17个有官方服务器的API中,AutoMCP在82%的案例中覆盖率相当或更高,代码量减少1-4个数量级 |

五、主要结论

- MCP手动开发成本高,adoption受限,仅5%的相关仓库含功能性服务器;

- AutoMCP可实现MCP服务器近完全自动化生成,依赖OpenAPI规范质量;

- 规范缺陷可通过少量修改修复,未来瓶颈在于提升OpenAPI规范质量。

关键问题:

问题:MCP的adoption现状如何?存在哪些特点?

答案:MCP推出后6个月内,GitHub上有22,722个含MCP标签的仓库,但仅5%(1,164个)包含功能性服务器;这些服务器多为小型单维护者项目,代码量中位数920行,团队结构 lean,82%的提交由主维护者完成,开发强度较低(中位数每月31行代码变更)。问题:AutoMCP如何实现从OpenAPI到MCP服务器的自动化生成?

答案:AutoMCP通过多阶段流程实现:首先解析OpenAPI规范(支持2.0/3.0),预处理并解析$ref引用;然后提取安全方案,生成认证中间件及环境配置;接着为每个端点生成对应的MCP工具处理函数,实现JSON-RPC与HTTP请求的转换;最后输出可部署的服务器代码及配置,无需手动编写胶水代码。问题:AutoMCP生成MCP服务器失败的主要原因是什么?如何解决?

答案:失败主要源于5类OpenAPI规范问题,包括安全方案缺失/错误、base URL格式错误、端点级认证缺失、未文档化头信息及参数类型不匹配,均为规范的不一致或遗漏;通过针对性修复(如补充安全方案、修正URL、添加端点认证信息等),平均每API修改19行规范,可将成功率从76.5%提升至99.9%。

一段话总结

本文围绕Model Context Protocol (MCP) 展开研究,指出其作为LLM工具集成的标准化接口,因服务器构建手动化导致 adoption 受限。为此,提出AutoMCP工具,可从OpenAPI规范自动生成MCP服务器。通过对22,722个GitHub仓库的实证分析,发现仅5%含功能性MCP服务器,且多为小型单维护者项目;对50个真实API(共5,066个端点)的评估显示,AutoMCP初始成功率为76.5%,经修复OpenAPI规范中5类常见问题(平均每API修改19行)后,成功率提升至99.9%。研究表明,OpenAPI规范虽有质量问题,但可实现MCP服务器近完全自动化,将 adoption 瓶颈从代码生成转向规范质量。