前言:在 Linux 运维工作中,Elasticsearch 的部署与运维是高频需求——无论是快速搭建测试环境还是构建生产级集群,选择合适的安装方式(编译安装或 Yum 安装)直接影响后续维护效率。同时,日志的合理切割能避免磁盘空间溢出,而对常见报错的快速定位与解决,则是保障集群稳定运行的核心能力。

本文从实际运维场景出发,详细拆解 编译安装 和 Yum 安装的完整流程(含用户权限、证书配置、单节点/集群参数),提供 log4j2 原生策略 和 Linux logrotate 定时任务 两种日志切割方案,并汇总 Elasticsearch 部署阶段的典型报错(如连接超时、权限不足、内存限制等)及对应解决办法,助力运维人员高效完成 Elasticsearch 从部署到运维的全流程工作。

二、Elasticsearch 编译安装流程

(一)安装准备与解压操作

把 Elasticsearch 压缩包上传到 Linux 服务器后,执行如下命令完成解压与重命名:

tar -zxvf elasticsearch-8.16.0-linux-x86_64.tar.gz

mv elasticsearch-8.16.0 elasticsearch

(二)配置文件修改(elasticsearch.yml )

进入配置目录 /opt/elasticsearch/config ,编辑 elasticsearch.yml ,关键配置内容如下:

# 集群与节点标识配置

cluster.name: test-es-cluster

node.name: test-es-node-01

# 网络与访问相关设置

network.host: 0.0.0.0

http.port: 9200

# 单节点模式(必选)

discovery.type: single-node

# 以下为集群模式参数,单节点时无需开启,接入集群时取消注释并配置

# 集群节点发现,配置集群中其他节点的IP或主机名

# discovery.seed_hosts: ["node1.example.com", "node2.example.com"]

# 初始主节点选举,配置符合主节点条件的节点名称

# cluster.initial_master_nodes: ["node-1", "node-2"]

# 存储路径配置

path.data: /data1/elasticsearch/data

path.logs: /var/log/elasticsearch

# 跨域支持配置(方便前端调试)

http.cors.enabled: true

http.cors.allow-origin: "*"

http.cors.allow-credentials: true

# 安全配置(启用 SSL 与证书)

xpack.security.enabled: true

xpack.security.transport.ssl.enabled: true

xpack.security.transport.ssl.keystore.path: elastic-certificates.p13 # 自定义证书路径

xpack.security.transport.ssl.truststore.path: elastic-certificates.p13

(三)用户与目录权限配置

为保障 Elasticsearch 安全运行,需创建专用用户并赋予相应权限:

# 创建用户组

groupadd -m elasticsearch

# 创建用户(禁止登录,关联用户组 )

useradd -g elasticsearch -c "Elasticsearch Service User" -d /nonexistent -s /sbin/nologin elasticsearch

# 创建数据与日志目录

mkdir -p /data1/elasticsearch/data

mkdir -p /var/log/elasticsearch

# 递归赋予权限

chown -R elasticsearch:elasticsearch /data1/elasticsearch/data

chmod -R 750 /data1/elasticsearch/data

chown elasticsearch:elasticsearch /var/log/elasticsearch

chmod 2770 /var/log/elasticsearch

(四)证书生成与配置

借助 elasticsearch-certutil 生成证书 elastic-certificates.p13 ,操作步骤如下:

# 进入 Elasticsearch bin 目录

cd /usr/share/elasticsearch/bin

# 生成 PKCS#12 格式证书(可设置密码增强安全性,这里示例设置密码为 TestCertPass123! )

./elasticsearch-certutil cert --out elastic-certificates.p13 --pass "TestCertPass123!"

# 移动证书到配置目录并赋予权限

mv elastic-certificates.p13 /opt/elasticsearch/config/

chown elasticsearch:elasticsearch /opt/elasticsearch/config/elastic-certificates.p13

chmod 600 /opt/elasticsearch/config/elastic-certificates.p13

(五)服务启动与验证

# 切换至 elasticsearch 用户(避免权限问题 )

su - elasticsearch -s /bin/bash

# 启动服务(前台运行便于调试,生产环境建议后台启动 )

/opt/elasticsearch/bin/elasticsearch

# 验证集群状态(新开终端执行 )

curl -u elastic:your_password http://localhost:9200 # your_password 需替换为实际设置密码

三、Elasticsearch Yum 安装流程(以 8.5.2 版本为例)

(一)Yum 仓库配置

# 导入 Elasticsearch GPG 密钥

rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

# 创建 Yum 仓库文件

cat <<EOF > /etc/yum.repos.d/elasticsearch.repo

[elasticsearch-8.x]

name=Elasticsearch repository for 8.x packages

baseurl=https://artifacts.elastic.co/packages/8.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md

EOF

(二)安装与基础配置

# 安装指定版本

yum install -y elasticsearch-8.5.2

# 编辑配置文件 /etc/elasticsearch/elasticsearch.yml ,默认生成部分配置如下(可结合实际调整):

# 集群与节点标识

cluster.name: test-es-cluster

node.name: test-es-node-01

# 网络与访问

network.host: 0.0.0.0

http.port: 9200

# 单节点模式(必选)

discovery.type: single-node

# 以下为集群模式参数,单节点时无需开启,接入集群时取消注释并配置

# 集群节点发现,配置集群中其他节点的IP或主机名

# discovery.seed_hosts: ["node1.example.com", "node2.example.com"]

# 初始主节点选举,配置符合主节点条件的节点名称

# cluster.initial_master_nodes: ["node-1", "node-2"]

# 存储路径

path.data: /data1/elasticsearch/data

path.logs: /var/log/elasticsearch

# 跨域支持

http.cors.enabled: true

http.cors.allow-origin: "*"

http.cors.allow-credentials: true

# 安全配置(使用 Yum 安装默认生成的证书 )

xpack.security.enabled: true

xpack.security.transport.ssl.enabled: true

xpack.security.transport.ssl.keystore.path: /etc/elasticsearch/elastic-certificates.p12

xpack.security.transport.ssl.truststore.path: /etc/elasticsearch/elastic-certificates.p12

xpack.security.http.ssl.enabled: false # 测试环境简化,生产环境建议启用

(三)服务启动与密码初始化、重置

# 启动服务

systemctl start elasticsearch

# 初始化内置用户密码(交互模式 )

/usr/share/elasticsearch/bin/elasticsearch-setup-passwords interactive

# 重置密码操作(若需要重置 elastic 用户密码 )

sudo ./elasticsearch-reset-password -u elastic -i

# 验证集群状态

curl -u elastic:your_password http://localhost:9200 # your_password 替换为实际设置密码

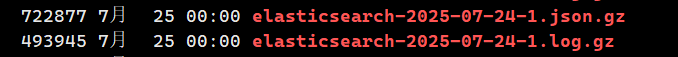

四、日志切割配置方案

(一)方案一:基于 log4j2.properties 的独立策略(日志和 JSON 分别保留 )

1. 配置文件修改(log4j2.properties)

# ==================== 处理 JSON 日志(.json.gz) ====================

# 已有参数(保留默认,无需修改)

appender.json_rolling.type = RollingFile

appender.json_rolling.name = json_rolling

appender.json_rolling.fileName = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}_server.json

appender.json_rolling.layout.type = ESJsonLayout

# 新增/修改参数(实现 30 天保留)

appender.json_rolling.filePattern = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}_server-%d{yyyy-MM-dd}-%i.json.gz

# 时间滚动:每天 1 次

appender.json_rolling.policies.time.type = TimeBasedTriggeringPolicy

appender.json_rolling.policies.time.interval = 1

appender.json_rolling.policies.time.modulate = true

# 大小滚动(可选):超过 1GB 分割

appender.json_rolling.policies.size.type = SizeBasedTriggeringPolicy

appender.json_rolling.policies.size.size = 1GB

# 自动删除:保留 30 天

appender.json_rolling.strategy.type = DefaultRolloverStrategy

appender.json_rolling.strategy.action.type = Delete

appender.json_rolling.strategy.action.condition.type = IfFileName

appender.json_rolling.strategy.action.condition.glob = ${sys:es.logs.cluster.name}_server-*.json.gz

appender.json_rolling.strategy.action.condition.nested_condition.type = IfLastModified

appender.json_rolling.strategy.action.condition.nested_condition.age = 30d

# ==================== 处理文本日志(.log.gz) ====================

# 已有参数(保留默认,无需修改)

appender.log_rolling.type = RollingFile

appender.log_rolling.name = log_rolling

appender.log_rolling.fileName = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}.log

appender.log_rolling.layout.type = PatternLayout

appender.log_rolling.layout.pattern = [%d{ISO8601}][%-5p][%-25c{1}] %m%n

# 新增/修改参数(实现 30 天保留)

appender.log_rolling.filePattern = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}-%d{yyyy-MM-dd}-%i.log.gz

# 时间滚动:每天 1 次

appender.log_rolling.policies.time.type = TimeBasedTriggeringPolicy

appender.log_rolling.policies.time.interval = 1

appender.log_rolling.policies.time.modulate = true

# 大小滚动(可选):超过 1GB 分割

appender.log_rolling.policies.size.type = SizeBasedTriggeringPolicy

appender.log_rolling.policies.size.size = 1GB

# 自动删除:保留 30 天

appender.log_rolling.strategy.type = DefaultRolloverStrategy

appender.log_rolling.strategy.action.type = Delete

appender.log_rolling.strategy.action.condition.type = IfFileName

appender.log_rolling.strategy.action.condition.glob = ${sys:es.logs.cluster.name}-*.log.gz

appender.log_rolling.strategy.action.condition.nested_condition.type = IfLastModified

appender.log_rolling.strategy.action.condition.nested_condition.age = 30d

# 引用 Appender(确保已配置)

rootLogger.appenderRef.json_rolling.ref = json_rolling

rootLogger.appenderRef.log_rolling.ref = log_rolling

2. 使配置生效的操作

# 1. 备份原配置

cp /etc/elasticsearch/log4j2.properties /etc/elasticsearch/log4j2.properties.bak_$(date +%F)

# 2. 编辑配置文件(替换为上述内容)

vi /etc/elasticsearch/log4j2.properties

# 3. 重启 Elasticsearch 服务

systemctl restart elasticsearch

# 4. 验证配置是否生效(查看日志是否正常滚动)

tail -f /var/log/elasticsearch/${sys:es.logs.cluster.name}.log # 替换为实际集群名称

(二)方案二:合并策略(同时保留日志和 JSON 文件 1 个月 )

1. 配置文件修改(log4j2.properties)

# ==================== 合并滚动与删除策略 ====================

# 以文本日志 Appender 为例(JSON 日志可复用此策略)

appender.rolling.type = RollingFile

appender.rolling.name = rolling

appender.rolling.fileName = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}.log

appender.rolling.filePattern = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}-%d{yyyy-MM-dd}-%i.log.gz

appender.rolling.layout.type = PatternLayout

appender.rolling.layout.pattern = [%d{ISO8601}][%-5p][%-25c{1}] %m%n

# 时间滚动:每天 1 次

appender.rolling.policies.time.type = TimeBasedTriggeringPolicy

appender.rolling.policies.time.interval = 1

appender.rolling.policies.time.modulate = true

# 大小滚动(可选):超过 1GB 分割

appender.rolling.policies.size.type = SizeBasedTriggeringPolicy

appender.rolling.policies.size.size = 1GB

# 合并删除策略(同时处理 .log.gz 和 .json.gz)

appender.rolling.strategy.type = DefaultRolloverStrategy

appender.rolling.strategy.action.type = Delete

appender.rolling.strategy.action.condition.type = IfFileName

# 匹配两种格式的日志文件

appender.rolling.strategy.action.condition.glob = ${sys:es.logs.cluster.name}-*.log.gz, ${sys:es.logs.cluster.name}_server-*.json.gz

# 保留 30 天

appender.rolling.strategy.action.condition.nested_condition.type = IfLastModified

appender.rolling.strategy.action.condition.nested_condition.age = 30d

# JSON 日志 Appender(复用上述删除策略,仅需配置基础输出)

appender.json_rolling.type = RollingFile

appender.json_rolling.name = json_rolling

appender.json_rolling.fileName = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}_server.json

appender.json_rolling.filePattern = ${sys:es.logs.base_path}/${sys:es.logs.cluster.name}_server-%d{yyyy-MM-dd}-%i.json.gz

appender.json_rolling.layout.type = ESJsonLayout

# 复用滚动策略(时间和大小参数与文本日志一致)

appender.json_rolling.policies.time.type = TimeBasedTriggeringPolicy

appender.json_rolling.policies.time.interval = 1

appender.json_rolling.policies.time.modulate = true

appender.json_rolling.policies.size.type = SizeBasedTriggeringPolicy

appender.json_rolling.policies.size.size = 1GB

# 引用 Appender

rootLogger.appenderRef.rolling.ref = rolling

rootLogger.appenderRef.json_rolling.ref = json_rolling

2. 生效操作

和方案一类似,修改配置后重启 Elasticsearch 服务进行验证即可。

(三)方案三:Linux logrotate 定时任务

1. 创建 logrotate 配置文件

vi /etc/logrotate.d/elasticsearch

添加如下内容:

/var/log/elasticsearch/*.log /var/log/elasticsearch/*.json {

daily # 每天进行轮转操作

rotate 30 # 保留 30 天的文件

compress # 压缩为 .gz 格式

delaycompress # 延迟压缩

missingok # 忽略不存在的文件

notifempty # 空文件不进行轮转

create 0640 elasticsearch elasticsearch # 新建文件的权限与属主设置

su elasticsearch elasticsearch # 以 elasticsearch 用户身份执行

}

2. 生效操作

# 验证配置语法是否正确

logrotate -d /etc/logrotate.d/elasticsearch

# 手动执行一次轮转操作

logrotate -f /etc/logrotate.d/elasticsearch

# 检查定时任务(系统默认每天执行 )

cat /etc/cron.daily/logrotate

五、典型报错处理

(一)报错场景 1:curl: (52) Empty reply from server

1. 报错场景复现

使用默认生成的配置启动 Elasticsearch 后,执行 curl http://172.20.0.3:9200 出现报错:

curl: (52) Empty reply from server

2. 原因分析

- 安全配置冲突:默认生成的配置里,

xpack.security.http.ssl.enabled: true启用了 HTTP 层 SSL,但未正确配置证书或者客户端未使用 HTTPS 访问,进而导致连接被拒绝。 - 服务未正常启动:Elasticsearch 由于权限、路径或者配置错误,未能正常启动,无法返回响应。

3. 解决方案(修改为合理配置后恢复)

(1)调整安全配置(关闭 HTTP 层 SSL,简化测试环境)

在 elasticsearch.yml 中添加如下配置:

xpack.security.http.ssl.enabled: false

(2)重启服务并验证

systemctl restart elasticsearch

curl -u elastic:your_password http://172.20.0.3:9200 # your_password 替换为实际密码

(3)关键对比(默认配置 vs 修改后配置)

| 配置项 | 默认生成(报错情况) | 修改后(恢复正常) |

|---|---|---|

xpack.security.http.ssl.enabled |

true(启用 HTTP 层 SSL) |

false(关闭 HTTP 层 SSL) |

| 访问方式 | 需用 https:// 且携带证书 |

直接用 http:// 加账号密码 |

(二)报错场景 2:max virtual memory areas vm.max_map_count [65530] is too low, increase to at least [262144]

1. 报错场景复现

启动 Elasticsearch 时,日志中出现如下报错:

[1]: max virtual memory areas vm.max_map_count [65530] is too low, increase to at least [262144]

2. 原因分析

Elasticsearch 需要较大的虚拟内存映射区域来存储索引数据,Linux 系统默认的 vm.max_map_count(虚拟内存映射数量上限)为 65530,无法满足 Elasticsearch 的运行要求(至少需要 262144)。

3. 解决方案

(1)临时调整(立即生效,重启后失效)

sudo sysctl -w vm.max_map_count=262144

(2)永久调整(重启系统后仍生效)

# 编辑系统配置文件

sudo vi /etc/sysctl.conf

# 添加以下内容

vm.max_map_count=262144

# 使配置生效

sudo sysctl -p

(3)验证配置

sysctl vm.max_map_count

# 输出 "vm.max_map_count = 262144" 即生效

(4)重启 Elasticsearch

systemctl restart elasticsearch

(三)报错场景 3:ElasticsearchException[failed to bind service]; nested: AccessDeniedException[/data1/elasticsearch/data]

1. 报错场景复现

启动 Elasticsearch 时,日志中出现权限相关报错:

ElasticsearchException[failed to bind service]; nested: AccessDeniedException[/data1/elasticsearch/data]

2. 原因分析

Elasticsearch 运行用户(通常为 elasticsearch)对数据目录(如 /data1/elasticsearch/data)没有读写权限,导致无法绑定服务并初始化数据存储。

3. 解决方案

(1)检查目录权限

ls -ld /data1/elasticsearch/data

# 若输出的所有者/组不是 elasticsearch,需执行以下命令

(2)赋予目录权限

# 递归修改目录所有者为 elasticsearch 用户和组

sudo chown -R elasticsearch:elasticsearch /data1/elasticsearch/data

# 赋予读写执行权限(用户可读写执行,组内可读执行,其他无权限)

sudo chmod -R 750 /data1/elasticsearch/data

(3)重启 Elasticsearch

systemctl restart elasticsearch

(四)报错场景 4:curl: (6) Could not resolve host: localhost; Name or service not known

1. 报错场景复现

执行 curl http://localhost:9200 验证集群时,出现主机解析报错:

curl: (6) Could not resolve host: localhost; Name or service not known

2. 原因分析

系统 hosts 文件中未配置 localhost 与 127.0.0.1 的映射关系,导致无法解析 localhost 主机名。

3. 解决方案

(1)编辑 hosts 文件

sudo vi /etc/hosts

(2)添加映射关系

在文件中添加以下内容:

127.0.0.1 localhost

(3)验证解析

ping localhost

# 若能正常 ping 通,说明解析生效

(4)重新验证 Elasticsearch

curl -u elastic:your_password http://localhost:9200

(五)报错场景 5:Cluster health status is red (all shards down)

1. 报错场景复现

执行集群健康检查时,状态为红色:

curl -u elastic:your_password http://localhost:9200/_cluster/health

# 输出中包含 "status" : "red"

2. 原因分析

红色状态表示至少有一个主分片未分配(可能因节点故障、索引损坏或磁盘空间不足导致)。单节点环境中,若索引分片未正常初始化,也可能出现此问题。

3. 解决方案

(1)检查磁盘空间

df -h /data1/elasticsearch/data

# 若磁盘使用率接近 100%,需清理空间

(2)查看未分配分片原因

curl -u elastic:your_password "http://localhost:9200/_cluster/allocation/explain?pretty"

(3)单节点环境特殊处理(仅测试环境)

若为单节点且无需高可用,可调整索引默认分片配置(新建索引生效):

# 创建索引模板,设置主分片为 1,副本分片为 0(单节点无法分配副本)

curl -u elastic:your_password -XPUT "http://localhost:9200/_index_template/default_template" -H "Content-Type: application/json" -d '

{

"index_patterns": ["*"],

"template": {

"settings": {

"number_of_shards": 1,

"number_of_replicas": 0

}

}

}'

(4)重启集群(必要时)

systemctl restart elasticsearch

Elasticsearch 报错多与 配置冲突、权限不足、系统参数限制 或 资源不足 相关。排查时可优先查看日志文件(如 /var/log/elasticsearch/test-es-cluster.log),根据具体报错信息定位原因,再通过调整配置、权限或系统参数解决。对于集群状态类问题,可结合 _cluster/health 和 _cluster/allocation/explain 等 API 深入分析。

六、总结

本文全面对比了 Elasticsearch 编译安装与 Yum 安装的流程,提供了三种日志切割方案(log4j2 独立策略、合并策略、logrotate 定时任务 ),并深入分析了典型报错的原因与解决方法。通过灵活选用安装方式和日志管理策略,结合精准的报错排查,能够高效搭建稳定、安全的 Elasticsearch 集群,满足不同环境的部署需求。希望这份内容能帮助大家清晰梳理 Elasticsearch 部署全流程,若有更多细节需求或实践疑问,欢迎进一步交流探讨!