在人工智能奔腾的2025年,WAIC(世界人工智能大会)释放出一个明确信号:视频能力已经成为通往“远程智能”的神经中枢。在无人机、四足机器人、远程施工、巡检等新兴场景中,一套可靠、低延迟、可嵌入头显设备的视频传输系统,正成为 AI 系统眼中的“关键器官”。

今天,我们以 大牛直播SDK × 头显设备(Pico/Quest)× 远程智能操控场景 为核心,深入剖析一条从实时感知到远程决策的闭环路径,探讨视频传输能力如何成为 AI 控制链条中的基础设施。

一、🌍 时代背景:智能体 + 远程感知,进入头显协作新时代

在本届 WAIC 2025 上,最吸引人关注的关键词不是“AGI”,而是:

“多模态感知 + 实时协作 + 虚实融合控制”

智能体不再是孤立运行的节点,而是逐步演化为具身智能系统中的一部分,依托于网络通信、视频感知、触觉反馈、动作控制等多模态通道,实现与远程操作者的实时联动与深度协作。

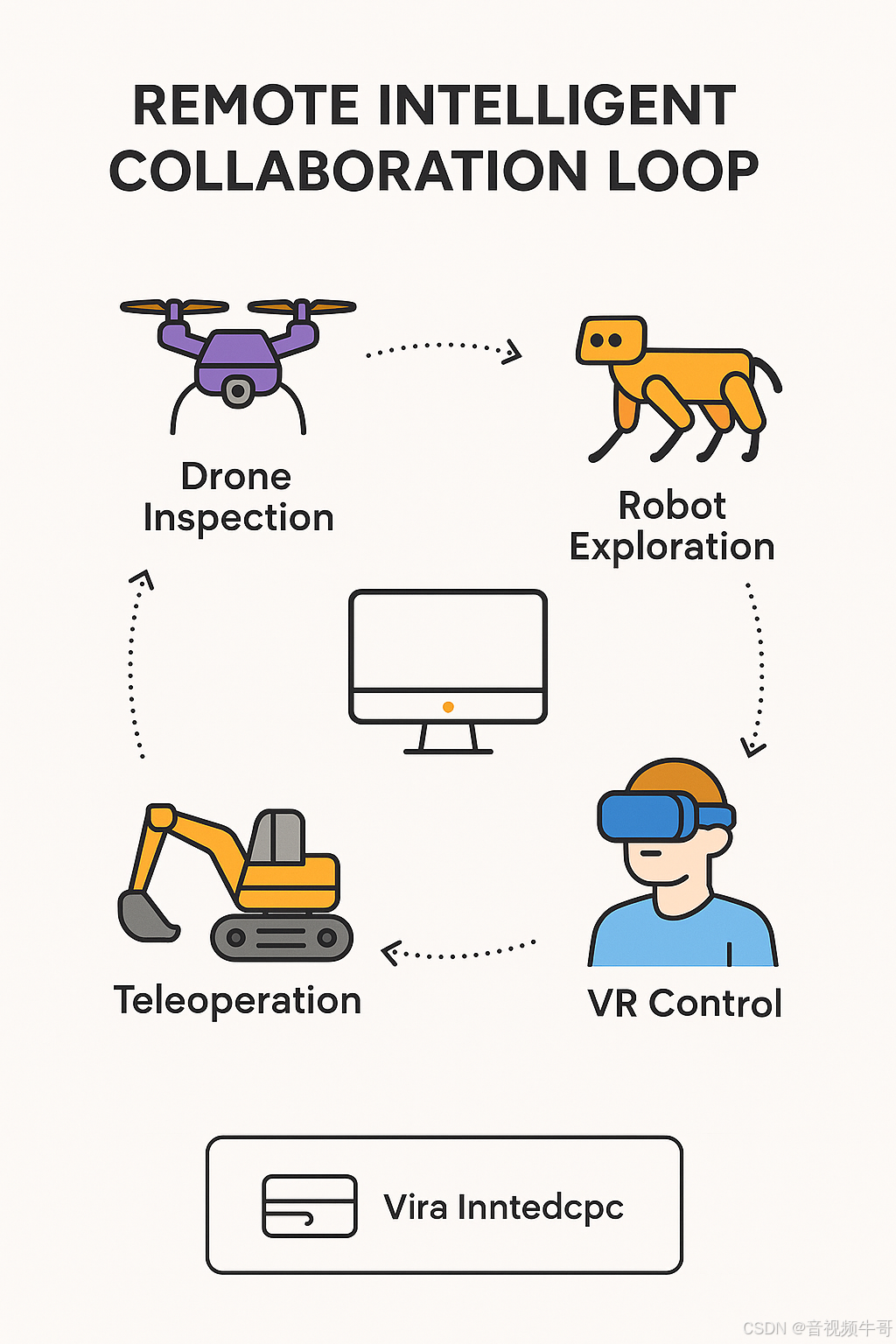

🚁 无人机远程巡检

无人机不只是飞行平台,更是高空智能“观察者”。在山火探测、灾后勘察、桥梁检查等场景中,通过 RTSP/RTMP 实时推送高清画面至地面指挥中心,远程操控者借助头显设备以“第一视角”进行画面巡查与路径调整,必要时可快速切换飞控权限进行干预。低延迟视频链路是及时响应、精准决策的前提。

🐾 四足机器人进入复杂环境

在电力管廊、地下管网、震后废墟等高危空间,四足机器人成为最理想的探测/作业单元。远程操作者通过 VR 头显查看实时画面,并结合 AI 分析结果下达操作指令,如拾取物体、规避障碍、调整姿态等。此过程中,视频数据不仅服务人眼,还作为 AI 行为感知模型的原始输入,稳定 + 可控 + 低延迟的视频成为闭环关键。

🏗 远程精细操控作业

电铲、挖掘机、机械臂等工程装备,在某些危险或远程区域需由经验丰富的操作者进行远距控制。操作者佩戴 Pico 或 Quest 头显,通过低延迟 RTMP 视频流“身临其境”地观察作业环境,并结合动作捕捉与触控反馈完成高精度操作。视频延迟直接影响作业精度与安全性,不能超过人眼可容忍的感知阈值(一般在 200ms 以下)。

🚧 危险场景下的人类视觉代理

在核电站巡检、易燃爆仓库、深井等高危区域,操作人员无法亲临现场,但任务又必须“人工判断”。此时,机器人通过高清摄像头与传感器采集一线信息,大牛直播SDK将视频实时推送到头显设备中,让远程人员“身临其境”,进行判断、下达指令或接管控制,实现远程“虚拟亲临”。

这一切应用背后,共同指向一个不可动摇的技术基石:

高帧率 + 低延迟 + 异构网络适配 + 多协议兼容的视频实时传输能力,是远程智能协作的“视觉神经”。**

而这正是大牛直播SDK在各大远程智能系统中持续发力的方向 —— 从终端设备采集、协议转换,到跨平台播放与 Unity 嵌入,构建真正可落地、可部署的远程视觉闭环。

二、🔧 技术挑战:为什么“视频上头显”很难?

尽管“在头显设备中观看实时视频流”听起来是一个直观的应用,但要实现真正流畅、低延迟、无眩晕的体验,在实际工程中却面临诸多挑战,特别是在无人机远程控制、四足机器人操控、重型机械远程施工等对响应时间极其敏感的场景中,视频系统往往成为性能瓶颈和系统瓶颈的交汇点。

📊 常见技术挑战与底层难点

| 技术挑战 | 底层难点分析 |

|---|---|

| ⏱ 端到端延迟过高 | 视频采集 → 编码 → 推流 → 解码 → 渲染 → 显示链路复杂,任一环节延时堆积都可能引发“操控滞后”或“头晕眩晕”问题。头显设备对延迟非常敏感,一般要求控制在 200ms以内,但传统播放器方案(如FFmpeg+Unity插件)容易超过此阈值。 |

| 🖥 Unity渲染瓶颈 | Unity 本身对外部纹理支持有限,若未使用 OES/SurfaceTexture 等原生机制,容易引发 CPU→GPU 纹理传输瓶颈,导致渲染掉帧、画面撕裂等问题,直接影响沉浸体验。 |

| 📶 弱网环境下稳定性差 | 户外飞行、工地、山区等实际场景中网络抖动、丢包频繁,常规播放器容易出现花屏、断流、音画不同步等异常,缺乏鲁棒性的协议适配与自适应策略。 |

| 🧩 多协议/多格式兼容难 | 视频源可能来自无人机(RTSP)、边缘服务器(RTMP),若播放器不具备灵活协议支持与快速切换能力,将限制系统扩展性和部署灵活性。 |

| 🎛 缺乏精准控制接口 | 远程操控类应用要求播放器支持精细接口,如:播放精确控制、YUV/RGB 数据回调、延迟统计、异常捕获等,传统播放器或开源方案支持有限。 |

| 🧠 头显设备异构适配复杂 | 市面上头显设备硬件平台差异极大,要实现跨平台稳定运行,播放器需封装良好、接口清晰、兼容性强。 |

📌 举例说明:传统方案在头显播放中常见问题

FFmpeg 播放器 → 纹理上传方式不兼容 Unity,需逐帧拷贝 → 帧率下降严重

VLC 嵌入方案 → 无法控制播放延迟 → 操控动作和画面不同步

✅ 小结:头显 ≠ 屏幕,视频播放能力必须“原生化 + 可控化 + 高性能化”

要在头显设备中实现工业级视频播放体验,绝不能只是“能播出来”,而是要做到:

极低的端到端延迟(<200ms)

无额外 CPU-GPU 拷贝的高效纹理通路

自动适应网络波动的稳定播放

与操控链路高度同步的播放节奏

Unity / 原生系统下的多平台适配与封装

三、🚀 解决方案:大牛直播SDK × Unity × Pico/Quest 的超低延迟播放架构

面对“视频上头显”在延迟控制、渲染效率、平台适配等方面的多重挑战,大牛直播SDK 提供了一套经大量实战验证的完整解决方案 —— 从协议接入到 Unity 渲染,从原生纹理共享到跨平台适配,构建起一个可插拔、低延迟、高并发、可控可调的视频播放能力闭环,特别适用于 Pico、Quest 等主流 VR 设备。

🧠 架构总览:从码流到画面,一站式链路优化

[远端设备输出] → RTSP/RTMP/SRT → [大牛直播SDK] → [原生解码 + OES纹理] → [Unity中 Texture 显示] → Pico/Quest头显| 阶段 | 关键技术手段 | 延迟优化方式 |

|---|---|---|

| 视频接入 | 多协议支持(RTSP、RTMP、SRT、HLS 等) | 最短路径接入,裸流直解 |

| 解码处理 | 内置 Android MediaCodec / 硬解 FFmpeg | 避免中间缓存堆积,帧间调度精细 |

| 纹理上传 | OES + SurfaceTexture 纹理共享 | 避免 CPU → GPU 拷贝 |

| Unity 显示 | Unity 插件绑定 ExternalTexture | 原生帧对帧同步,延迟最小化 |

| 控制交互 | 播放控制接口 / 延迟回调 / 状态同步 | 实时反馈播放状态,便于操控协调 |

✅ 核心能力一:多协议直通,兼容工业设备

🛠 支持多种输入协议:RTSP(主流摄像头/无人机)、RTMP(边缘推流等;

🔌 协议栈内建且高度可控,无需依赖外部播放器,开箱即用;

🔄 可动态切换源,适配巡检/多路视角切换场景。

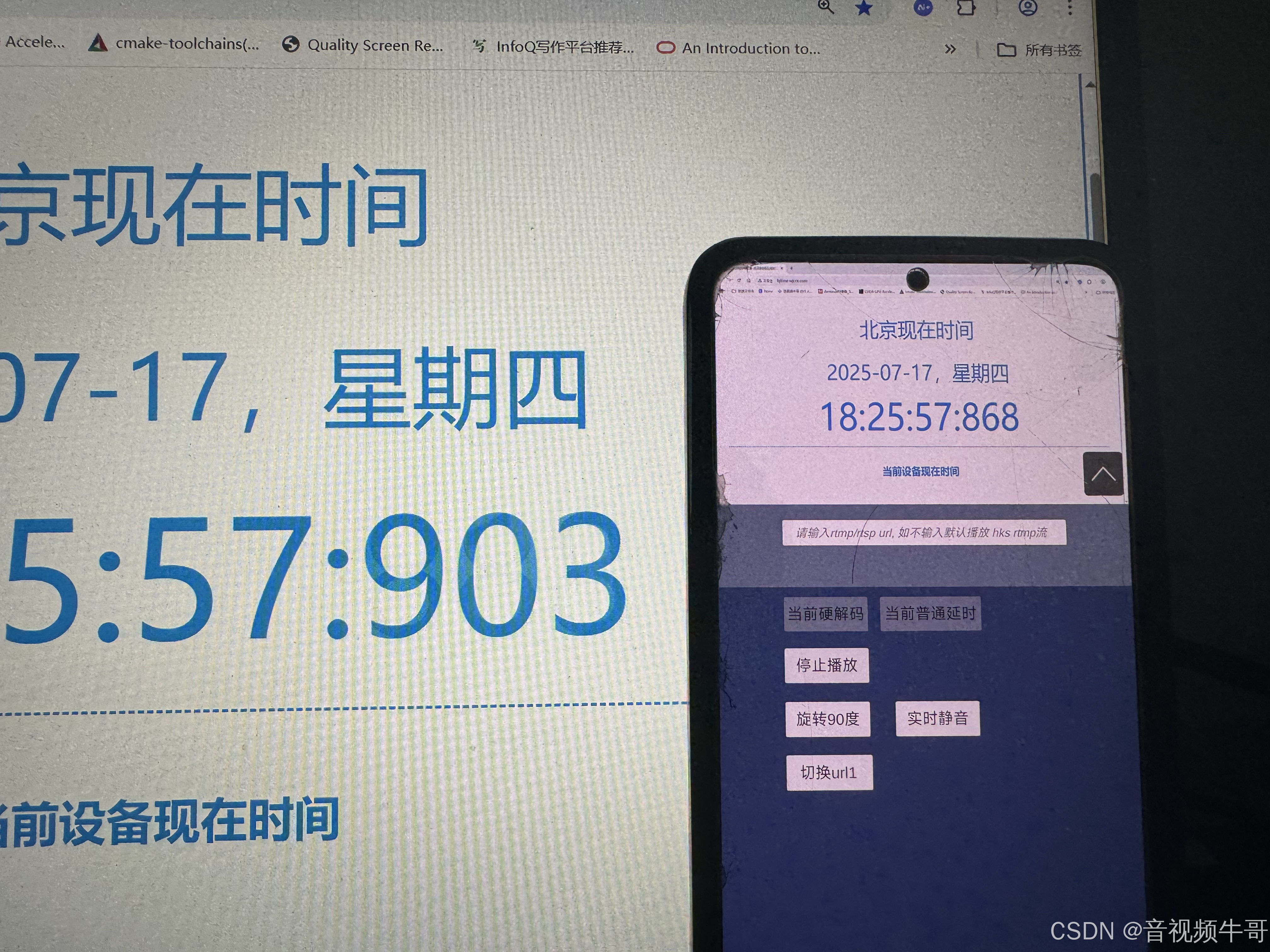

✅ 核心能力二:低延迟链路级优化

Android平台Unity共享纹理模式RTMP播放延迟测试

⏱ 端到端延迟可压缩至 100ms~250ms,有效解决“视觉滞后”问题;

📦 内置自适应解码缓冲机制,应对弱网丢帧、码率不稳定情况;

🧊 无缓存模式(Zero Buffer Mode)支持,极端场景下实时渲染。

✅ 核心能力三:Unity 插件 + 原生纹理协作

🔧 提供完整 Unity 插件库和demo示例代码;

🔁 使用 Android SurfaceTexture + ExternalTextureID 实现原生视频帧 → Unity 显示纹理的零拷贝渲染;

🎮 上层APP可以做逻辑开发,适配各类头显交互需求。

四、🎮 典型场景落地:头显 × 视频 × 控制的“远程闭环”

| 场景类型 | 视频方案价值 |

|---|---|

| 🚁 无人机图传 | 通过 RTSP 推流,实时在 Pico 头显中低延迟预览,搭配陀螺仪控制视角,提升操作沉浸感 |

| 🐾 四足机器人巡检 | 实时画面上屏,AI 检测异常后远程操控人员接管,可实现远程步态导航与任务控制 |

| 🏗 远程机械控制 | 利用 RTMP 推流至局域网控制中心,头显人员通过手柄与姿态感应控制大型机械臂操作 |

| 🧠 AI+VR 协作决策 | 多头显协同查看实时现场画面,辅助调度/部署决策,结合语音/文字交互实现联合响应 |

五、📦 模块结构:大牛直播SDK 视频能力如何嵌入远程智能系统?

在远程智能控制、机器人协作、虚实融合系统等新一代 AI 场景中,视频模块不再是“可有可无的展示端”,而是承担环境感知、任务判断、反馈确认等核心职责的“视觉入口”。

大牛直播SDK 提供了一套 高度模块化、低耦合、跨平台的嵌入式视频能力体系,可灵活接入多种智能系统架构,完成从设备端 → 渲染端 → 控制端的全流程打通。

🔧 核心模块组成与功能分布

| 模块名称 | 功能描述 |

|---|---|

| 🎯 协议接入模块 | 支持 RTSP / RTMP 多协议接入,兼容工业设备、无人机、平台推流等各类来源 |

| 🧠 解码渲染模块 | 基于 Android MediaCodec / FFmpeg 提供软硬解混合解码能力,支持 H.264/H.265 等常见编码格式 |

| 🎮 OpenGL/OES 输出模块 | 将解码后的视频帧通过 OES 纹理输出,避免 CPU→GPU 资源拷贝,提高渲染效率,适配 Unity/Native |

| 🧩 Unity 插件封装模块 | 支持 Unity 外部纹理绑定,轻松集成到 Pico / Quest 等头显设备中 |

| 📷 画面控制与数据接口模块 | 支持快照、录像、YUV/RGB 数据回调、实时码率统计、帧率监控、参数调节等功能 |

| 📡 异常处理与网络适配模块 | 自带断流重连机制、缓冲策略调优、网络状态感知与弱网容错逻辑,保障播放稳定性 |

📊 架构示意:大牛直播SDK 视频能力嵌入路径(Pico/Quest 头显场景)

[视频源] --> [协议接入模块] --> [解码模块] --> [OES纹理输出] --> [Unity绑定模块] --> [头显显示] ↑ [画面控制 / 数据回调 / 状态监控模块]此架构具备以下优势:

🔄 模块解耦,按需集成:无需全部依赖,可根据项目只集成解码+回调、或解码+播放等子模块;

⚙️ 跨平台统一封装:支持 Android / iOS / Windows / Linux 等主流平台;

💡 支持私有化定制与接口扩展:便于嵌入复杂业务系统或智能体框架中使用;

🧩 完美嵌入工业级智能系统:如机器人控制系统、工业可视化平台、AI分析平台等。

🔗 与智能系统的联动能力

| 系统组件 | 大牛直播SDK 提供的连接接口与价值 |

|---|---|

| 🤖 智能机器人系统 | 视频回调可接入 AI 行为模型;播放状态可驱动动作执行同步 |

| 📡 无人机调度平台 | 支持多路视频流并发解码与画面切换;提供原始帧流用于二次分析 |

| 🧠 AI 边缘分析框架 | 提供 YUV/RGB 原始帧数据;可用于目标检测/姿态估计等算法接入 |

| 🕶 XR/头显应用系统 | 与 Unity 渲染无缝结合;支持上层继续开发沉浸式交互与多视角同步切换 |

| 🧰 工业控制/远程维护 | 快速嵌入控制终端或可视化面板,保障低延迟操作响应与状态反馈 |

✨ 为什么值得嵌入大牛直播SDK?

✅ 稳定性强:稳定运营经验,工业场景长期验证;

✅ 极低延迟:播放链路全栈可控,支持端到端延迟控制在100-250ms;

✅ 高度集成:提供完整播放、控制、画面处理与调试接口;

✅ 易扩展、可裁剪:支持业务定制,轻松嵌入复杂系统架构;

✅ AI 就绪:视频数据可直接流向 AI 模型,无需二次封装;

✅ 跨平台适配:从 Android 到 Pico / Quest / Unity3D 一站打通。

一句话总结:大牛直播SDK的视频能力,不仅是播放端,更是远程智能系统中的“视觉通感中枢”,具备从数据采集 → 解码渲染 → 控制反馈全链路打通的能力,真正让视频为智能体赋能。

六、🔚 总结:视频能力,是远程智能系统的“基础感官”

在 2025 世界人工智能大会上,我们看到一个明确的趋势正在发生:

智能系统不再只依赖算法内核,而是加速向具身智能、远程协同、实时反馈的方向演进。感知能力成为支撑这一转变的底座,而“视频”无疑是最直接、最信息密集的感知通道。

就像神经系统中的“视神经”,视频能力在远程智能场景中承载着至关重要的角色:

它是环境理解的前提:无人机不可能识别山火、四足机器人无法判断通道障碍、远程机械手无法完成精细操作,如果没有高质量的图像输入;

它是人机协作的桥梁:通过头显设备,操控者可以与 AI 系统共享第一视角、协同感知、动态决策;

它是智能反馈的起点:AI 模型对事件的判断,往往基于稳定、低延迟的视频流进行实时推理和响应;

它是安全控制的保障:在高风险环境中,视频流能让远程操作者拥有“沉浸式”判断力,从而更安全地控制任务。

因此,视频不只是展示,更是连接“感知—决策—控制”闭环的核心基石。

📌 大牛直播SDK:为远程智能打造的“视频通感模块”

大牛直播SDK 提供的不仅是一套播放器,而是一个适配未来远程智能系统的通用感知接口,具备以下关键优势:

💡 适配性强:兼容无人机、机器人、工业设备、XR终端等多种前端与平台;

⏱ 低延迟稳定:从码流到画面端到端可控,保障远程响应效率;

🧠 AI 友好:支持原始数据回调,便于对接检测、跟踪、识别模型;

🔁 高并发可扩展:满足多终端、多通道、多任务并行协作;

🔗 可嵌入系统级框架:与 Unity、原生 App可无缝融合;

🧩 模块化部署:轻量封装,灵活集成,无需绑定平台或复杂依赖。

当“远程智能”成为时代的新常态,视频能力的质量、效率与开放性,将决定系统的真实响应力与协作边界。

而大牛直播SDK,正是在这条视频感知链路上,构建了一块值得信赖的基座,让每一个 AI 系统,都能“看得见、看得快、看得稳”。