ℹ️教程说明

本教程,适合想快速掌握ollama基本使用的朋友,只需要了解常用、基本的操作,快速上手。

如果需要进一步深入学习的朋友,可以看一下慢教程/详细教程:

⚛️ 一、Ollama简介

Ollama 是一个轻量级、跨平台的大语言模型(LLM)运行工具,它让你可以在本地轻松地下载、运行和管理大模型,而无需复杂的配置。

- 它封装了模型运行所需的环境(如Python、CUDA等)

- 提供了简单的命令行接口(CLI)

- 支持多种主流模型(市面通用的基本都包含🤣)

🧱 二、安装Ollama(Windows)

🛠️ 安装步骤:

- 访问官网:https://ollama.com

- 点击 Download for Windows

- 下载完成后,双击安装包,按提示安装

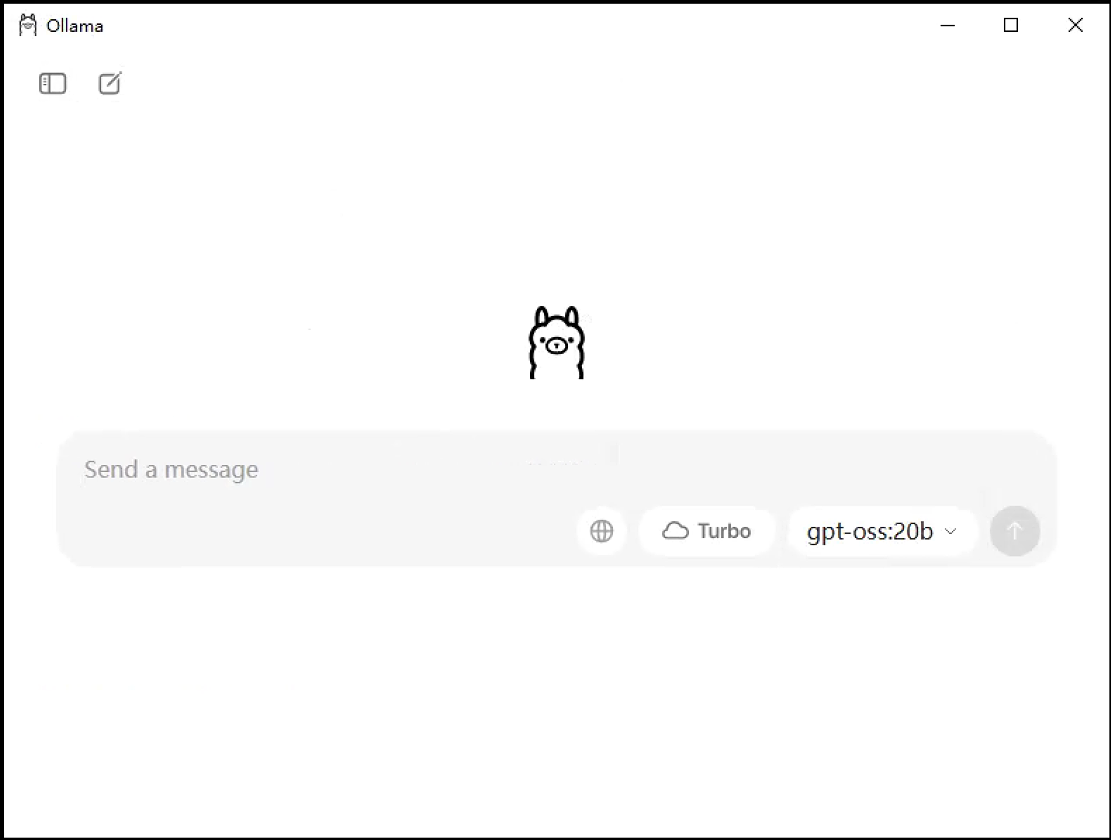

- 安装完成后,系统会自动启动Ollama服务,并进入ollama桌面程序

⚙️ 三、Ollama配置

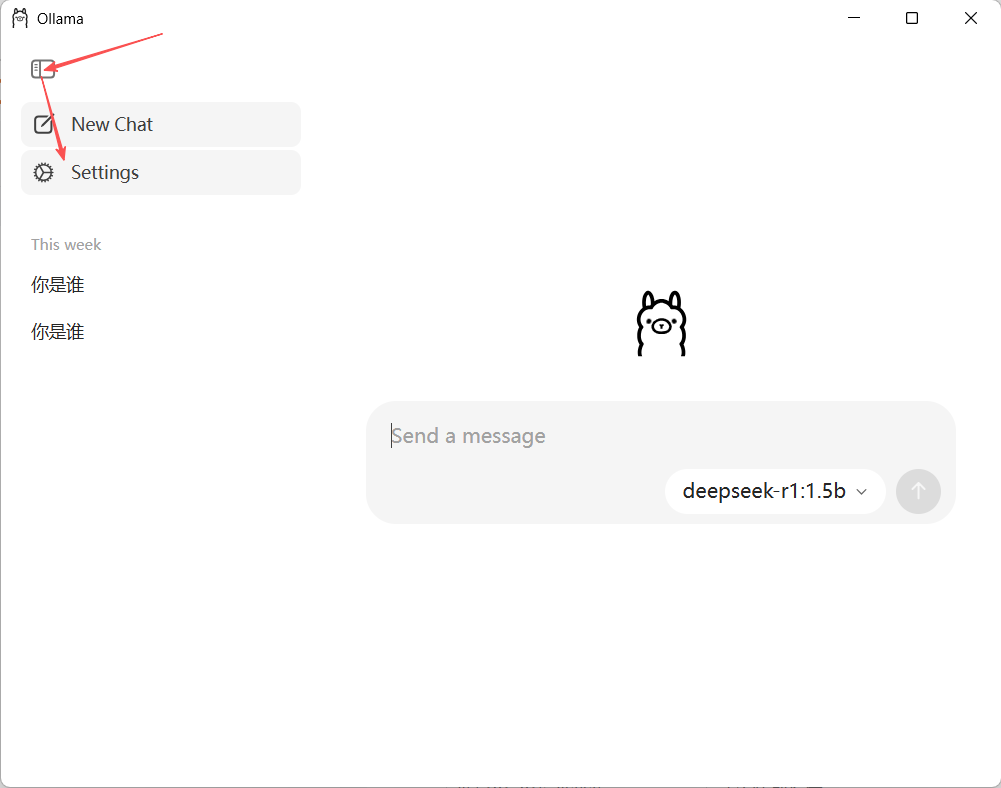

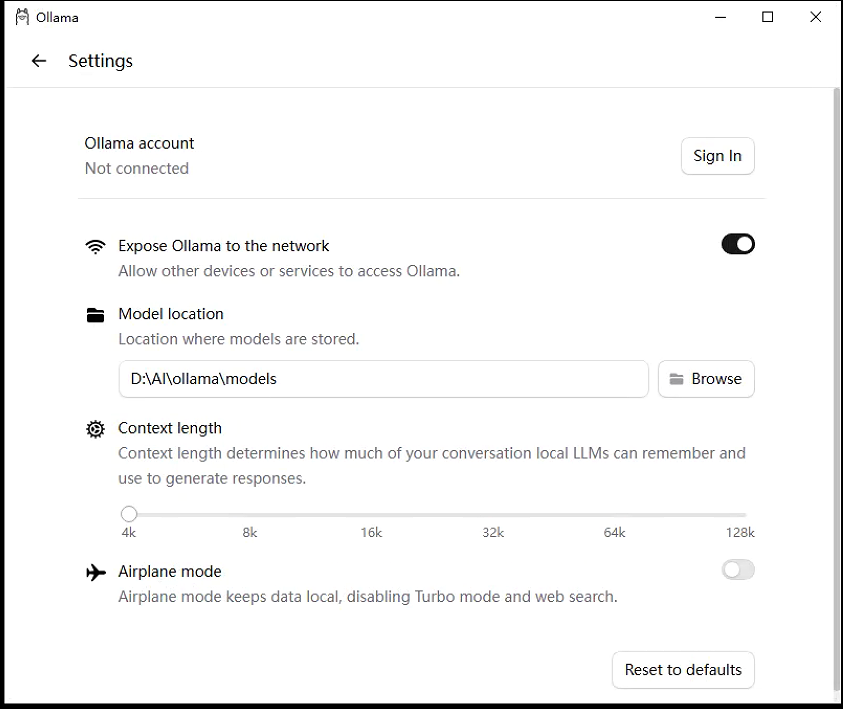

打开ollama桌面程序,进入设置界面:

修改设置:

常用设置项说明:

- Expose Ollama to the network(向网络暴露 Ollama):允许局域网或其他设备通过 HTTP API 访问你的 Ollama 服务。

- Model location(模型存储位置):修改本地模型文件的存放目录。

🧪 四、大模型下载及使用

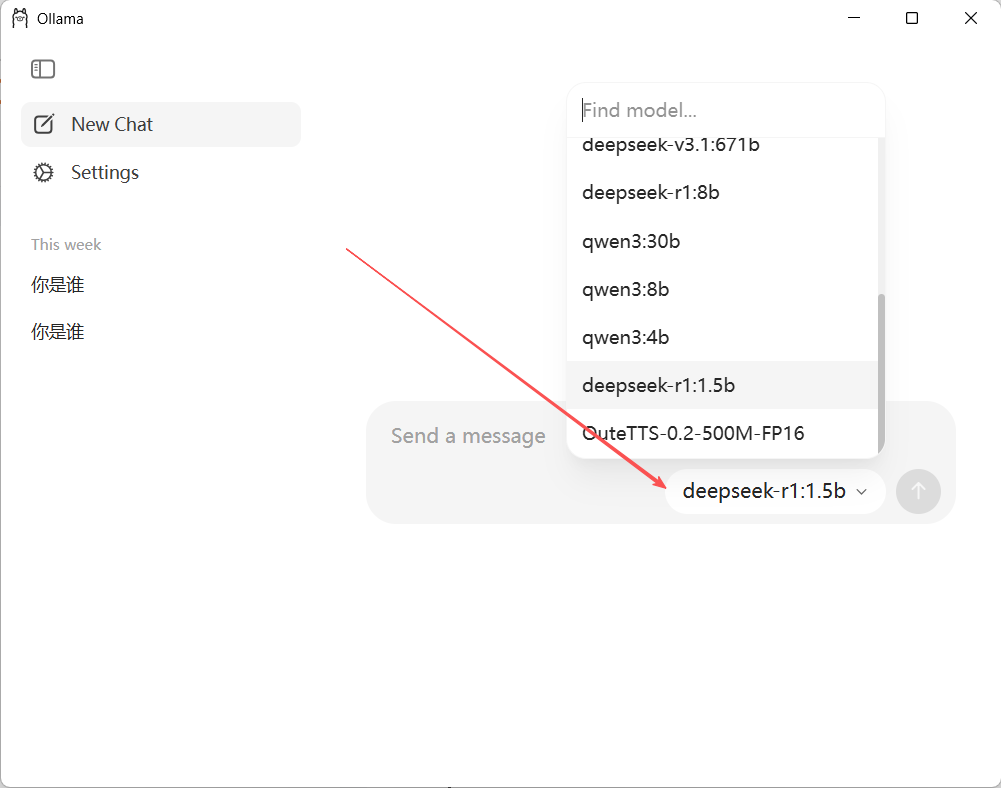

打开ollama桌面程序,选择你需要的大模型,或输入你需要的模型名称:

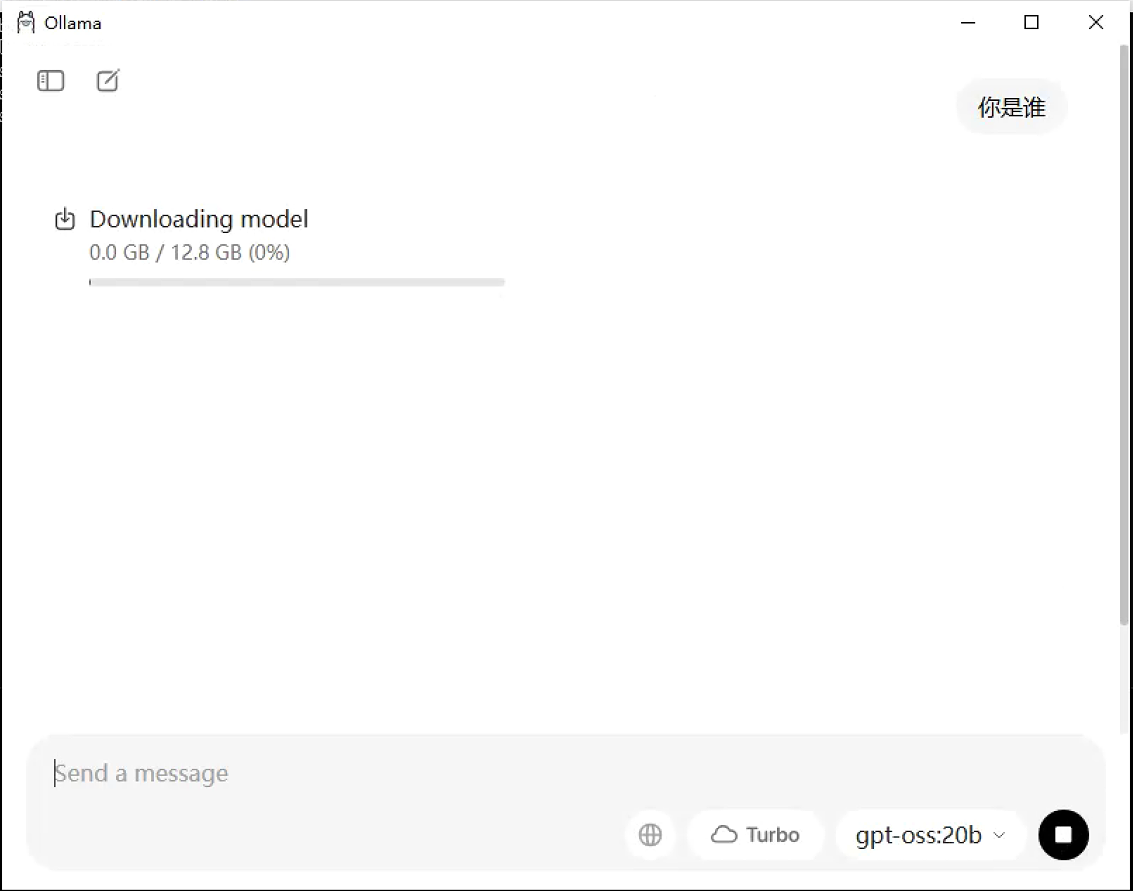

直接进行对话,如果此模型未安装,ollama会自动安装,如下图所示:

⚠️注意,直接输入大模型名称时,请确保和官网提供的模型名称(Ollama Search)一致,以免ollama找不到。

🧩 五、常用命令详解

一些常用功能,桌面程序还不支持,可以通过DOS命令来操作。

5.1 模型运行与交互

ollama run llama3

llama3为模型名称,可替换成你需要的模型,ollama下载并运行模型后,进入交互模式,输入问题即可获得响应。按 Ctrl+C 退出。

5.2 模型管理命令

| 命令 | 功能说明 |

|---|---|

ollama list |

查看已安装模型列表 |

ollama pull mistral |

下载指定模型 |

ollama rm llama3 |

删除模型 |

ollama stop llama3 |

停止模型运行 |

ollama show llama3 |

查看模型详情 |

♻️六、与本地模型管理应用结合使用(Cherry Studio)

Ollama 是本地大模型运行管理,同时提供 API 服务(默认 http://127.0.0.1:11434),很多桌面端 / WebUI / 插件类管理工具都可以把它作为模型提供方来调用。

Cherry Studio 是一款开源的多平台AI桌面客户端,支持Windows、macOS和Linux系统,集成了OpenAI、Claude、DeepSeek等主流大语言模型,并提供本地知识库管理、多模态交互(文本/图像/音频)及对话历史记录功能。

6.1 安装

官网下载:https://www.cherry-ai.com/

按提示安装

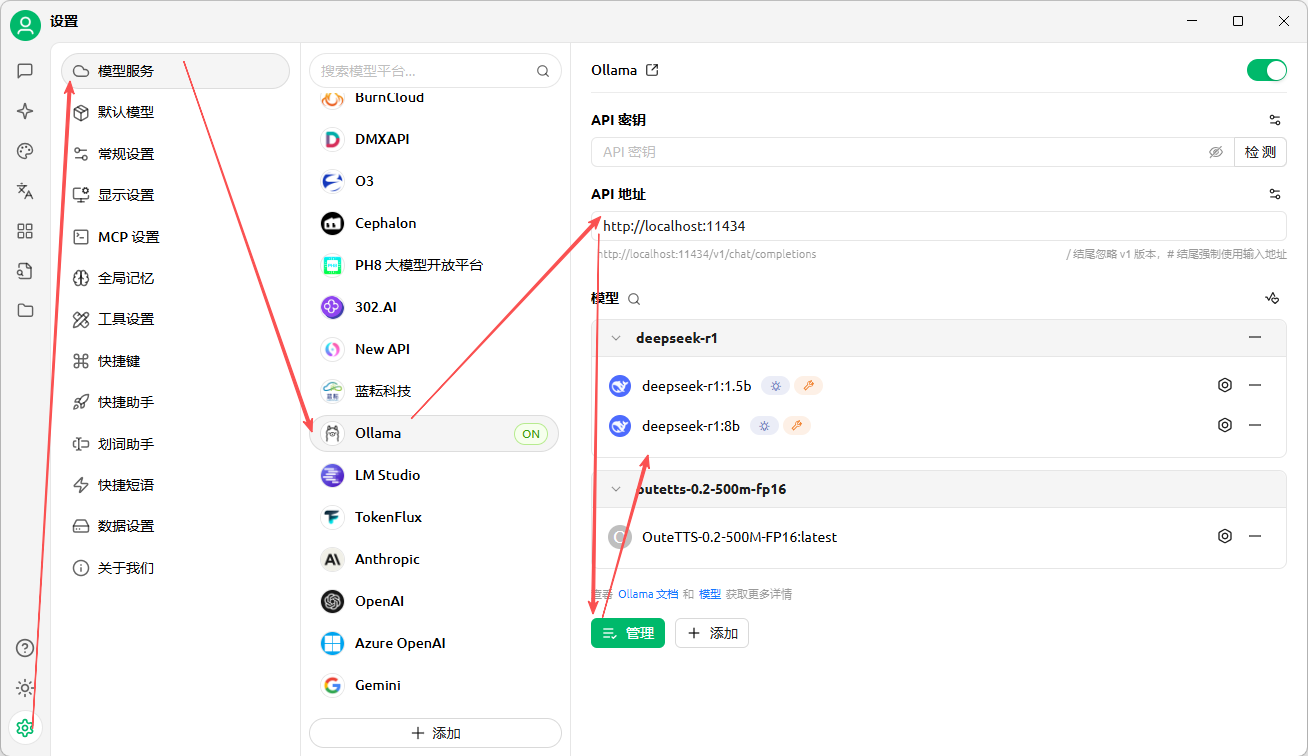

6.2 模型服务配置

依照下图,进入配置界面:

模型服务,选择Ollama,通过管理按钮添加Ollama已经部署的模型,见下图所示:

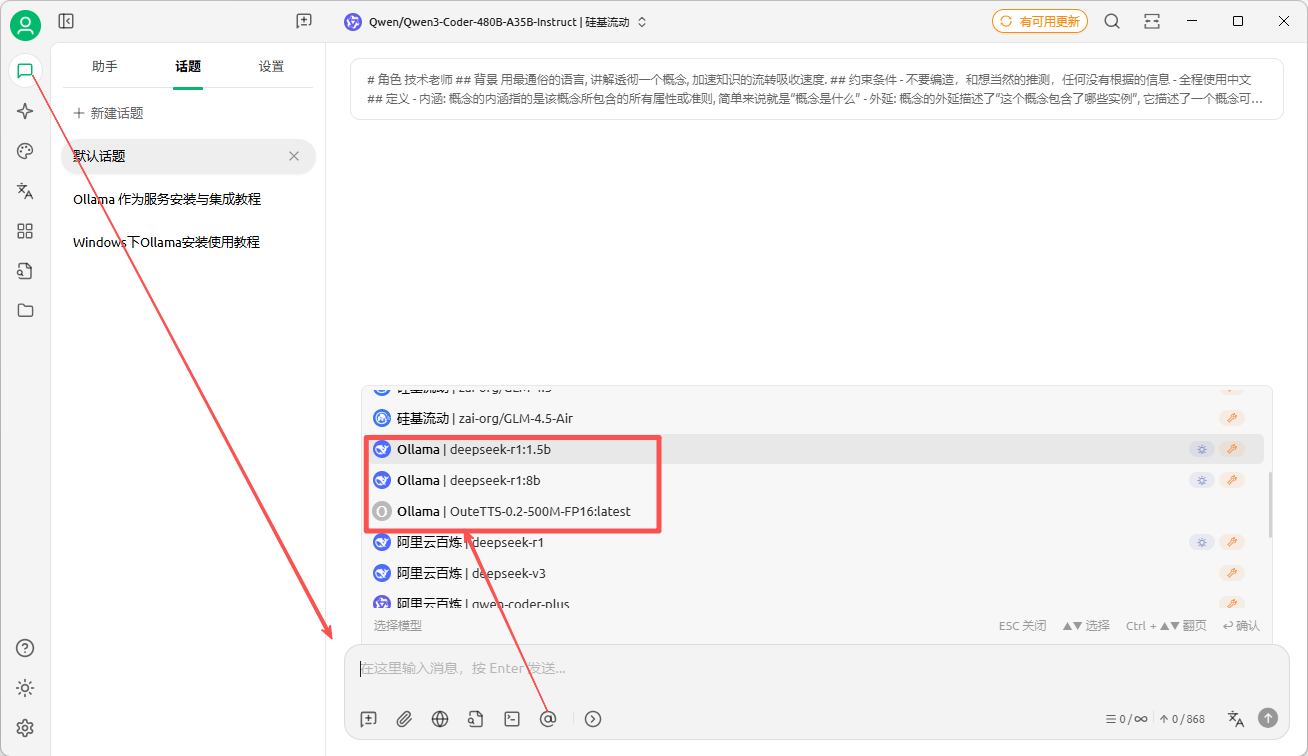

在聊天,或者设置聊天助手时,就可以使用ollama的大模型了:

🐳七、Python调用Ollama

Ollama 提供了专门的 Python SDK,这是官方维护的,与本地模型交互最直接和推荐的方式。

📜参考文档:https://github.com/ollama/ollama-python

7.1 安装与准备

条件:确保启动本地ollama服务:

ollama serve # 启动服务,默认端口 11434首先安装 Ollama Python 库:

pip install ollama7.2 同步对话调用

使用 chat 函数进行简单的同步对话生成:

# 导入Ollama库的chat函数和ChatResponse类型

from ollama import chat, ChatResponse

# 调用chat函数与模型进行交互,并指定返回类型为ChatResponse

response: ChatResponse = chat(

model='deepseek-r1:8b', # 指定要使用的模型名称

messages=[{ # 提供对话消息列表

'role': 'user', # 消息角色为用户

'content': '为什么天空是蓝色的?', # 用户的对话内容

}],

)

# 两种方式访问响应内容:

print(response['message']['content']) # 字典方式访问

# 或者

print(response.message.content) # 对象属性方式访问✍️说明:

没有特别指定ollama服务地址,则默认连接到本地运行的Ollama服务,本地ollama服务获取地址的方式:

- 默认本地ollama服务地址

- 或者你设置了相关环境变量:

- export OLLAMA_HOST=你的服务器地址:端口

7.3 自定义客户端

创建自定义客户端以设置特定请求头或连接远程 Ollama 实例:

from ollama import Client

# 创建自定义客户端

client = Client(

host='http://localhost:11434', # 可替换为远程地址

headers={'x-custom-header': 'custom-value'}

)

response = client.chat(

model='deepseek-r1:8b',

messages=[{'role': 'user', 'content': '你是谁?'}]

)💎总结:

Ollama 是一款轻量级本地大模型部署工具,使用广泛,且容易上手,如果深入学习,也可以对AI技术逐步深入了解,作为AI入门是一个非常不错的选择。