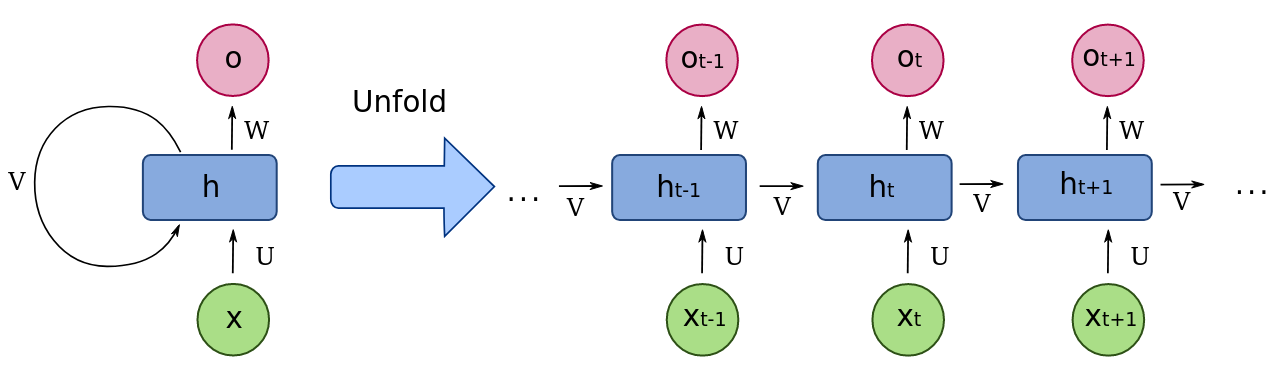

1. 理解序列建模和RNN

长短期记忆网络是一种递归神经网络(RNN)的变体,专门用于处理和预测时间序列数据。首先,理解标准RNN的基本工作原理是非常重要的,因为LSTM是其在解决长期依赖问题上的改进。

传统的循环神经网络(RNN)在处理长序列数据时会遇到两个主要的问题:梯度消失和梯度爆炸。

梯度消失问题:

- 原因:在标准RNN中,反向传播算法会将来自输出层的误差信号沿时间步反向传播到网络的初始时间步。每个时间步都涉及到权重矩阵的连续乘积,这导致梯度可能会非常小,甚至趋近于零。

- 后果:当梯度非常小时,网络无法有效地学习长期依赖关系,因为早期时间步的信息无法有效传播到后续时间步。

梯度爆炸问题:

- 原因:与梯度消失相反,梯度爆炸是指在反向传播过程中,某些梯度可能会变得非常大,甚至无限增长。这通常发生在权重矩阵连续相乘导致梯度指数级增长的情况下。

- 后果:梯度爆炸会导致数值不稳定性,使得网络的权重更新过大,进而影响模型的收敛性和泛化能力。

这些问题的出现主要是由于RNN的结构特性:在每个时间步,输入和隐藏状态之间的权重是共享的,而反向传播的链式乘积效应使得梯度难以有效地传播或控制。这就促使了LSTM(长短期记忆网络)的引入,它通过门控机制(例如遗忘门、输入门等)有效地解决了这些梯度问题,允许网络更好地捕捉和利用长期依赖关系。

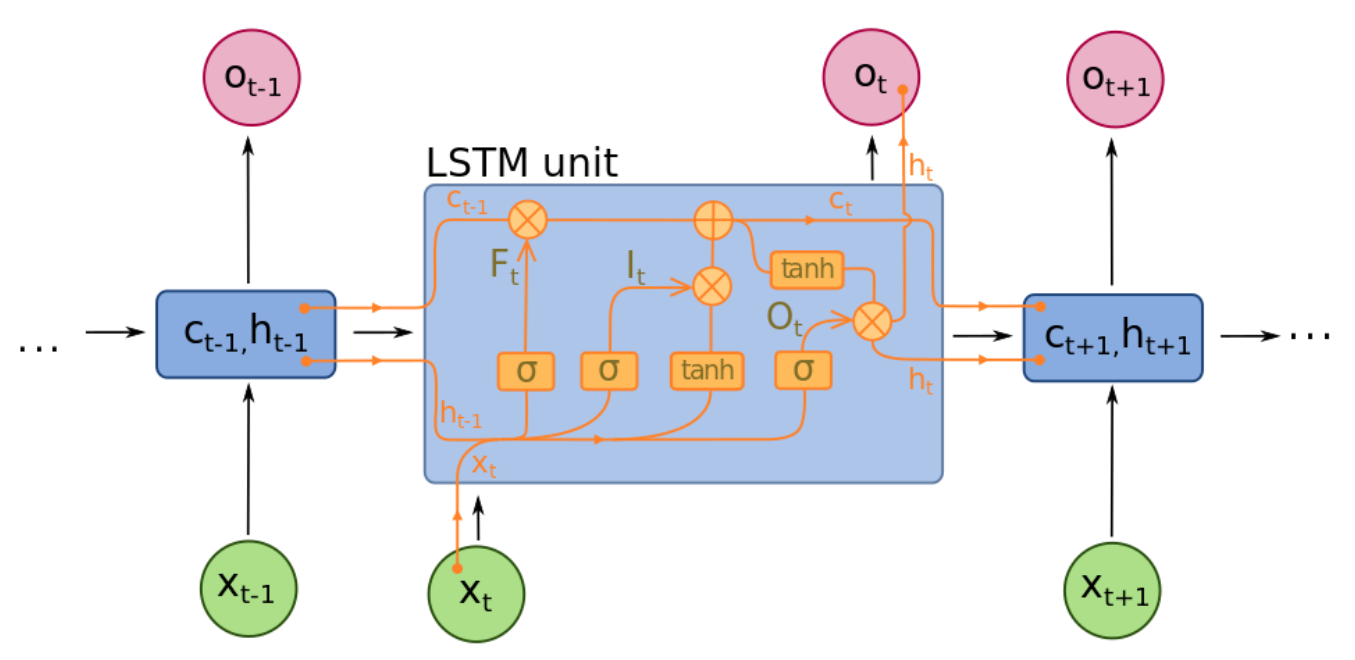

2. LSTM的基本结构

长短期记忆(Long Short-Term Memory,LSTM)通过引入称为“门控单元”的结构来解决传统RNN中的梯度消失和梯度爆炸问题。这些门控单元能够选择性地忘记或存储信息,从而更有效地处理长期依赖关系。

LSTM单元包含四个主要部分:

- 遗忘门(Forget Gate):决定当前单元状态需要遗忘多少过去的信息。

- 输入门(Input Gate):决定当前输入信息需要更新多少到单元状态。

- 输出门(Output Gate):决定当前单元状态中的信息有多少需要输出到下一时刻。

此外,LSTM还包含一个细胞状态(Cell State),用于存储长时间的记忆信息。

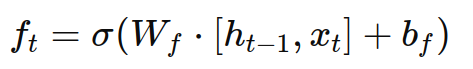

遗忘门(Forget Gate)

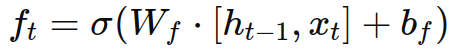

遗忘门的作用是决定哪些信息需要被遗忘。它接收当前输入 xt 和上一个时刻的隐藏状态 ht−1,并通过一个 sigmoid 函数进行处理:

其中, Wf 和 bf 分别是权重矩阵和偏置向量,σ 是 sigmoid 激活函数,输出值在 0 和 1 之间,表示需要遗忘的信息量。

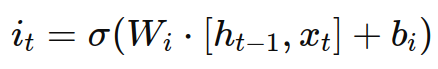

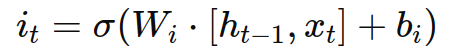

输入门(Input Gate)

输入门控制着哪些新的信息需要添加到单元状态。它同样接收当前输入 xt 和上一个时刻的隐藏状态 ht−1,包含两个部分:

- 一个 sigmoid 层,用于决定哪些值将被更新:

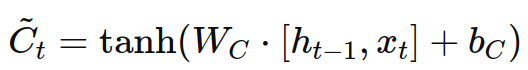

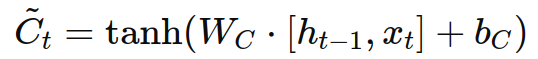

- 一个 tanh 层,用于生成新的候选记忆向量:

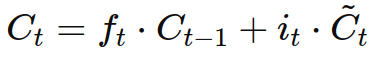

更新单元状态(Cell State Update)

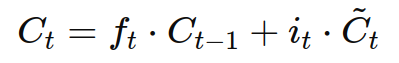

单元状态的更新过程结合了遗忘门和输入门的输出:

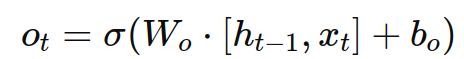

输出门(Output Gate)

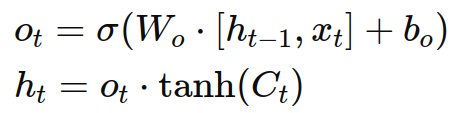

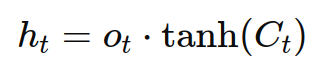

输出门决定当前单元状态的哪些部分将被输出。它通过一个 sigmoid 层和 tanh 层处理:

完整的LSTM单元公式

结合上述部分,一个完整的LSTM单元可以表示为以下公式:

- 遗忘门:

- 输入门:

- 候选记忆:

- 更新单元状态:

- 输出门:

- 更新隐藏状态:

通过这些步骤,LSTM能够在长时间跨度内保留和利用相关信息,有效地解决传统RNN在处理长序列数据时的梯度消失和梯度爆炸问题,使其成为处理序列数据的强大工具。

通过这些步骤,LSTM能够在长时间跨度内保留和利用相关信息,有效地解决传统RNN在处理长序列数据时的梯度消失和梯度爆炸问题,使其成为处理序列数据的强大工具。

3. 代码示例

import numpy as np

import matplotlib.pyplot as plt

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 生成正弦波数据

def generate_sine_wave(seq_length, num_samples):

x = np.linspace(0, 100, num_samples)

y = np.sin(x)

data = []

for i in range(len(y) - seq_length):

data.append(y[i:i + seq_length + 1])

data = np.array(data)

return data[:, :-1], data[:, -1]

# 参数

seq_length = 50

num_samples = 1000

# 生成数据

x, y = generate_sine_wave(seq_length, num_samples)

# 数据分割

split_ratio = 0.8

split_idx = int(len(x) * split_ratio)

x_train, x_test = x[:split_idx], x[split_idx:]

y_train, y_test = y[:split_idx], y[split_idx:]

# 重塑数据为LSTM输入格式

x_train = np.expand_dims(x_train, axis=-1)

x_test = np.expand_dims(x_test, axis=-1)

# 构建LSTM模型

model = Sequential([

LSTM(50, return_sequences=True, input_shape=(seq_length, 1)),

LSTM(50),

Dense(1)

])

model.compile(optimizer='adam', loss='mse')

# 训练模型

model.fit(x_train, y_train, epochs=20, batch_size=32, validation_data=(x_test, y_test))

# 预测

y_pred = model.predict(x_test)

# 绘图

plt.figure(figsize=(12, 6))

plt.plot(np.arange(len(y_test)), y_test, label='True', color='blue')

plt.plot(np.arange(len(y_pred)), y_pred, label='Predicted', color='orange', linestyle='--')

plt.legend()

plt.show()

4. 应用场景

LSTM(Long Short-Term Memory)由于其在处理长时间序列数据方面的强大能力,被广泛应用于各种领域。以下是LSTM的一些主要应用场景:

1. 自然语言处理(NLP)

- 机器翻译:LSTM可以处理源语言和目标语言的序列数据,实现自动翻译。典型的例子是Google翻译。

- 文本生成:LSTM可以生成与给定文本风格相似的文本,例如诗歌创作、故事生成等。

- 情感分析:通过分析文本中的情感词汇和句子结构,LSTM可以用于情感分类和情感评分。

- 语音识别:将语音信号转换为文字时,LSTM可以处理音频序列数据,提升识别准确率。

2. 时间序列预测

- 金融市场预测:LSTM用于预测股票价格、交易量和其他金融指标,帮助投资决策。

- 天气预报:通过分析历史气象数据,LSTM可以预测未来的天气情况。

- 销售预测:根据过去的销售数据,LSTM可以预测未来的销售趋势,辅助库存管理和市场策略。

3. 语音处理

- 语音识别:LSTM用于将语音信号转换为文本,广泛应用于语音助手、电话客服等领域。

- 语音合成:通过LSTM生成自然流畅的语音输出,用于文本转语音(TTS)系统,如智能音箱中的语音合成。

- 情感识别:分析语音中的情感信息,用于客户服务、心理健康评估等。

4. 视频分析

- 视频分类:LSTM通过分析视频帧的序列信息,实现视频内容分类,如识别视频中的活动类型。

- 动作识别:在监控视频中,LSTM用于识别和分析人物的动作,应用于安防、体育分析等领域。

- 视频生成:通过学习视频序列的模式,LSTM可以生成连续的视频帧,用于动画制作、视频编辑等。

5. 医疗健康

- 生物信号分析:LSTM用于分析心电图(ECG)、脑电图(EEG)等生物信号,帮助诊断心脏病、癫痫等疾病。

- 病情预测:通过分析患者的历史病情数据,LSTM可以预测病情发展趋势,辅助医生决策。

- 药物反应预测:根据患者的基因信息和历史用药数据,LSTM可以预测药物的反应和副作用,个性化医疗方案。

6. 自动驾驶

- 轨迹预测:LSTM用于预测车辆和行人的未来轨迹,帮助自动驾驶系统进行路径规划和避障。

- 行为预测:分析驾驶员的行为数据,LSTM可以预测潜在的危险行为,提高行车安全。

7. 电力负荷预测

- 能源管理:通过历史电力使用数据,LSTM可以预测未来的电力需求,优化电网管理和能源分配。

这些应用场景展示了LSTM在处理序列数据方面的强大能力,无论是在自然语言处理、时间序列预测、语音处理还是其他领域,LSTM都能有效地捕捉和利用长时间跨度的相关信息,提供准确和高效的解决方案。