欢迎来到 Papicatch的博客

文章目录

🍉引言

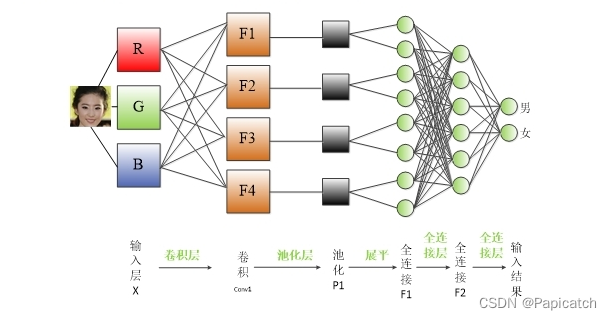

卷积神经网络(Convolutional Neural Networks,简称CNN)是一种深度学习算法,尤其擅长处理二维图像数据。自从AlexNet在2012年ImageNet竞赛中大获成功以来,CNN已经成为计算机视觉领域的标准方法。CNN通过模拟生物视觉系统的工作方式,对图像进行特征提取和分类,广泛应用于图像识别、对象检测、图像分割等任务。

🍉基本结构

🍈卷积层(Convolutional Layer)

卷积层是CNN的核心组件,用于提取输入数据的特征。它由多个卷积核(filters)组成,每个卷积核是一个小的矩阵,通过与输入数据进行卷积操作,生成一系列的特征图(feature maps)。每个特征图对应一个卷积核的输出,表示在输入数据中某种特定特征的空间分布情况。

🍍卷积操作

将卷积核与输入数据进行逐元素乘积,并将结果求和,得到输出特征图的一个像素值。

🍍步长(stride)

卷积核在输入数据上滑动的步长,决定输出特征图的尺寸。

🍍填充(padding)

在输入数据的边缘周围填充额外的值,可以控制输出特征图的尺寸。

🍈激活层(Activation Layer)

激活函数通常紧跟在卷积层之后,用来引入非线性特性。常用的激活函数包括ReLU(Rectified Linear Unit)、Sigmoid和Tanh等。它们的作用是在特征映射上引入非线性,使得网络能够学习复杂的数据分布。

🍈池化层(Pooling Layer)

池化层用于减少每个特征映射的空间尺寸,同时保留其重要信息。主要有最大池化(Max Pooling)和平均池化(Average Pooling)两种类型。池化操作通过对每个区域(例如2x2的窗口)的数值进行聚合,减少每个特征映射的尺寸,同时保留最显著的特征。

🍈全连接层(Fully Connected Layer)

全连接层位于网络的最后几层,用于将卷积层和池化层提取的特征映射转换为最终的输出结果。在全连接层中,每个节点都与前一层的所有节点连接,通过权重调整来学习输入数据的高级表示。

🍈Dropout 层

Dropout 层是一种正则化技术,有助于减少神经网络中的过拟合问题。它在训练过程中以一定的概率随机丢弃网络中的某些神经元,强制网络学习到更加鲁棒和泛化的特征。

🍈CNN的基本工作流程

- 输入数据经过一系列的卷积层和池化层,逐步提取和压缩特征。

- 特征在通过激活函数后,传递到全连接层,最终输出网络的预测结果。

- 在训练过程中,通过反向传播算法调整网络中的权重,使得网络能够更准确地预测目标。

🍉代码实现

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

# 定义卷积神经网络模型

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

# 定义卷积层和池化层

self.conv1 = nn.Conv2d(in_channels=3, out_channels=16, kernel_size=5, stride=1, padding=2)

self.relu = nn.ReLU()

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

# 定义全连接层

self.fc1 = nn.Linear(16 * 16 * 16, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(self.relu(self.conv1(x)))

x = x.view(-1, 16 * 16 * 16) # 将图像展平

x = self.relu(self.fc1(x))

x = self.relu(self.fc2(x))

x = self.fc3(x)

return x

# 加载数据集(这里以CIFAR-10为例)

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5)) # 对图像进行归一化

])

trainset = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=4, shuffle=True, num_workers=2)

# 初始化模型、损失函数和优化器

net = SimpleCNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

# 训练网络

for epoch in range(2): # 遍历数据集多次

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

# 梯度清零

optimizer.zero_grad()

# 正向传播、反向传播和优化

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

# 打印统计信息

running_loss += loss.item()

if i % 2000 == 1999: # 每2000个小批量数据打印一次损失值

print(f'[{epoch + 1}, {i + 1}] loss: {running_loss / 2000:.3f}')

running_loss = 0.0

print('Finished Training')

这段代码实现了一个简单的卷积神经网络,包括一个卷积层、ReLU激活函数、最大池化层和全连接层。在训练部分,我们使用了CIFAR-10数据集作为示例数据集,使用随机梯度下降优化器(SGD)和交叉熵损失函数来训练网络。

🍉优点与挑战

🍈优点

🍍局部感知和权值共享

CNN利用卷积层进行局部感知,每个神经元只关注输入数据的局部区域,而不是全局。这种局部连接和权值共享使得网络对平移、旋转和缩放具有一定程度的不变性,减少了需要训练的参数数量,降低了模型的复杂度。

🍍逐层抽象表示

CNN通过堆叠多个卷积层和池化层,逐渐提取数据的高层次特征。低层次的层主要提取边缘和纹理等基础特征,而高层次的层则可以捕捉更抽象的特征,如物体的形状和组合。

🍍参数共享

参数共享指的是在同一个卷积核的所有位置使用相同的权重,这种机制减少了需要训练的参数数量,同时提高了模型的泛化能力。

🍍空间结构保持

CNN在处理图像等空间数据时,能够有效地保持输入数据的空间结构,不需要对输入进行展平操作,这有助于保留图像中的局部信息和空间关系。

🍍处理大规模数据的能力

CNN经过优化后能够处理大规模的数据,如高清图像或视频帧。由于卷积操作和参数共享的特性,CNN能够在保持一定计算效率的同时,处理更大尺寸的输入数据。

🍈挑战

🍍需大量数据和计算资源

训练一个复杂的CNN模型通常需要大量的标记数据和强大的计算资源。特别是在高分辨率图像或视频处理中,训练时间和计算成本可能会非常高昂。

🍍设计复杂性

设计一个有效的CNN结构对于特定任务需要一定的经验和技巧。选择合适的卷积核大小、层数、池化策略以及全连接层的设计,直接影响到模型的性能和泛化能力。

🍍过拟合

CNN具有大量的参数,如果训练数据不足或者模型复杂度过高,容易导致过拟合现象,即模型在训练数据上表现良好,但在测试数据上表现不佳。

🍍处理变形和遮挡

CNN在处理变形(如图像拉伸)和遮挡(如部分物体被遮挡)的情况下可能表现不佳,因为卷积层在进行特征提取时依赖于局部信息,变形或遮挡可能会影响特征的正确提取。

🍍可解释性差

深度CNN模型通常被视为黑盒模型,难以理解和解释其内部的决策过程。这对于某些领域(如医疗诊断或司法领域)可能会带来挑战。

🍈小结

尽管面临一些挑战,CNN作为一种有效的神经网络结构,在计算机视觉和其他空间数据处理任务中取得了许多显著的成就。随着深度学习技术的发展,对CNN模型的改进和优化也在不断进行,以应对不同领域和任务的需求。

🍉CNN的应用和成就

🍈 图像分类

CNN在ImageNet大规模图像分类比赛中取得了突破性的成就,其优秀的特征提取能力和分类准确性使得CNN成为处理图像分类问题的首选模型。

🍈物体检测和语义分割

基于CNN的物体检测和语义分割方法,如Faster R-CNN、Mask R-CNN等,不仅提高了检测精度和分割准确性,还实现了实时处理的可能性,广泛应用于自动驾驶、医学影像分析等领域。

🍈迁移学习和预训练模型

迁移学习通过在大型数据集上预训练的CNN模型(如ResNet、VGG等)来提高小型数据集上任务的性能。这种方法已经成为许多领域中的标准实践,极大地促进了深度学习的应用扩展。

🍉总结

卷积神经网络作为一种强大的深度学习模型,在处理图像和空间数据方面表现出色,为计算机视觉的发展和应用带来了革命性的影响。随着技术的不断进步和研究的深入,我们可以期待CNN在更广泛的领域和更复杂的任务中展示出其巨大的潜力和应用价值。