首先进入宝塔面板,文件管理进入/www/server/nginx/conf目录,新建空白文件kill_bot.conf。然后将以下代码保存到当前文件中。

#禁止垃圾搜索引擎蜘蛛抓取

if ($http_user_agent ~* "CheckMarkNetwork|Synapse|Nimbostratus-Bot|Dark|scraper|LMAO|Hakai|Gemini|Wappalyzer|masscan|crawler4j|Mappy|Center|eright|aiohttp|MauiBot|Crawler|researchscan|Dispatch|AlphaBot|Census|ips-agent|NetcraftSurveyAgent|ToutiaoSpider|EasyHttp|Iframely|sysscan|fasthttp|muhstik|DeuSu|mstshash|HTTP_Request|ExtLinksBot|package|SafeDNSBot|CPython|SiteExplorer|SSH|MegaIndex|BUbiNG|CCBot|NetTrack|Digincore|aiHitBot|SurdotlyBot|null|SemrushBot|Test|Copied|ltx71|Nmap|DotBot|AdsBot|InetURL|Pcore-HTTP|PocketParser|Wotbox|newspaper|DnyzBot|redback|PiplBot|SMTBot|WinHTTP|Auto Spider 1.0|GrabNet|TurnitinBot|Go-Ahead-Got-It|Download Demon|Go!Zilla|GetWeb!|GetRight|libwww-perl|Cliqzbot|MailChimp|SMTBot|Dataprovider|XoviBot|linkdexbot|SeznamBot|Qwantify|spbot|evc-batch|zgrab|Go-http-client|FeedDemon|JikeSpider|Indy Library|Alexa Toolbar|AskTbFXTV|AhrefsBot|CrawlDaddy|CoolpadWebkit|Java|UniversalFeedParser|ApacheBench|Microsoft URL Control|Swiftbot|ZmEu|jaunty|Python-urllib|lightDeckReports Bot|YYSpider|DigExt|YisouSpider|HttpClient|MJ12bot|EasouSpider|LinkpadBot|Ezooms") {

return 403;

break;

}

#禁止扫描工具客户端

if ($http_user_agent ~* "crawl|curb|git|Wtrace|Scrapy" ) {

return 403;

break;

}2. 修改网站配置文件

进入网站设置:

- 在宝塔面板左侧导航栏中选择“网站”。

- 找到并点击您要配置的网站,进入网站设置页面。

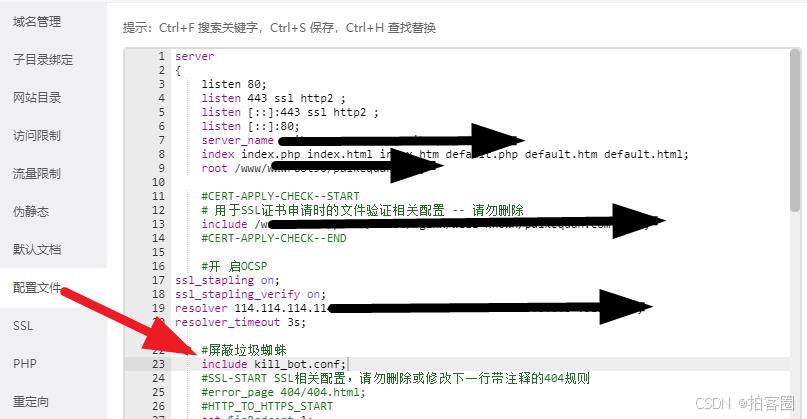

编辑配置文件:

- 在网站设置页面左侧导航栏中选择“配置文件”。

插入自定义配置:

- 在

#SSL-START SSL相关配置,请勿删除或修改下一行带注释的404规则上方空白行插入以下代码: - #屏蔽垃圾蜘蛛

- include kill_bot.conf;

- 在

include kill_bot.conf;- 保存配置:

- 保存并应用配置文件。

- 保存并应用配置文件。

3. 验证配置

重启Nginx:就可以在网站日志里看到防御效果了。

- 在宝塔面板左侧导航栏中选择“软件商店”。

- 找到并点击“Nginx”,然后点击“重启”按钮。