25年3月来自香港中文大学的论文“TASTE-Rob: Advancing Video Generation of Task-Oriented Hand-Object Interaction for Generalizable Robotic Manipulation”。

本文也是在解决现有数据集和模型在面向任务的手部-目标交互视频生成方面的关键限制,这是为机器人模仿学习生成视频演示的关键方法。当前的数据集,例如 Ego4D [16],经常受到视角不一致和交互错位的影响,导致视频质量下降并限制了它们在精确模仿学习任务中的适用性。为此,推出 TASTE-Rob——一个开创性的大规模数据集,包含 100,856 个以自我为中心的手部-目标交互视频。每个视频都与语言指令精心对齐,并从一致的摄像机视角录制,以确保交互清晰度。通过微调 TASTE-Rob 上的视频扩散模型 (VDM),实现逼真的目标交互,尽管手部抓握姿势偶尔存在不一致的情况。为了增强真实感,引入一个三阶段姿势细化流程,可提高生成视频中手势的准确性。所挑选的数据集,加上专门的姿势细化框架,在生成高质量、面向任务的手部物体交互视频方面提供显著的性能提升,从而实现卓越的可通用机器人操作。

其收集一个海量且多样化的以自我为中心、面向任务的手-目标交互(HOI)视频数据集 TASTE-Rob,其中包含 100,856 对视频及其对应的语言任务指令。为了服务于 HOI 视频生成,TASTE-Rob 需要实现以下目标:1)每段视频均采用静态摄像机视角录制,并包含与任务指令紧密契合的单一动作。2)涵盖多样化的环境和任务。3)展现不同 HOI 场景中的各种手势。

数据收集策略与摄像机设置

为了实现第一个目标,用多个配备广角镜头的摄像机,能够拍摄 1080p 的以自我为中心的视频。在每次录制过程中,进行以下改进。

首先,由于数据收集旨在为 IL 中演示生成面向任务的 HOI 视频,而为了实现有效的机器人模仿学习,演示通常从固定的摄像机视点录制,因此确保在录制过程中不会发生摄像机视角的变化。此外,如图所示,专门调整摄像机视角以匹配 Ego4D [16] 的头戴式摄像机设置,确保与自我中心视角保持一致。

第二个目标是确保 TASTE-Rob 中的语言任务指令和视频动作之间精确对齐,这是保持生成的 HOI 视频中动作完整性的关键方面。与 Ego4D [16] 通过头戴式摄像机捕获日常活动的扩展记录并分割成更短的片段不同,本文采用了更受控制的收集协议:1) 每个视频的时长严格限制在 8 秒以内,并捕获单个动作。 2)采集器遵循结构化的记录流程:按下“开始记录”按钮,根据提供的指令执行指定的HOI任务,并在任务完成后停止记录。这种方法确保了操作和任务指令之间的精确对应。

数据多样性

环境和任务的分布。为了实现广泛的泛化,TASTE-Rob 中的视频录制于不同的环境中,涵盖广泛的 HOI 任务。如图所示,环境包括厨房、卧室、餐桌、办公桌等地点。收集者需要与各种常用物品进行交互,并执行拾取、放置、推动、倾倒等任务。为了进一步确保任务的多样性,考虑不同的手部使用模式。具体来说,TASTE-Rob 包含 75,389 个单手任务视频和 25,467 个双手任务视频。

抓握手的分布。为了确保手势的多样性,考虑两个主要因素:不同的手掌方向(整体姿势)和不同的抓握姿势(细节姿势)。为了展示手势的多样性,利用 HaMeR [34] 提取手势参数并分析基于这些参数的分布。

如表所示,分析 TASTE-Rob 中 HOI 交互过程中手掌方向的分布。分析揭示了以下几点:1)手掌朝下(0° -180°)的手势最为常见,因为这种方向适合抓握物体。2)手掌朝左(90° -270°)的手势比朝右的手势略多,这可能是因为所有收藏家都是右撇子,自然更喜欢用右手来操作物体。

如下两个图中提供手部抓握姿势分布的分析。鉴于拇指、食指和中指在 HOI 中起主导作用,重点研究了这些手指之间的夹角及其各自的曲率分布。

如图中的分析显示夹角的广泛分布,表明手部方向各异。

如下图揭示了两个关键发现:1)食指和中指的曲率分布呈现出相似的模式,反映了它们在 HOI 动作期间的同步弯曲。2)数据集捕捉了各种各样的抓握姿势,这些姿势是由各种被操纵的物体驱动的。

如表所示,对 TASTE-Rob 与现有的以自我为中心的 HOI 视频数据集进行比较。

TASTE-Rob 是一个专门为面向任务 HOI 视频生成设计的视频数据集,它也可以作为 IL 演示的宝贵资源。鉴于IL视频演示是从固定摄像机视角录制的,并且仅包含与任务指令一致的单个动作,在相同设置下收集HOI视频,这使得TASTE-Rob与其他数据集有所区别。此外,为了提高对目标物体的理解,在语言任务指令中加入多种物体限定词。借助TASTE-Rob,能够生成高质量的HOI视频演示,从而实现IL。

给定一个环境图像和一段任务描述,生成的面向任务的 HOI 视频需要满足:1)准确的任务理解:正确识别要操作的目标以及如何操作它。2)可行的 HOI:在整个操作过程中保持一致的手部抓握姿势。

如图中第一阶段区域所示,虽然由单个 VDM (vˆ_c) 生成的视频展现准确的任务理解,但在保持一致的抓握姿势方面表现出有限的保真度。为了满足这两个要求,提出一个三阶段姿势细化流程,如图所示:第一阶段:采用可学习的图像-到-视频 (I2V) 扩散模型生成满足“准确任务理解”要求的粗略 HOI 视频。第二阶段:从该粗略视频中提取手势序列,并使用可学习的运动扩散模型 (MDM) 对其进行细化 [45]。第三阶段:使用细化的手势序列生成满足两个要求的高保真 HOI 视频。

在本研究中,探索基于 DynamiCrafter [54](一个强大的 I2V 潜扩散模型)的 HOI 视频生成。假设 T 和 v 分别表示任务语言描述、环境图像和真实视频帧。DynamiCrafter 在紧凑的潜空间中学习去噪过程:v 通过编码器 E 编码到紧凑的潜在空间中,得到潜表示 z = E(v),并通过解码器 D 进行解码。在这个潜空间中,该模型以 T 和 i 为条件,执行前向扩散和引导去噪过程。

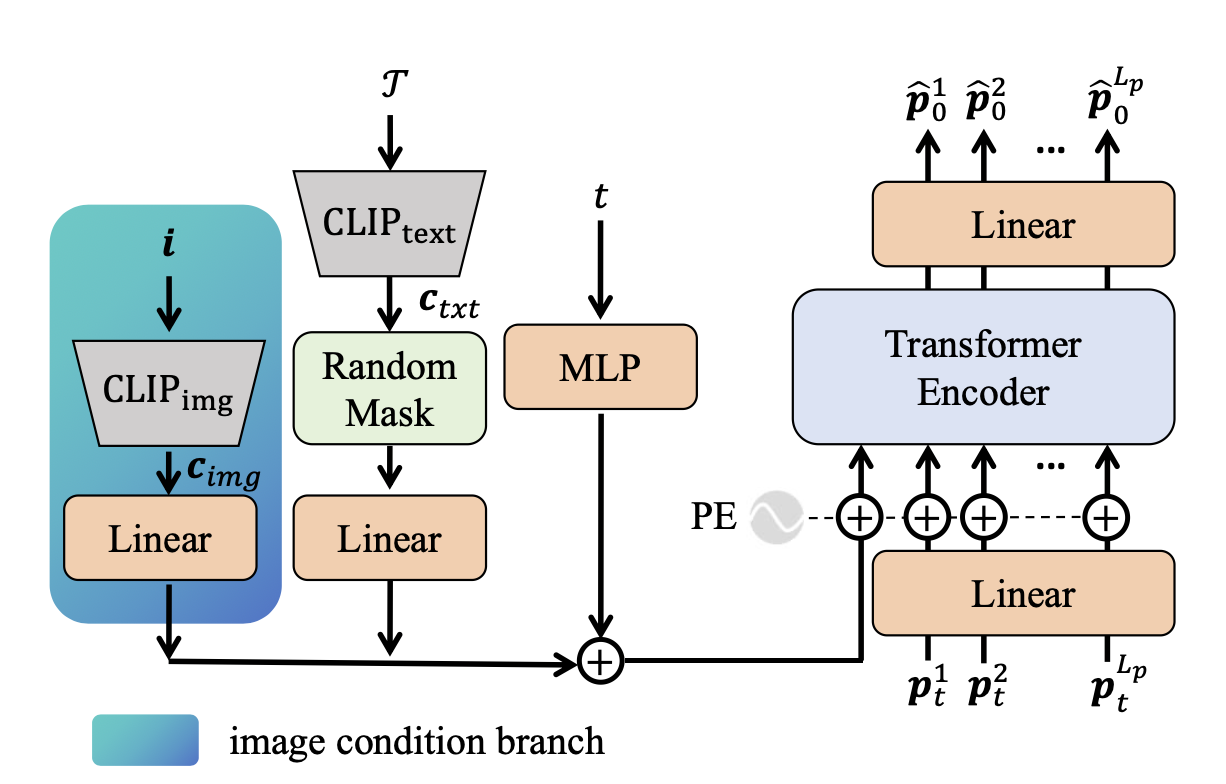

MDM [45] 采用独特的 Transformer 编码器架构,在生成人体运动序列方面表现出色。MDM 不是通过预测单步噪声,而是直接生成干净的运动序列。设 p 表示运动序列,M 表示 MDM 网络。其中,p_0 ∼ p_data § 和 p_T ∼ N (0, I)。训练结束后,MDM 通过 T 步去噪过程生成最终的干净运动序列 pˆ_0。然而,在每一步中,MDM 不是通过单步去噪直接生成 p_t−1,而是首先根据 p_t 预测干净的运动序列 pˆ_0,t。然后,重新引入噪声得到 p_t−1,通过重复此过程 T 次,MDM 生成最终干净的运动序列pˆ_0,0,记为pˆ_0。

第一阶段:粗略动作规划器

可学习的粗略动作规划器,旨在生成基于任务描述 T 和环境图像 i 的粗略 HOI 视频 vˆ_c。具体来说,在 TASTE-Rob 上对 DynamiCrafter [54] 进行微调,将其用作粗略动作规划器,记为 V。

训练。在微调过程中,采用与 DynamiCrafter [54] 类似的训练策略。为了充分利用 DynamiCrafter 强大的时间处理能力,同时使其适应本文特定的 HOI 视频生成,仅对其图像上下文投影器和其去噪 U-Net中的空间层进行微调。训练目标保持一致,其中可训练参数 θ_V 表示图像上下文投影器和空间层的参数。

手-物体交互不一致问题。生成的粗略 HOI 视频展现准确的任务理解能力,例如识别要操作的物体并确定其目标位置。然而,如上图 p_c 所示,抓取姿势在操作过程中表现出时间上的不一致性,表明缺乏运动连贯性。具体而言,这些不一致性指的是抓取姿势随时间发生的不良变化,表现为手势的不自然变化,而理想情况下,手与被抓物体之间的相对位置应该保持稳定。如图的 p_c 所示,绿色手势展示一种捏的手势,这与黄色手势的抓取姿势不一致,并且不适合被操作的目标物体。

第二阶段:修改手势序列

为了解决 HOI 不一致问题,训练一个图像-到-手势参数的 MDM 模型 M。该模型用于细化从粗略视频 vˆ_c 中提取的手势序列 p_c。具体来说,将 p_c 定义为手势关键点序列的归一化坐标,其中 L_p 表示序列长度,N_h 表示手势关键点的数量。

训练:可学习模型 M 旨在以任务描述 T 和环境图像 i 作为输入,预测精细的人体手势序列。为此,扩展原始的 MDM [45] 框架,通过一个附加的图像分支引入环境信息。如图所示,与 [45] 中的文本条件分支类似,新增的图像分支集成环境图像 i 的 CLIP [37] 类特征。

当通过 T 步去噪过程直接生成最终的干净姿势序列 pˆ 时,pˆ 实现物理上合理的手部运动,但表现出有限的空间意识。相反,p_c 表现出显著的空间意识。为了解决这个限制,用 M 来优化 p_c,而不是从高斯噪声生成。具体来说,用 p_0,N_rv 初始化 M 的去噪过程,将 p_c 设置为 p_0,N_rv。通过 N_rv 步去噪,优化 p_c 以获得最终的干净手部姿势序列 pˆ,该序列同时满足空间精度和运动可行性。

第三阶段:基于精细姿态的再生

利用精细化的手势序列,生成附加姿态条件 pˆ 的细粒度 HOI 视频。受 ToonCrafter [55] 的启发,训练一个与帧无关的姿态编码器 S 来控制生成视频中的手势。将 S 设计为一个逐帧适配器,它以 pˆ 为条件,独立地调整每帧的中间特征:F^i = S(s^i_inject, z^i, t),其中 s^i 是 pˆ 的可视化图像序列,F^i_inject 的处理方法类似于 ControlNet [62]。

在训练过程中,采用与 ToonCrafter [55] 类似的策略,其中 V 的所有参数都被冻结,并且只训练 S 的参数(表示为 η)。

最后,将生成的优质 HOI 视频 vˆ 作为 IL 的视频演示,并使用 Im2Flow2Act 策略模型实现机器人操作 [58]。如图所示,以生成的 HOI 视频作为演示,展示模仿学习的结果,也证实其在实现机器人操作方面的有效性。

实施

训练过程中,在 TASTE-Rob 数据集的训练集上训练模型。第一阶段:基于 DynamiCrafter 对粗略动作规划器进行微调,步长为 30K,批次大小为 16,学习率为 5 × 10−5。第二阶段:训练 MDM,步长为 100K,批次大小为 64,学习率为 1 × 10−4。第三阶段:基于 SD 对姿态编码器进行微调,步长为 30K,批次大小为 32,学习率为 5 × 10−5。在推理过程中,用 50 步去噪过程生成视频,并使用 Nrv 为 10 来优化姿态序列。

基线与比较

选择了四种现有的强大的 I2V 扩散模型——DynamiCrafter [54]、consistI2V [38]、Open-Sora Plan [26] 和 CogVideoX [60]——作为基线,并对这些基线与本文方法进行了比较实验。图中给出 TASTE-Rob-Test 和真实环境下视频生成性能的定性比较。

下表中给出 TASTE-Rob-Test 上的定量比较,结果证明本文方法卓越的视频质量和更好的泛化能力。根据以上实验,所有现有的强大的通用 VDM 都无法很好地完成操作任务,因此不适合生成 HOI 视频演示。鉴于其他两个评估方面侧重于衡量生成视频的细粒度细节,在此省略与这些基线方法的进一步比较。