深夜,生产环境告警疯狂轰炸,Redis 集群数据不一致,交易系统瘫痪。这样的噩梦,相信不少开发者都曾经历过。查日志、排问题,结果发现是 Redis 集群脑裂作祟。这个看似神秘的"脑裂"问题,究竟是怎么回事?今天就带大家深入了解这个 Redis 集群中的棘手问题。

什么是 Redis 集群脑裂?

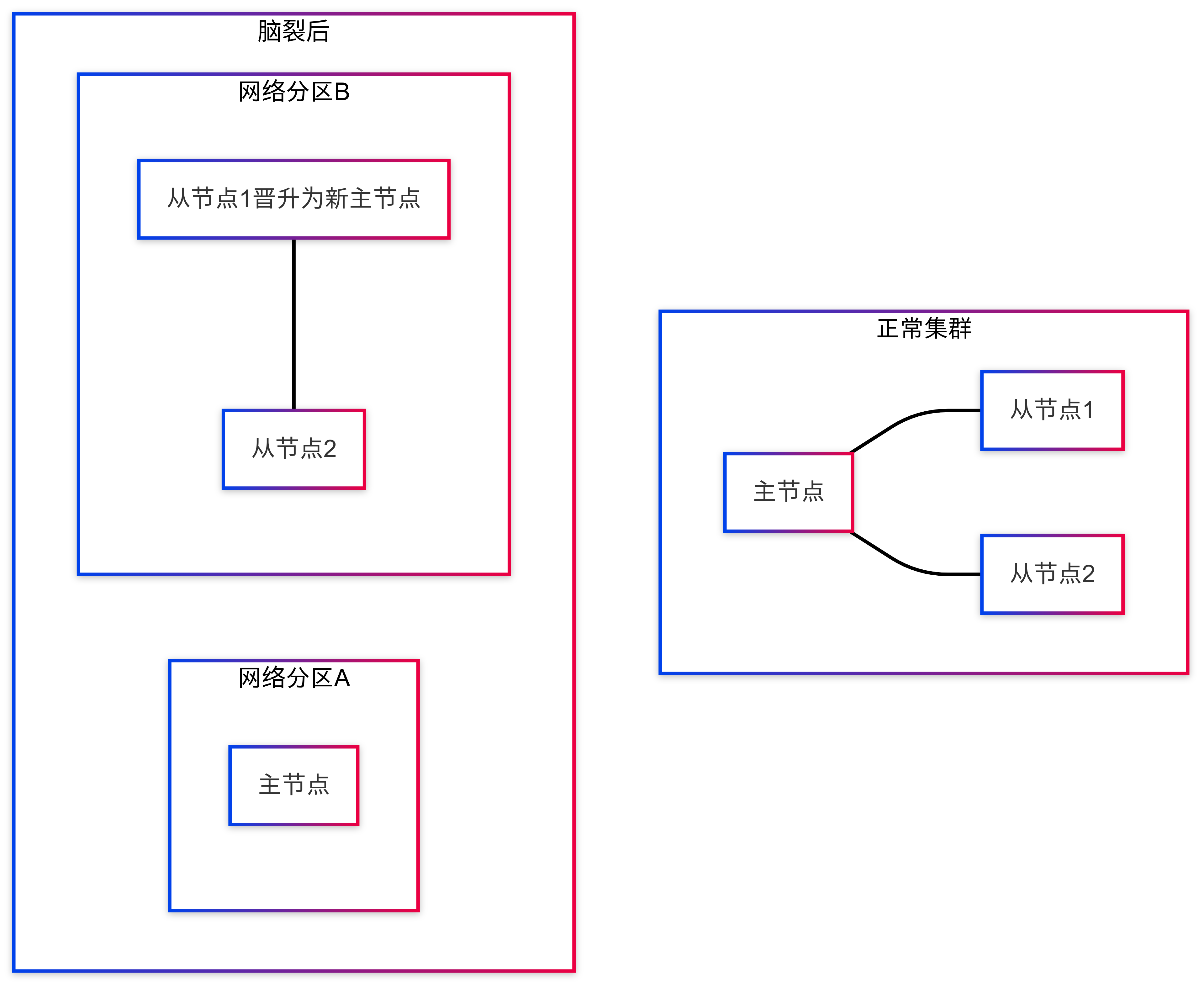

脑裂(Split-Brain),简单来说就是集群中的节点因为网络问题等原因,分裂成了多个小集群,各自"独立"工作,导致数据不一致。

脑裂产生的原因

Redis 集群脑裂主要由以下几个原因引起:

- 网络分区:机房之间的网络故障导致节点间通信中断

- 节点负载过高:主节点 CPU 或内存压力大,响应变慢

- 心跳超时配置不合理:心跳检测间隔太短或超时时间设置不当

- 意外重启:主节点服务器突然重启

实际案例分析

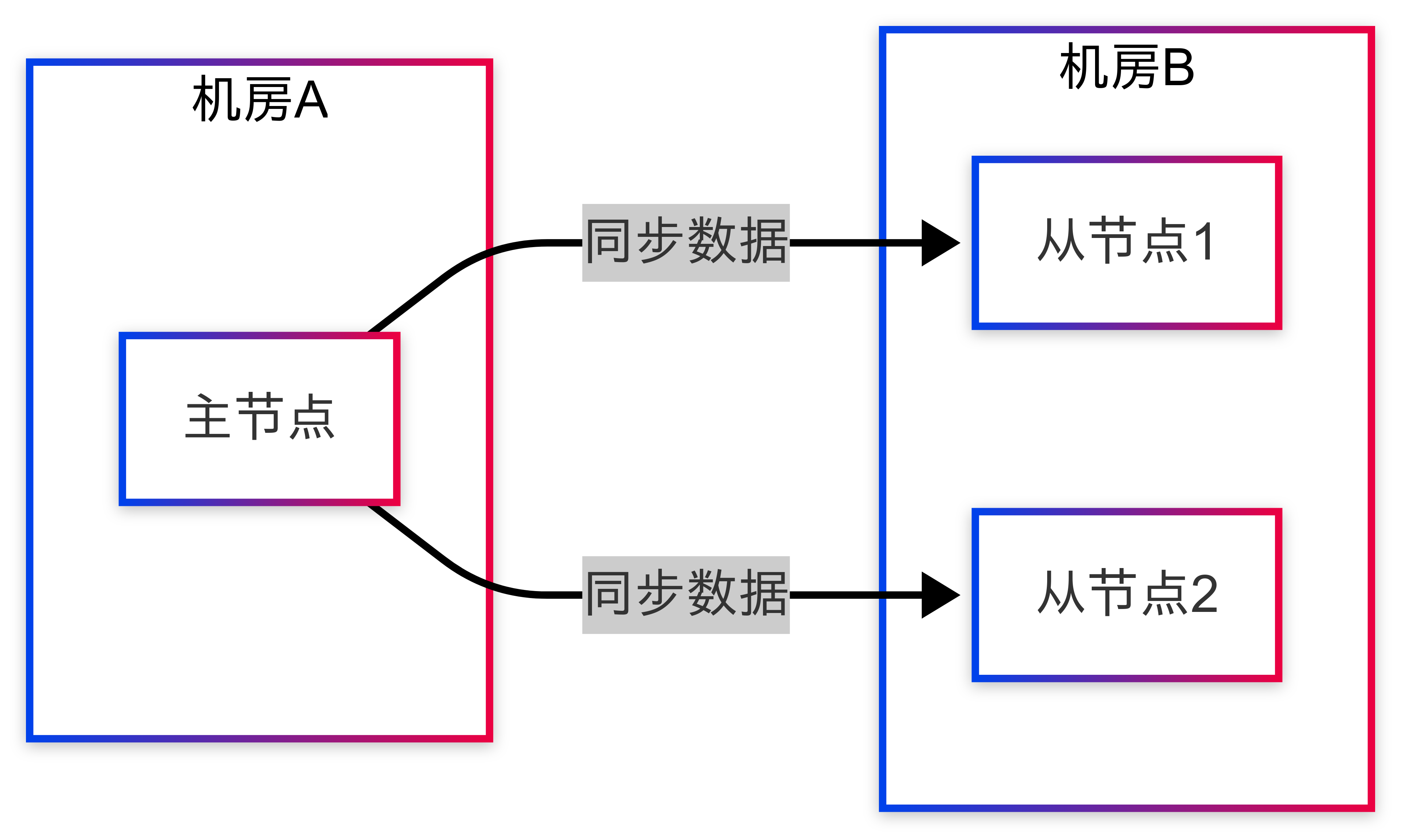

某金融支付平台在月底结算高峰期遇到了典型的脑裂问题。系统架构如下:

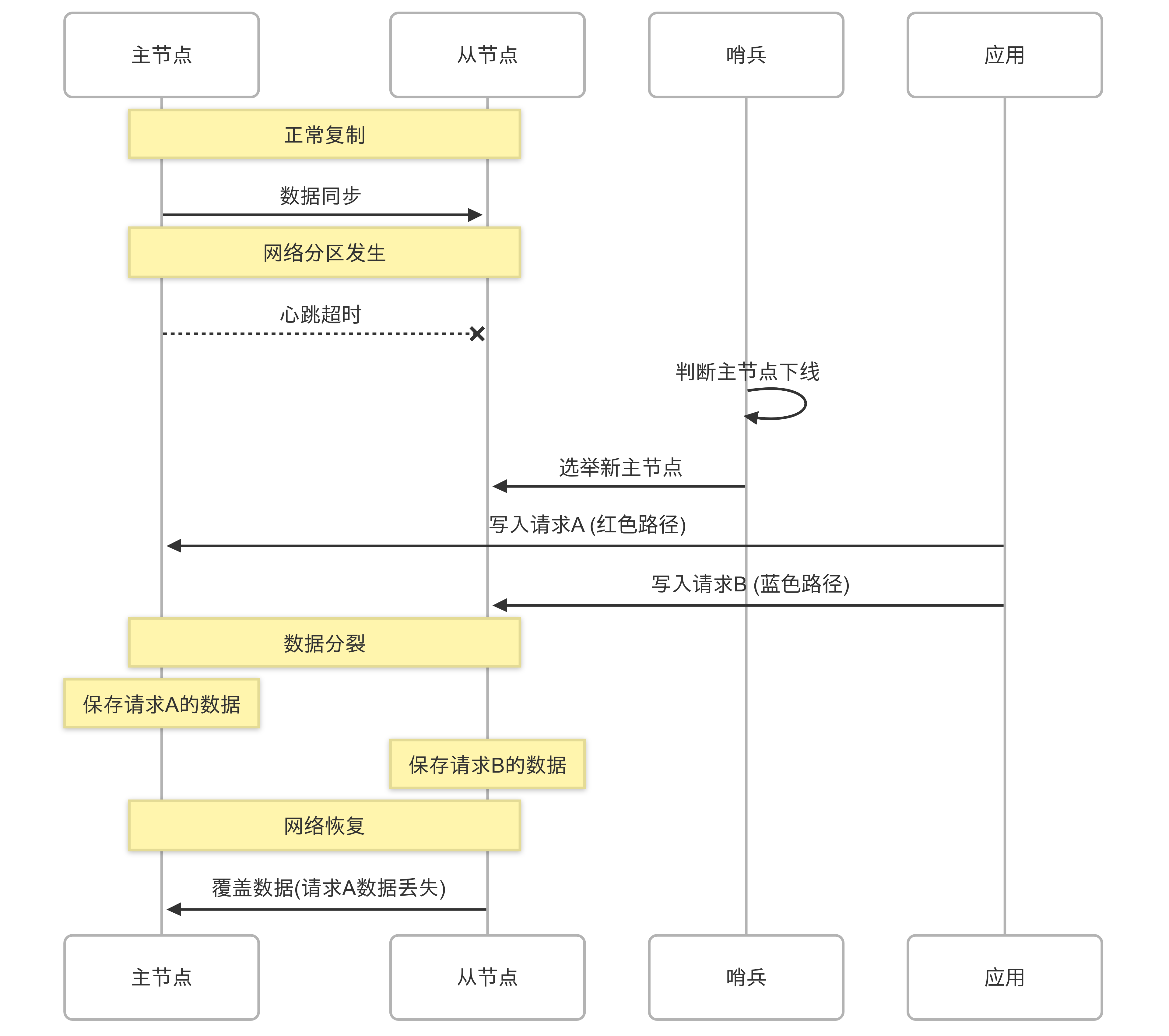

当机房间网络出现短暂抖动时,从节点们无法接收到主节点的心跳包。此时,哨兵(Sentinel)机制判断主节点已经下线,从从节点中选举了一个新的主节点。但实际上,主节点还在运行!

脑裂后的核心矛盾:主节点并不知道自己已被"废黜",仍然认为自己是主节点并继续接收写请求。同时,哨兵已选出的新主节点也开始接收写请求。这就导致了两个不同的"主节点"同时存在,各自维护不同的数据版本。

实际影响:

- 约 8%的交易记录被丢弃(主节点接收的交易未同步到新主节点)

- 数据不一致导致对账失败,账务系统出现差异

- 故障恢复耗时 45 分钟,期间部分支付渠道完全不可用

- 交易对账差异处理耗费了运维团队整整一周时间

如何检测 Redis 集群是否发生脑裂?

我们可以通过以下几种方式检测脑裂:

- 监控 info replication 输出:检查主从状态是否异常

- Redis 哨兵日志分析:检查是否有频繁的主从切换记录

- 监控 master_run_id 变化:每个 Redis 实例都有唯一标识符,比较各节点认知的主节点 ID

- 监控 master_link_status:从节点中的此值为"down"可能表示脑裂开始

脑裂问题解决方案

配置层面的预防

- 优化 Redis 配置

Redis 提供了三个重要参数来防止脑裂:

这些配置的作用是:当主节点发现从节点数量不足或者数据同步延迟过高时,拒绝写入请求,防止数据不一致。

重要说明:min-replicas-max-lag的单位是秒,与 Redis INFO 命令返回的lag字段单位一致。这确保了配置与监控的一致性。

- 网络质量保障

确保 Redis 集群节点间的网络稳定:

- 使用内网专线连接

- 避免跨公网部署

- 配置合理的 TCP keepalive 参数

- 多机房部署时:确保跨机房专线有冗余通道,避免单点故障

代码层面的解决方案

使用 Java 实现脑裂监控和自动恢复:

使用哨兵+主从架构预防脑裂

哨兵配置示例:

这个配置表示:

- 监控 IP 为 192.168.1.100,端口为 6379 的主节点

quorum=2表示至少 2 个哨兵认为主节点宕机才触发故障转移,这是避免单个哨兵误判导致脑裂的关键参数down-after-milliseconds设置为 5000ms(5 秒),这比默认值 30 秒小很多,能更快检测到故障,但也增加了误判风险,需根据实际网络情况调整- 故障转移的超时时间为 60 秒

parallel-syncs=1表示每次只允许一个从节点进行同步,这可以降低故障转移过程中新主节点的负载压力,间接减少脑裂的风险。限制同步节点数量避免新主节点因带宽/CPU 瓶颈导致响应超时,防止刚完成选举的新主节点再次被误判下线,形成"二次脑裂"auth-pass指定 Redis 密码,确保哨兵能在启用认证的情况下正常监控和管理 Redis 节点

哨兵集群规模设计:

- 哨兵节点数应为奇数(3/5/7),便于投票决策

- 哨兵应分布在不同物理机、机架甚至机房,避免因单点故障导致哨兵集群失效

quorum值设置为(n/2)+1(n 为哨兵数量),确保多数派共识

哨兵与脑裂的关系:

哨兵通过

gossip协议交换节点状态,当quorum数量的哨兵达成共识后才触发故障转移,这能有效避免因网络分区导致的"部分哨兵误判",从而减少脑裂概率。只有当绝大多数哨兵都同意主节点已下线,才会执行主从切换操作,这是防止脑裂的关键机制。

哨兵模式 vs Redis Cluster 对比:

哨兵模式主要解决高可用问题,通过主从复制和哨兵选举机制降低脑裂风险,适合中小规模部署;而 Redis Cluster(分片集群)主要解决数据分片问题,但因节点间通信更复杂,脑裂风险反而更高。在 Cluster 模式下,需额外注意

cluster-require-full-coverage参数设置,避免部分分区不可用导致整个集群拒绝服务。简单来说,如果你主要担心脑裂问题,哨兵模式比 Cluster 模式更容易管理。

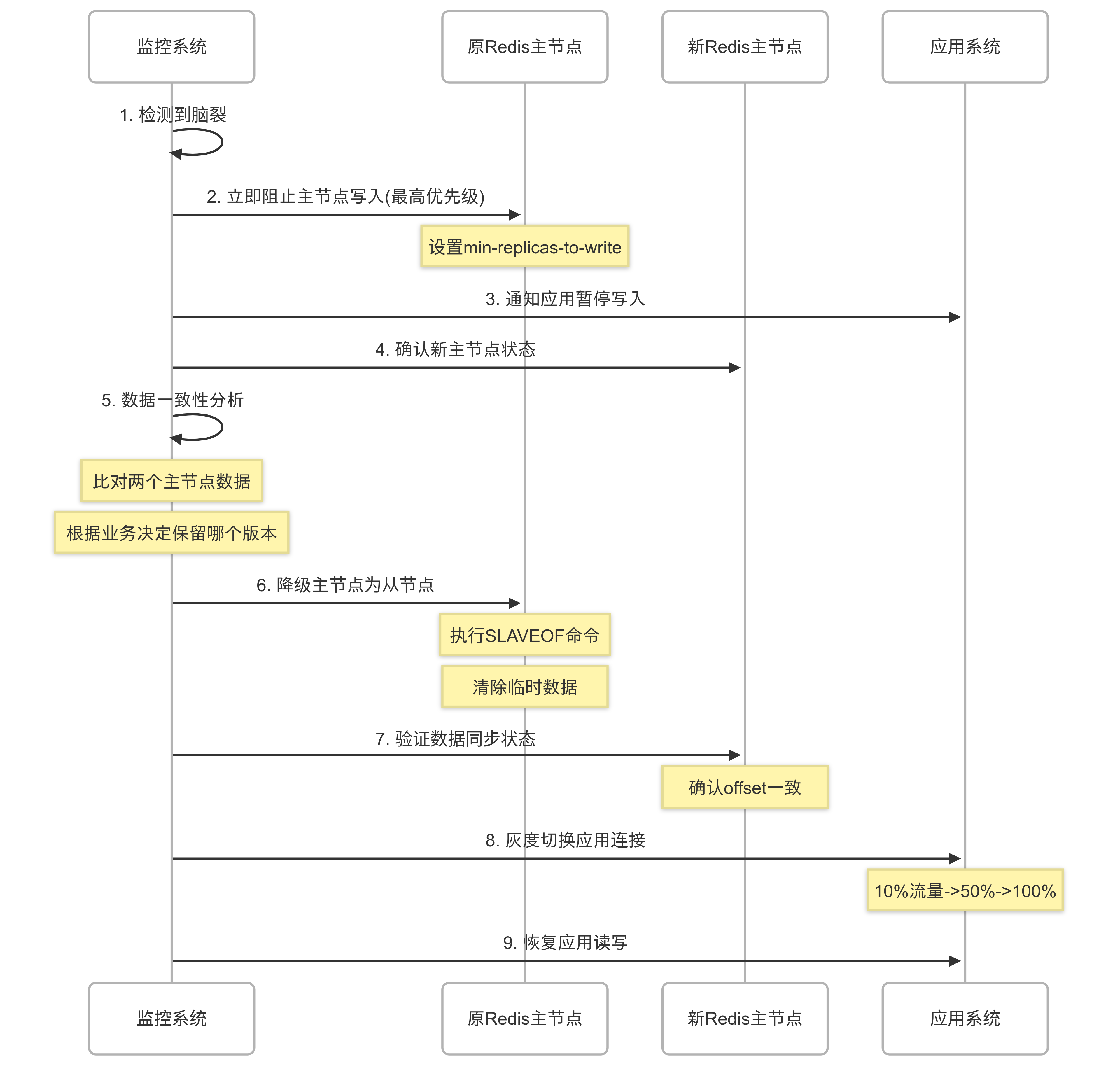

Redis 集群脑裂的恢复流程

当检测到脑裂发生后,恢复流程如下:

数据一致性恢复策略:

- 以新主节点为准:最简单的策略,但会丢失原主节点未同步的写入,适合允许少量数据丢失的场景(如缓存、日志类数据)

- 数据合并:复杂但保留双方数据,需业务层支持冲突解决,适合金融、订单等强一致性要求的业务场景

- 时间戳对比:根据数据的时间戳决定保留哪个版本,要求业务数据包含可靠的时间戳字段

数据一致性验证工具:

- Redis 官方工具

redis-cli --rdb导出 RDB 文件进行对比 redis-dump工具可以将数据导出为 JSON 格式,便于差异比对redis-compare-tool可用于快速比对两个 Redis 实例的键差异

恢复过程中的风险控制:

- 数据一致性验证前先做 RDB 备份,确保有回滚能力

- 应用连接切换采用灰度方式,避免新主节点承受突发流量

- 设置明确的回滚触发条件:如连续 3 次写入错误率超过 0.5%,或单一批次错误率超过 2%时立即回滚

- 灰度阶段每批次保持 5 分钟观察期,确保系统稳定后再增加流量比例

实战场景:金融支付系统的 Redis 防脑裂方案

在金融支付系统中,交易记录、账户余额等都是关键信息,不容有失。针对这种场景,推荐以下 Redis 集群防脑裂策略:

1. 业务层防护

金融系统的业务层防护至关重要:

2. 实际监控代码

3. 压测复现脑裂问题

在测试环境中可以使用 Linux 的tc(Traffic Control)工具模拟网络分区,复现脑裂:

测试前的准备工作:

- 备份所有关键数据(主节点和从节点的 RDB 文件)

- 暂停依赖 Redis 的非核心业务

- 准备好回滚方案,设置好监控告警阈值

- 通知相关团队,确保测试时段内有人员待命处理可能的问题

测试成功的判断标准:

- 哨兵在 10 秒内检测到主节点"下线"

- 30 秒内成功选举新主节点

- 应用系统在 45 秒内自动进入只读模式

- 网络恢复后 60 秒内自动完成数据同步

- 灰度切换过程中错误率不超过 0.1%

4. 云原生环境中的 Redis 部署

在 Kubernetes 环境中部署 Redis 集群时,需要特别注意以下配置以避免脑裂:

K8s 环境中的实战经验:

- 使用 StatefulSet 而非 Deployment,确保稳定的网络标识

- 配置 Pod 反亲和性,将 Redis 节点分散到不同物理机

- 使用高性能 StorageClass,避免磁盘 IO 成为瓶颈

- 设置资源限制,防止节点过载

- 使用网络策略(NetworkPolicy)限制 Redis 集群内部通信,提高安全性

混沌工程实战:主动注入脑裂故障

为了验证系统在脑裂场景下的稳定性,可以采用混沌工程原则,定期进行故障注入测试:

- 周期性脑裂模拟:每月进行一次主从网络隔离测试

- 故障自愈验证:验证自动检测和恢复机制是否正常工作

- 数据一致性检验:测试后对比主从数据,验证恢复效果

使用 Chaos Monkey 实现自动化故障注入:

测试成功标准:

- 监控系统在 30 秒内识别出脑裂风险

- 防护措施在 60 秒内自动激活

- 应用系统在 75 秒内进入降级模式

- 网络恢复后,数据同步时间不超过 2 分钟

- 全部恢复后,数据一致性校验通过率 100%

这些明确的指标可以帮助评估你的系统在脑裂场景下的表现,持续改进防护措施的有效性。

标准化应急预案

针对 Redis 脑裂,建立标准化应急预案非常重要:

1. 故障确认阶段

- 触发条件:至少 3 个监控指标异常(如 connected_slaves=0、master_link_status=down、master_run_id 不一致)

- 确认步骤:

- 检查各节点

INFO replication输出 - 验证哨兵日志中的主节点感知状态

- 确认应用侧是否有写入错误增加

2. 应急处理阶段

- 应急小组:DBA 负责人、应用开发负责人、网络工程师

- 处理流程:

- 立即阻止继续写入:设置

min-replicas-to-write(最高优先级) - 触发告警:通知应急小组

- 判断主节点:根据哨兵多数意见确认"真"主节点

- 手动强制切换:必要时使用

SENTINEL FAILOVER命令

3. 数据恢复阶段

- 数据一致性检查:

- 对比主从节点数据(可使用 Redis 官方工具

redis-cli --rdb导出比对) - 根据业务时间戳确认最新数据

- 数据恢复策略:

- 普通缓存数据:以新主节点为准

- 关键业务数据:执行差异合并或回放丢失事务

4. 恢复与回顾

- 灰度恢复:

- 10%应用流量接入

- 监控 1 分钟无异常后扩大到 50%

- 再观察 5 分钟无异常后全量恢复

- 后续优化:

- 记录恢复时间(RTO)和数据丢失量(RPO)

- 分析根因并更新预防措施

总结

问题 |

原因 |

解决方案 |

实战经验 |

脑裂定义 |

集群分裂成多个独立工作的部分 |

- |

理解原理是解决问题的基础 |

产生原因 |

网络分区、节点负载过高、心跳超时配置不合理、意外重启 |

网络优化、硬件升级、参数调优 |

合理规划网络拓扑,避免跨公网部署 |

危害 |

数据不一致、服务中断、性能下降 |

快速检测和自动恢复 |

建立多指标监控体系(包括 master_run_id、master_link_status 等) |

预防策略 |

- |

min-replicas-to-write、min-replicas-max-lag 参数配置 |

奇数个哨兵(至少 3 个),quorum≥(n/2)+1,跨机架部署 |

代码实现 |

- |

异常处理完善的监控代码、健壮的字段解析、自动恢复逻辑 |

结合业务特性实现数据一致性保障机制(如版本号、分布式锁) |

架构设计 |

- |

哨兵模式、多机房冗余部署、云原生适配 |

根据 RTO/RPO 要求选择架构,确保网络冗余设计 |

恢复流程 |

- |

标准化应急预案、灰度恢复策略、数据一致性工具 |

定期混沌工程测试,优化恢复时间,明确数据恢复策略 |