前言

我在此文《ForceVLA——将具备力感知的MoE整合进π0的动作专家中:从而融合“视觉 语言 力反馈”三者实现精密插拔》的开头说过,我司「七月在线」目前侧重以下两大本体的场景落地

- 人形层面,侧重

1.1 人形灵巧操作

1.2 人形展厅讲解 - 机械臂层面,侧重

2.1 智能装配

2.2 精密插拔

而训练人形机器人做灵巧操作的方式之一便是从人类视频中学习

当然,此类模型,如今已经层出不穷了,且真实机器人数据采集在模仿学习领域推动了机器人操作的重大进展,然而,数据采集过程中对机器人硬件的依赖从根本上限制了数据的规模

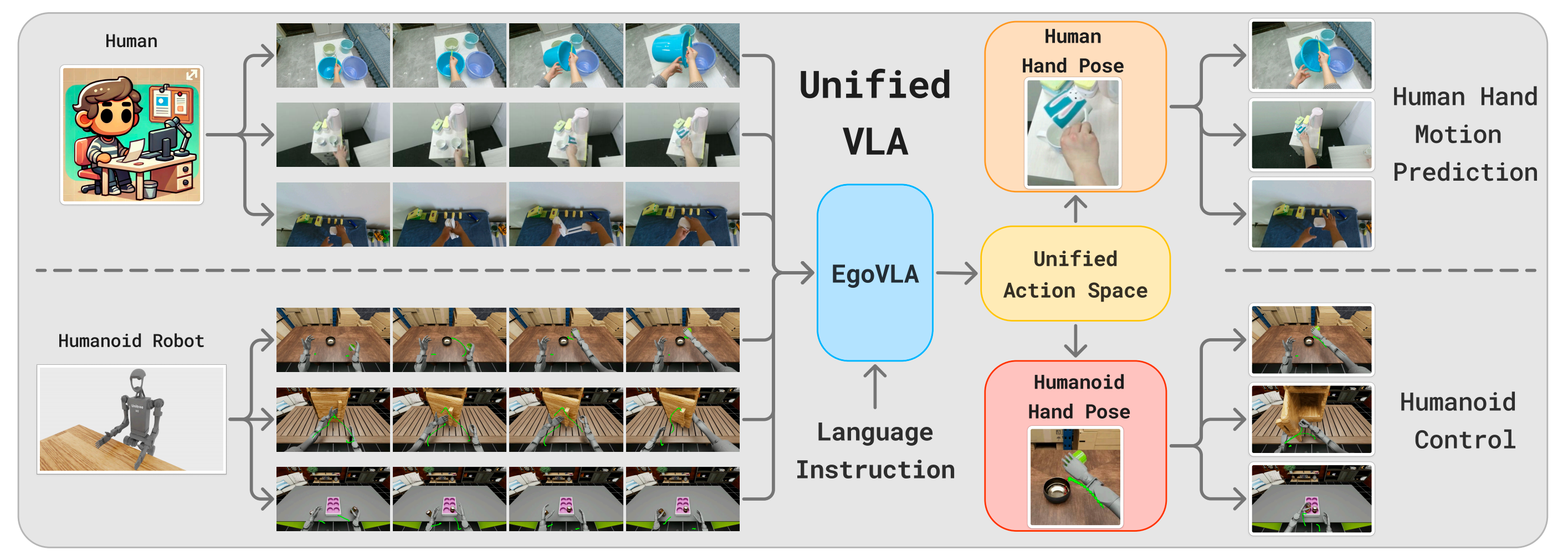

- EgoVLA探讨了利用第一视角人类视频训练VLA模型的方法

使用人类视频的优势不仅在于其规模,更重要的是场景和任务的丰富性 - 通过在预测人类手腕和手部动作的人类视频上训练的VLA,可以执行逆运动学和动作重定向,将人类动作转换为机器人动作

且仅需少量机器人操作演示对模型进行微调,便可获得机器人策略

第一部分 EgoVLA

1.1 引言、相关工作

1.1.1 引言

如EgoVLA原论文所说,近年来,得益于大规模真实机器人数据采集[1,2],机器人操作领域取得了巨大进展。与利用仿真方法相比,直接用真实机器人数据进行监督学习能够避免Sim2Real域间差异,并能轻松提升任务复杂度

- 为了高效采集复杂的机器人操作数据,研究人员提出了多种遥操作工具,包括关节映射[3,4,5]、外骨骼[6,7,8]以及虚拟现实设备[9,10,11]。尽管这些方法令人鼓舞,但对机器人和专家操作员的需求从根本上限制了可采集数据的规模

- 从人类视频中学习操作如何?如果将人类视为一种特殊形式的机器人,那么全世界有80亿个机器人正在各类环境中持续运行——而我们希望机器人能够在这些环境中操作

近期关于手-物体交互预测的研究[12]在预测人类操作的长期意图方面取得了有希望的成果。如果能够利用这些人类数据来训练机器人策略,不仅能够轻松扩展训练数据的数量,更重要的是能够提升任务和场景的多样性

这使得机器人能够在当前难以适应的场景或即使远程操作也具有挑战性的任务中进行训练

作者的关键观察是:人类动作空间与机器人动作空间之间的差异可能并不大,并且可以通过少量几何变换进行近似

与其在机器人数据上训练机器人视觉-语言-动作(VLA)模型[13,14,15,16],来自1 UC San Diego, 2 UIUC, 3 MIT, 4 NVIDIA的研究者提出在人体数据上训练人体第一视角VLA(EgoVLA)

- 其对应的论文为:EgoVLA: Learning Vision-Language-Action Models from Egocentric Human Videos

- 其项目网址为:rchalyang.github.io/EgoVLA/

截止到25年8月中旬,他们暂未开源,如果他们计划开源,则期待

具体而言

- 给定若干帧视觉观测、语言指令以及当前手部姿态作为输入,VLA将在未来几个步骤内预测人类动作

动作空间包括人类手腕和手部关节角度。这个人类动作空间可以通过逆向运动学将手腕位置转换为末端执行器位置,并通过动作重定向将人类手部关节转换为机器人手部关节,从而转化为机器人动作空间 - 因此,人体VLA本质上已经是一种机器人策略,只是输入为人手图像,且动作输出仍存在误差。但可以通过遥操作收集少量机器人演示,对VLA进行进一步微调来纠正这一点

如此,便无需大规模机器人数据进行训练

为了评估机器人操作性能,作者提出了一种基于NVIDIA IsaacSim[17]的新型仿人双臂操作基准测试,称为Ego Humanoid Manipulation Benchmark。在该基准测试中,作者设置了12项任务,包括执行原子动作的简单任务以及由多个原子动作组合而成的长时序任务

作者为每个任务收集了100个演示数据,并利用该基准测试对模型进行评估。在实验中,作者首先在Ego-Centric Human Manipulation数据集上训练EgoVLA模型,并针对特定任务在收集到的仿人操作演示上进行微调,说白了,就是通过人类第一视角的视频做预训练,然后用真机数据做微调

1.1.2 相关工作:涉及灵巧操作、VLA

第一,对于灵巧操作

灵巧操作的研究已从基于控制的方法[19,20,21,22,23,24,25]发展到以学习为驱动的方法[26,27]

- 早期工作侧重于精度,但在多样化场景中的泛化能力有限。基于学习的方法引入了姿态向量生成[28,29,30]、中间表示[31,32]和接触图[33,34],但大规模灵巧操作仍然是一个未解难题

- 近期的研究尝试利用第一视角人类视频训练特定任务的策略[35,36]

相比之下,作者旨在直接通过第一视角人类演示开发通用型操作模型

第二,对于VLA

- 视觉-语言模型(VLMs)[37,38,39]在多模态任务中展现出了强大的泛化能力[40,41,42,43,44]。在此基础上,视觉-语言-动作模型(VLA)[16,14,45,13,15,46]通过大规模机器人数据对VLMs进行微调,实现了感知与动作的集成

- 然而,VLA的训练对数据需求极高,通常需要大量的远程操作[47,48]或脚本化执行[49,50]。OpenVLA[14]和Octo[13]利用了众包机器人数据集[1],但在可扩展性方面仍面临瓶颈

作者提出了一种替代方案:通过人类第一视角视频进行策略学习,并结合小规模目标域微调

第三,对于第一人称视觉

- 第一人称视觉研究[51,52,53]传统上在数据规模和多样性方面受到限制。近期的数据集[54,55]在覆盖范围上有所提升,但主要关注超出现有机器人能力的活动。更简单的数据集[56,57]虽然捕捉了日常交互,但缺乏姿态标注

- 为了解决这一问题,作者精选了有针对性的数据集组合,并引入了一个专为灵巧操作学习优化的第一人称人体视频数据集

第四,对于从野外视频中学习

- 已有多项研究 [58,59] 提出从野外视频中提取可供性或交互线索。受第一视角视觉的启发,近期研究 [60,61,62,63,64,65,66] 利用人类视频进行预训练表征,并展示了积极的迁移效果

- 然而,大多数工作侧重于无监督学习,未充分利用细粒度的手部或手腕姿态信息

相比之下,作者的工作在VLA框架下使用高质量的第一视角数据,直接提升灵巧策略学习,充分利用可穿戴手部追踪技术的最新进展

1.2 从第一人称人类视频中学习操作技能

本节将介绍作者第一人称人类操作数据集的构建过程,EgoVLA在该数据集上的训练方法,如何弥合人类与仿人机器人之间的体现差异,以及EgoVLA在操作任务中的部署

1.2.1 以自我为中心的人体操作数据集

借鉴语言模型和视觉-语言模型训练的经验,作者强调数据集结构在提升模型性能中的重要性

- 他们构建了一个大规模的人类第一视角操作数据集,专注于包含技能丰富的视频序列及其对应的姿态标注。该综合数据集包含第一视角的RGB观测、手腕姿态、手部姿态和摄像头姿态

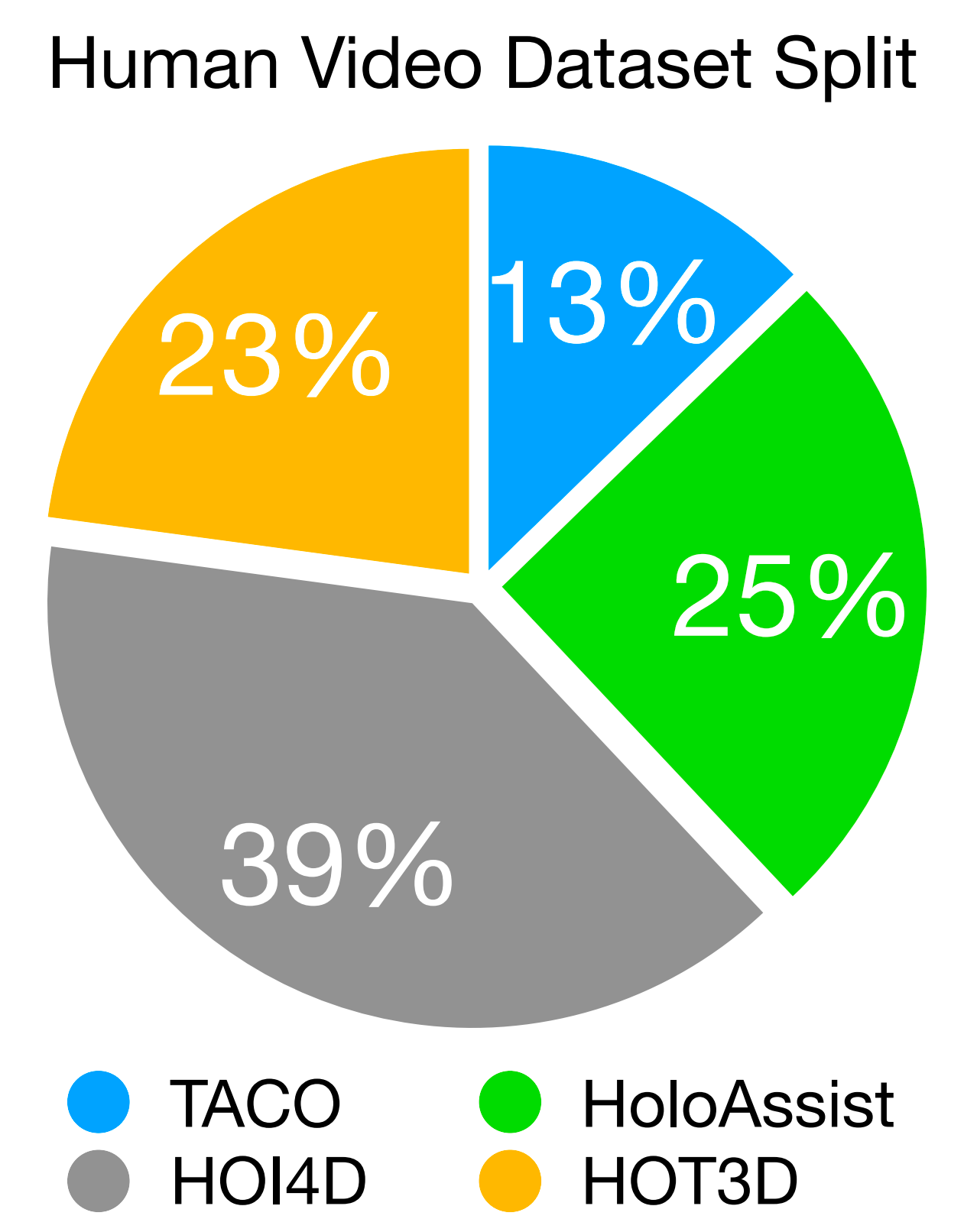

- 该数据集整合了来自四个来源的序列,其相对比例如图3所示:

HOI4D包含4000段视频,捕捉了如抓取-放置、重新定位和关节物体交互等单手操作

HOT3D提供了833分钟与33个刚性物体交互的视频,并配有精确的三维手部和摄像头姿态标注

HoloAssist则包含了166小时的复杂任务录制。例如电池更换、家具组装和机器安装

尽管其手部姿态标注较为噪声,但它捕捉了丰富的双手交互

且为避免HoloAssist因标签噪声而被过度代表,作者对其进行了1/10的均匀采样,以平衡任务和数据来源

TACO包含2,317个动作序列,涵盖151组工具-动作-物体三元组

对于数据处理:第一人称视频由于摄像机的持续移动,给学习带来了挑战

为了解决这一问题,作者利用世界坐标系下的摄像机位姿,将未来手腕的位置投影到当前摄像机帧中,从而确保监督的一致性。训练样本通过以3帧每秒的频率采样RGB观测值生成,以实现计算效率与时间连续性的平衡。他们的数据集共包含约500,000对图像与动作,涵盖多种操作任务

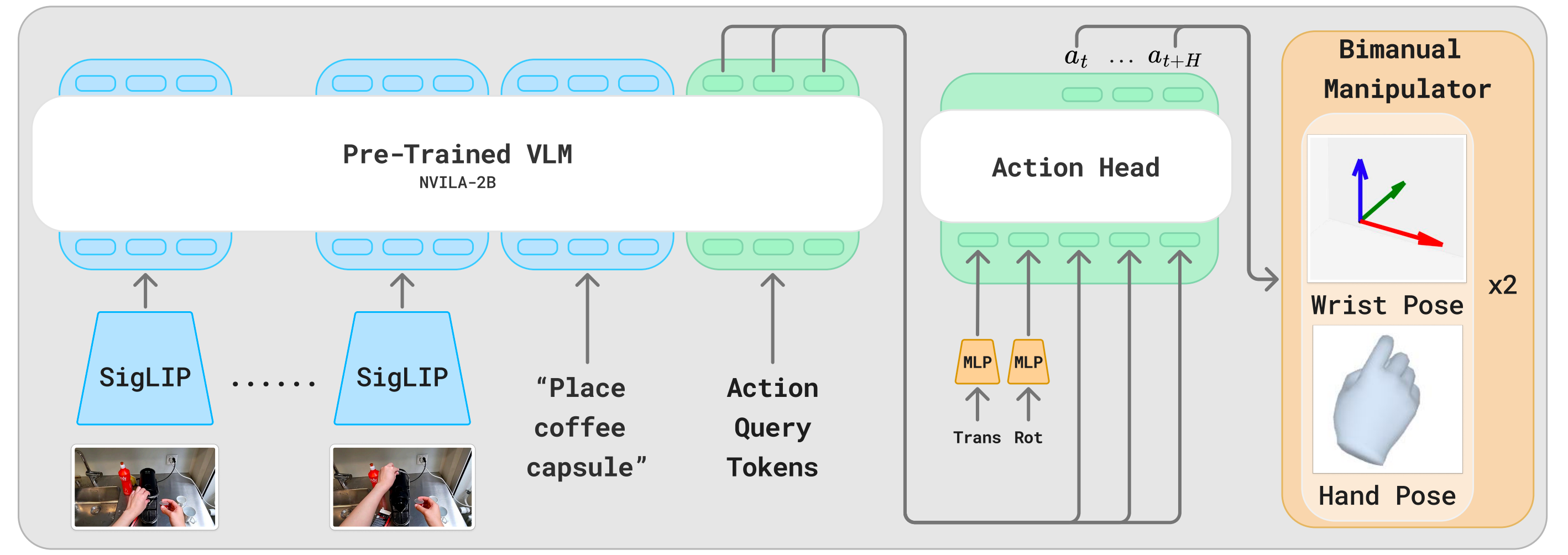

1.2.2 EgoVLA模型:基于NVILA-2B + 基于Transformer的动作头

作者在视觉-语言模型的基础上构建了EgoVLA,以利用强大的视觉和语义推理能力

- 具体而言,他们采用NVILA-2B[67]作为主干网络,该模型具有强大的视觉-语言理解能力和紧凑的体积,从而实现意图推断和高效微调

如图2所示「EgoVLA以视觉历史、语言指令和动作查询token作为输入。潜在特征通过动作头被转换为人类动作。且采用手腕姿态和MANO手部参数[18]作为人类动作空间」

EgoVLA的输入包括当前和历史的第一视角视觉观测、语言指令、动作查询token以及人体本体感知

这些输入由VLM主干网络进行编码,并通过动作头进一步处理,以预测未来的人类或机器人动作

其中

视觉观测由六帧RGB图像组成:包括当前观测帧以及以0.2秒间隔采样的前五帧,总共覆盖1秒的历史。每帧分辨率为384×384

语言指令用于描述即时期望的行为。该设计使模型聚焦于技能执行,而非高层次规划,从而确保语言输入与预测动作之间具有清晰的映射关系

人体本体感状态包括手腕的平移/旋转以及手部姿态参数。这些信息在传递至动作头之前,会通过多层感知机(MLP)进行处理

- 每个预测动作包括腕部姿态『相机坐标系下的三维平移和 rot6D 表示[68]的旋转』以及手部关节角度,后者通过 MANO 手部模型[18]的前 15 个主成分(PCA)表示,说白了,就是通过MANO给人手手部关节建模,类似SMPL给人体建模一样

EgoVLA被训练用于回归相机坐标系下的未来腕部姿态和手部关节参数。其目标函数为:

其中

和

分别为腕部平移和手部关节角度回归的 L2 损失。

是 rot6D[68] 腕部朝向的旋转损失。

、

、

为加权系数

至于动作头是一个基于 Transformer(300M)的结构,由六个编码器层组成,每层隐藏单元数为1536

它的输入包括人类(或机器人)的本体感觉状态,以及与动作查询token对应的潜在嵌入表示,并预测一个在1秒时间范围内的动作序列(以30 Hz的频率,未来30步)用于双手

作者使用词汇表中最后的H=30个词ID作为动作查询token

对于训练细节:作者首先在自有的第一视角人类操作数据集上对EgoVLA进行预训练,共20个周期。随后,在机器人示范数据上进行115个周期的后续训练,其中在第100个周期后降低学习率

在训练过程中,包含视觉编码器在内的整个模型都会进行微调。更多训练配置详见补充材料

1.2.3 将EgoVLA迁移到人形机器人

人类和人形机器人在操作框架上具有相似性,均使用双臂和双手。然而,由于摄像头姿态、手部形态以及视觉外观的差异,直接将EgoVLA迁移到人形机器人上具有一定挑战性

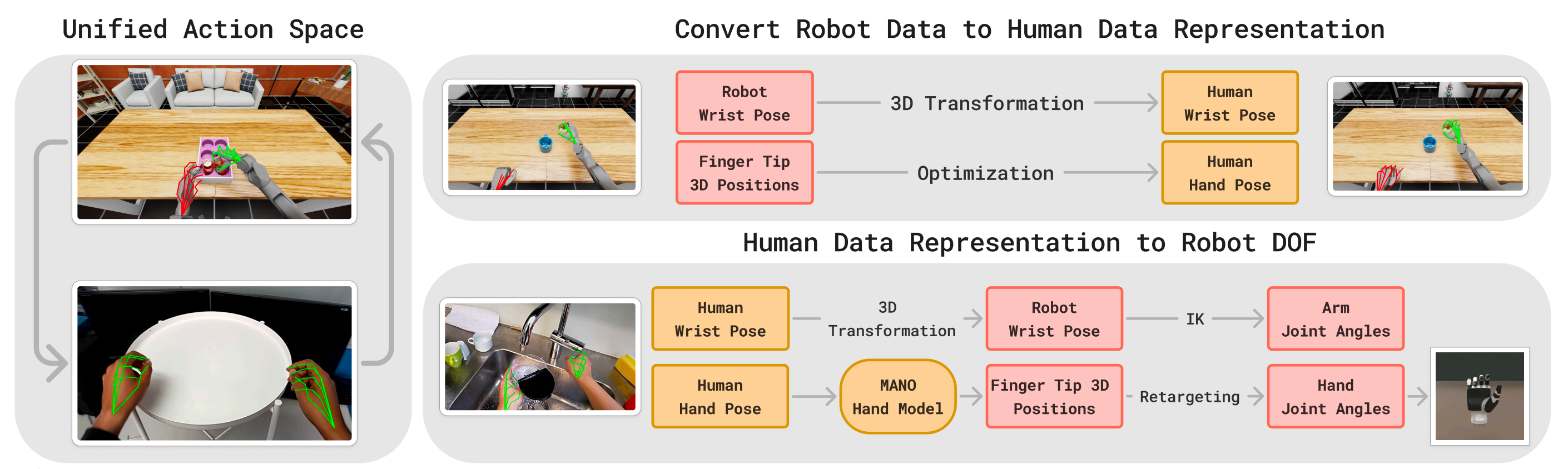

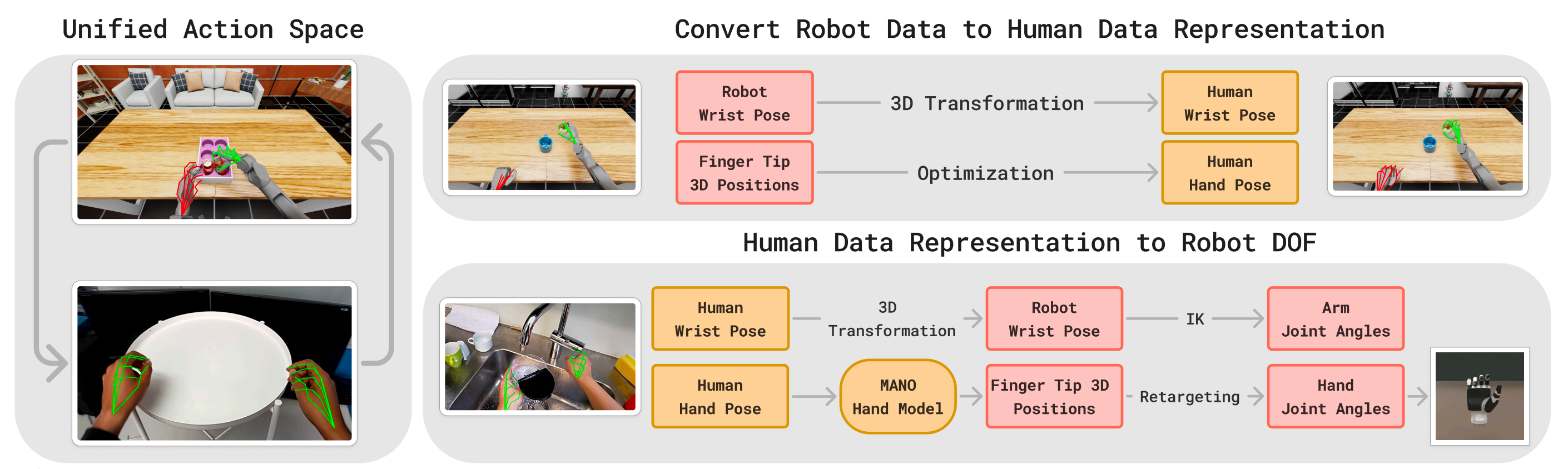

为实现部署,作者利用少量机器人演示数据对EgoVLA进行微调,并借助如图4所示的统一动作空间『统一动作空间:MANO手部参数被用作人类与机器人共享的动作空间。对于机器人手,在训练过程中,优化后的MANO参数能够产生与机器人手指尖相同的位置。在部署阶段,一个小型MLP将预测的指尖位置映射为关节指令』

首先,对于将机器人数据重新映射到人类表示

为了在机器人数据上进行微调,作者首先需要将机器人的动作空间与人类表示对齐

- 对于末端执行器的姿态,通过三维变换来对齐机器人和人类的坐标系

- 对齐手部配置则更加复杂:作者估算能够最好地近似机器人手部驱动的MANO[18]参数(相当于通过SMPL模型近似人体姿态),通过最小化预测(人体)指尖位置与(机器人)观测指尖位置之间的差异来实现:

其中

为MANO手部参数

表示通过MANO正向运动学计算得到的(人类的)指尖位置

为观测到的机器人指尖位置

该统一动作空间使得EgoVLA可以直接在机器人演示数据上进行微调,无需额外的架构更改或重新初始化

其次,对于人体手到机器人手的映射

在推理阶段,由EgoVLA预测的手腕和手部姿态会被映射到机器人的执行器,如图4(底部行)所示

- 首先,手腕姿态通过三维变换被转换为机器人末端执行器的姿态,并通过逆向运动学(IK)求解相应的手臂关节角度

其次,对于手部驱动,作者使用MANO模型根据预测的MANO参数计算三维手部关键点 - 然后,利用一个轻量级的多层感知机(MLP),根据三维手部关键点预测机器人手部的关节指令

该MLP在机器人演示数据上训练,其中手部动作被重新定向为人体手部的表示

This MLP is trained on robot demonstrations where hand actuations are retargeted into human hand representations.

该映射实现了平均指尖位置误差为米

此外,通过该重定向流程回放原始演示能够保持任务的有效性,表明重定向过程中引入的小误差不会显著影响控制性能。更多实现细节见补充材料

1.3 Ego 仿人操作基准

除了数据稀缺之外,基于学习的机器人技术面临的另一大挑战是缺乏可扩展、稳健且可复现的评估方式。现实世界中的评估通常成本高昂、耗时,并且存在安全性和可复现性的担忧——这些障碍在资源有限的环境(如学术实验室)中尤为突出

最新研究[69]表明,基于仿真的评估结果与现实世界性能高度相关,因此可作为可靠的替代手段

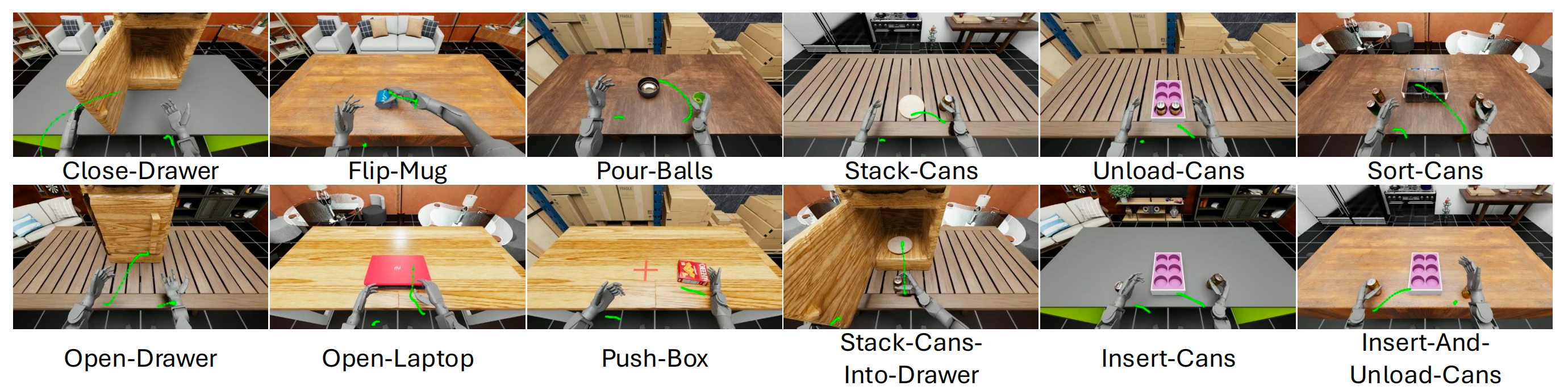

- 故为了实现仿人操作的一致性基准测试,作者提出了Ego仿人操作基准,该基准基于NVIDIA Isaac Lab[70]构建。Ego仿人操作基准并非用于直接的仿真到现实迁移,而是借鉴LIBERO[71]和SIMPLER[69]的做法,将仿真作为一个可控且可复现的测试平台,用于评估操作策略

- 作者的仿真平台采用Unitree H1[72]仿人机器人,配备两只Inspire灵巧手[73],涵盖了12项操作任务

既包括短时域原子动作(如推箱子、翻杯、倒球、关抽屉、开抽屉、开笔记本、叠易拉罐)

也包括长时域多阶段技能(如易拉罐分类、易拉罐插入、易拉罐卸载、插入并卸载易拉罐、将易拉罐叠入抽屉),如图5所示

此外,对于

- 观测与动作空间

作者的基准测试为观测提供了机器人关节位置、末端执行器位姿、接触力以及自中心RGB-D视觉输入

虽然EgoVLA仅使用自中心视觉、末端执行器位姿、手部关节驱动和任务描述,但还为未来研究提供了额外的模态

机器人通过末端执行器控制手臂,以及通过PD关节控制手部。每只手具有12个自由度(6个主动关节,6个联动关节)

最终的36维动作空间将手臂逆向运动学与手部直接驱动相结合。控制频率为30 Hz

且还为每个任务提供逐步的成功指示器和子任务完成标志。每个子任务的定义和成功度量标准详见补充材料 - 多样化视觉背景

仿真环境允许对视觉条件进行完全控制。比如包含了5种房间纹理(Room 1–5)和5种桌面纹理(Table 1–5),从而生成25种不同的视觉背景组合,用于对模型泛化能力的稳健评估 - 演示数据

为支持模仿学习,作者通过Meta Quest 3结合Open Television [10]采集了专家演示。演示数据均在Room 1、2或3中采集,桌面纹理固定为Table 1

针对每个任务,作者采集了100条成功的演示,单次演示的帧数根据任务复杂度在100至500之间

// 待更