一、选型背景

在做抓取项目的时候,总会遇到这样一个时刻:

要么是网站前端结构改了,原有采集逻辑一下子失效;要么是业务数据规模突然暴涨,服务器吃力、任务排队严重。这时候,团队就会面临一个经典问题——到底是直接在原系统上修修补补,还是干脆推倒重来?

很多人习惯把这两种方式称作“优化”和“重构”。

- 优化的思路,是在保留原有架构的前提下,针对性能、稳定性、安全性等方面做改进。

- 重构的做法,则更激进——直接重新设计采集流程、数据结构、调度方式,甚至替换底层框架。

选哪个方向,其实没有绝对答案,但错误的选择会浪费时间、人力,甚至影响业务节奏;选对了,则可以在短期或长期内显著提升采集能力。

二、技术对比维度

在实际评估中,可以从四个方面来比较:

首先,开发周期上,优化能很快见效,适合应急;重构则需要更长的时间投入,前期可能几乎看不到成果。

其次,技术债务方面,优化往往会保留一些老问题,而重构则有机会一次性解决历史遗留的设计缺陷。

再来看业务中断风险,优化可以做到“热修复”,不中断运行;重构可能需要停机切换,风险更高。

最后是性能潜力,优化受限于原架构,很难实现质的飞跃;重构可以引入异步、分布式等新技术,从根本上提升性能上限。

三、代码对比示例

下面用一个采集商品数据的例子,展示两种思路的实现差别。

1. 优化版(在旧架构中加入代理IP)

import requests

#代理IP配置 亿牛云示例 www.16yun.cn

proxy_host = "proxy.16yun.cn"

proxy_port = "3100"

proxy_user = "16YUN"

proxy_pass = "16IP"

proxy_meta = f"http://{proxy_user}:{proxy_pass}@{proxy_host}:{proxy_port}"

proxies = {"http": proxy_meta, "https": proxy_meta}

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"

}

url = "https://example.com/products"

try:

resp = requests.get(url, headers=headers, proxies=proxies, timeout=10)

if resp.status_code == 200:

print("采集成功(优化版):", resp.text[:200])

else:

print("采集失败:", resp.status_code)

except Exception as e:

print("请求出错:", e)

这种方式的好处是改动小,能迅速上线,但架构上的瓶颈依旧存在。

2. 重构版(基于异步爬虫+代理IP)

import asyncio

import aiohttp

#代理IP配置 亿牛云示例 www.16yun.cn

proxy_host = "proxy.16yun.cn"

proxy_port = "3100"

proxy_user = "16YUN"

proxy_pass = "16IP"

proxy_auth = aiohttp.BasicAuth(proxy_user, proxy_pass)

proxy_url = f"http://{proxy_host}:{proxy_port}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"

}

urls = [f"https://example.com/products?page={i}" for i in range(1, 6)]

async def fetch(session, url):

try:

async with session.get(url, headers=headers, proxy=proxy_url, proxy_auth=proxy_auth, timeout=10) as resp:

text = await resp.text()

print(f"采集成功(重构版):{url} -> {len(text)}字节")

except Exception as e:

print(f"采集失败:{url} -> {e}")

async def main():

async with aiohttp.ClientSession() as session:

tasks = [fetch(session, url) for url in urls]

await asyncio.gather(*tasks)

if __name__ == "__main__":

asyncio.run(main())

这种实现直接采用异步并发的方式,能够同时发起多个请求,大幅提高抓取速度,也方便后续接入分布式架构,但需要的开发投入和调试时间更多。

四、性能对比

有一次团队做内部测试,模拟抓取 100 页商品数据:

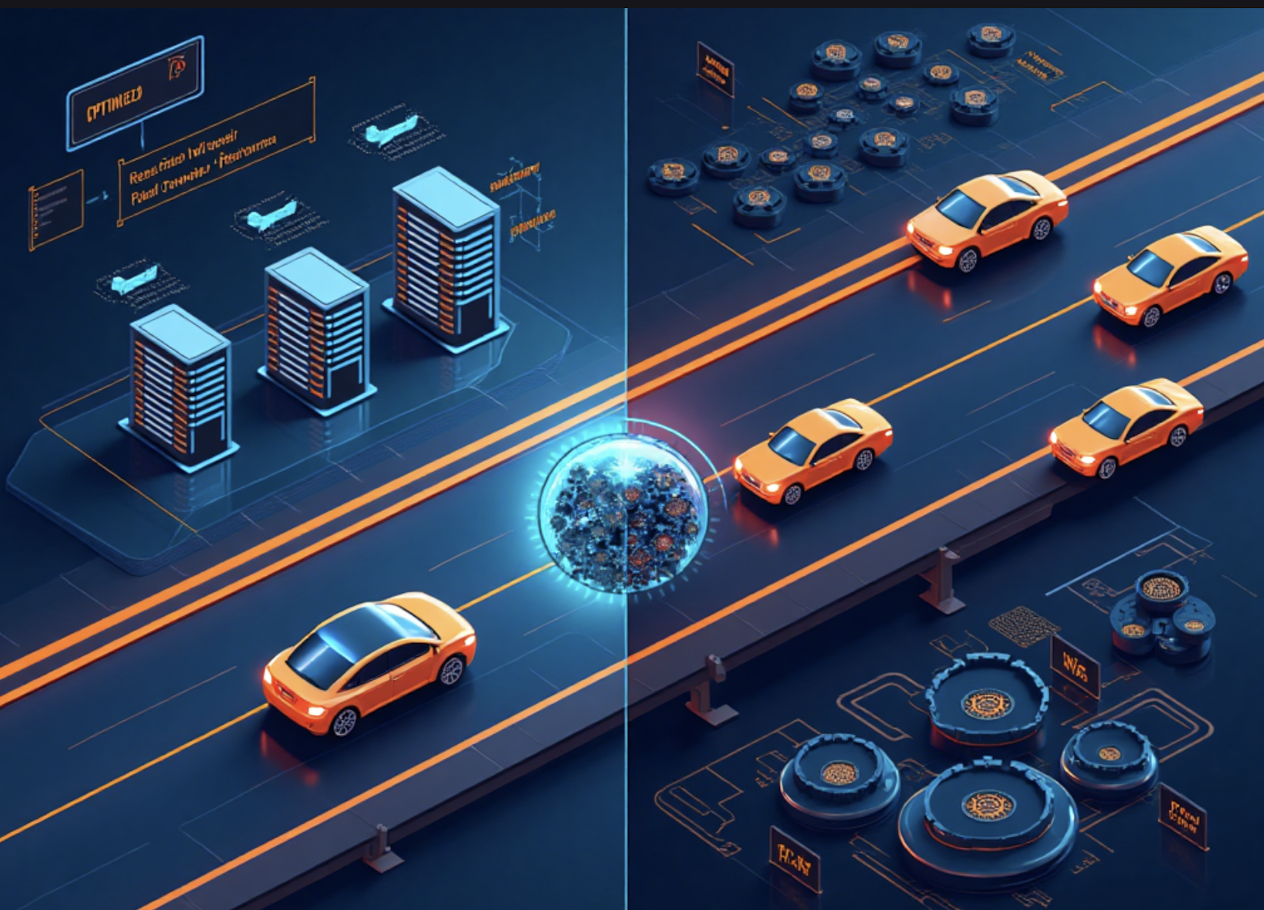

- 用优化版,整个流程像是在单车道公路上行驶——车速稳定,但一次只能跑一辆车。大约跑了 8 分钟才完成任务。

- 用重构版,感觉就像换上了多车道高速公路,几十辆车同时发车,虽然偶尔有几辆车被检查拦下,但整体只用了 1 分钟多一点就完成。

这个故事虽然简化了细节,但足以说明两种方案在速度上的潜力差异。

五、场景推荐

如果只是网站改动不大,数据量增长有限,而且业务不允许长时间停机,那么可以选择优化,在原有架构上做性能提升和防封措施。

如果现有系统的性能已经逼近极限,代码维护成本高,又有机会在时间和人力上投入更多,那么一次性重构会更划算,能为后续几年奠定更高的技术基线。

六、结论

抓取系统的升级,就像修房子和推倒重建一样,关键是判断当下的状况和未来的需求。

优化更像是短跑,见效快;重构则是马拉松,起步慢但潜力大。

实际项目中,很多团队会先用优化方案稳住业务,然后在条件成熟时启动重构,以兼顾稳定性和长期收益。