前文:

1.“端 - 边 - 云”三级智能协同平台的理论建构与技术实现:“端 - 边 - 云”三级智能协同平台的理论建构与技术实现-CSDN博客

2.抗量子计算攻击的数据安全体系构建:从理论突破到工程实践:抗量子计算攻击的数据安全体系构建:从理论突破到工程实践_狗狗币算法能否抗量子攻击-CSDN博客

3.无人机的飞行路径规划之CH-PPO算法:无人机的飞行路径规划之CH-PPO算法(思考)_ppo路径规划-CSDN博客

4.三维无人机航迹算法的目标函数如何确定:三维无人机航迹算法的目标函数如何确定_无人机目标函数-CSDN博客

5.有关物流无人机与快递配送的协同研究:有关物流无人机与快递配送的协同研究_面向超低空物流场景的多机协同航迹规划算法:针对城市超低空物流场景下多无人机的-CSDN博客

一、系统理论基础

(一)多传感器融合理论体系

1. 融合层级与技术特性

多传感器融合技术依据处理层次可划分为数据层、特征层与决策层融合,各层级在信息处理深度和应用场景上存在显著差异:

(1)数据层融合:直接对毫米波雷达点云(极坐标序列)和双目视觉图像(像素矩阵)进行时空配准后融合。此层级保留原始数据完整性,但对传感器时间同步精度(误差需<1ms)和空间标定精度(平移误差<1cm,旋转误差<0.5°)要求极高。例如,雷达与相机需通过硬件触发实现微秒级同步,避免动态目标的位置偏移。

(2)特征层融合:提取雷达点云的速度(多普勒频移计算)、反射强度(dBm值)和视觉图像的边缘(Canny算子)、角点(ORB特征)、语义标签(YOLOv5输出)等特征,通过特征关联算法(如匈牙利算法)实现跨模态融合。该层级降低数据维度的同时保留关键信息,适用于计算资源有限的无人机平台。

(3)决策层融合:基于各传感器独立决策结果(如雷达的目标距离估计、视觉的目标类别判断)进行贝叶斯推理或投票决策。其容错性强,可处理异步传感器数据,但存在决策延迟(约 50-100ms),适用于非实时性要求的场景。

多传感器融合按处理层次分为三类,其技术特性与应用场景对比如下:

层级 |

处理对象 |

关键技术 |

优势 |

局限性 |

典型应用 |

数据层 |

原始信号 / 像素 |

时空配准、点云 - 图像投影 |

保留原始信息 |

对同步精度要求极高 |

静态场景建图 |

特征层 |

特征向量(如 SIFT、速度) |

特征提取、关联匹配(如匈牙利算法) |

降维且保留关键信息 |

特征提取依赖算法鲁棒性 |

动态目标跟踪 |

决策层 |

传感器独立决策结果 |

贝叶斯网络、D-S 证据理论 |

容错性强、异步兼容 |

存在决策延迟 |

非实时安全监控 |

2. 融合核心目标与挑战

核心目标:通过融合毫米波雷达的全天候穿透能力(不受光照、雾霾影响)与双目视觉的高分辨率语义信息(目标类别、纹理特征),实现对动态环境的精准感知,提升无人机在复杂场景(如城市峡谷、森林穿越、夜间作业)中的障碍物检测、目标跟踪与路径规划能力。 关键挑战:

(1)时空同步误差:雷达与相机的采样频率差异(如雷达10Hz,相机30Hz)、时钟漂移导致数据不同步。

(2)空间标定精度:雷达坐标系与相机坐标系的外参标定误差(平移向量![]() 、旋转矩阵R直接影响目标位置解算精度。

、旋转矩阵R直接影响目标位置解算精度。

(3)数据异构性:雷达点云为稀疏三维坐标极坐标转换为

笛卡尔坐标),视觉图像为二维像素矩阵,需建立跨模态映射关系。

3. 融合核心目标建模

融合系统的核心目标是最小化估计误差的协方差矩阵,设融合后状态估计为,其误差协方差

满足:

![]()

证明:基于线性无偏最小方差估计理论,假设雷达与视觉量测误差独立,融合后估计为两者的加权和![]() ,通过求导最小化

,通过求导最小化可得权重矩阵

![]() ,代入后化简即得上述公式,证毕。

,代入后化简即得上述公式,证毕。

二、数学基础与公式体系

(一)坐标系转换理论

1. 雷达极坐标→笛卡尔坐标变换

毫米波雷达测量的原始数据为极坐标,其中

为目标距离,

为水平方位角,

为垂直俯仰角。转换为笛卡尔坐标

的公式为:

几何证明:根据球坐标系与笛卡尔坐标系的几何关系,水平投影距离为![]() ,其在XY平面的分量由方位角θ决定,垂直分量为ρ sin ϕ,符合直角三角形投影关系。

,其在XY平面的分量由方位角θ决定,垂直分量为ρ sin ϕ,符合直角三角形投影关系。

2. 雷达-相机外参标定模型

设雷达坐标系为R,相机坐标系为C,目标在R中的坐标为,在C中的坐标为

,则从R到C的转换矩阵关系为:

![]()

其中![]() 为旋转矩阵,满足

为旋转矩阵,满足![]() 且

且![]() ;

;![]() 为平移向量。

为平移向量。

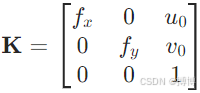

相机投影模型为:目标在相机像素坐标系中的坐标![]() 满足:

满足:![]()

其中 为相机内参矩阵,

为相机内参矩阵,为焦距,

为主点坐标,

![]() 为相机坐标系的齐次坐标。

为相机坐标系的齐次坐标。

3. 标定误差优化模型

采用张正友标定法结合雷达点云约束,构建最小二乘优化问题:

![]()

其中N为标定样本数,为第i个雷达点在图像中的投影像素坐标(通过角点检测或语义分割获取对应关系)。

(二)扩展卡尔曼滤波(EKF)理论

1. 时空配准算法

时间同步:采用线性插值法对雷达与相机数据进行时间对齐。设相机在时刻采样,雷达最近的前后时刻为

![]() ,则插值后的雷达坐标为:

,则插值后的雷达坐标为:

![]()

空间配准:通过外参R,T将雷达点云转换至相机坐标系,再利用相机内参K投影至图像平面。

2. 状态空间模型

目标状态向量定义为![]() ,状态转移方程为:

,状态转移方程为:![]()

其中 为线性化转移矩阵,Δt为采样间隔,

为线性化转移矩阵,Δt为采样间隔,![]() 为过程噪声,Q为对角矩阵表征加速度噪声。

为过程噪声,Q为对角矩阵表征加速度噪声。

3. 量测方程推导

融合雷达与视觉量测时,量测向量![]()

量测方程融合雷达与视觉数据:

其中,![]() 为量测噪声,R为对角矩阵,包含雷达距离/角度误差与视觉像素误差。

为量测噪声,R为对角矩阵,包含雷达距离/角度误差与视觉像素误差。

即满足方程:

其中![]() 为雷达量测噪声,

为雷达量测噪声,![]() 为视觉像素噪声,均服从高斯分布。

为视觉像素噪声,均服从高斯分布。

EKF 迭代过程包括预测与更新两步:

(1)预测步骤:

(2)更新步骤:

三、系统网络结构设计

(一)硬件架构设计

1. 传感器布局方案

(1)机械结构:采用三角布局减少遮挡,雷达居中,双目相机对称安装于两侧,雷达天线平面与相机光轴平面平行,基线距离b=20cm。

(2)同步设计:使用STM32微控制器生成100μs精度的同步脉冲,同时触发雷达(TI IWR6843,10Hz)和相机(Basler acA2500-20gm,20FPS)。

(3)接口设计:

1)雷达通过USB或SPI接口传输点云数据(含距离、角度、速度信息)。

2)双目相机通过USB3.0传输左右图像数据(分辨率1920×1080,帧率30fps)。

2. 处理单元架构

边缘计算节点:NVIDIA Jetson Xavier NX(6核Carmel ARM + 384-core Volta GPU),集成:

(1)传感器驱动模块:通过SPI接口读取雷达原始ADC数据,USB3.0接收相机图像流。

(2)预处理模块:基于CUDA实现点云去噪(体素滤波)和图像去畸变(OpenCV畸变校正)。

(3)融合模块:运行EKF跟踪与深度学习融合模型(如PointFusion)。

(4)通信模块:通过UART发送融合结果至飞控(Pixhawk 4)。

(二)软件流程设计

1. 完整执行流程图

四、工程化实现技术

(一)时空同步关键技术

1. 硬件同步方案

同步触发电路(C语言代码):

// STM32同步脉冲生成代码示例

TIM_HandleTypeDef htim;void SYNC_Init(void) {

htim.Instance = TIM3;

htim.Init.Period = 10000-1; // 100Hz触发频率

htim.Init.Prescaler = 84-1; // 84MHz时钟,1us计数周期

HAL_TIM_PWM_Start(&htim, TIM_CHANNEL_1);}时间戳同步:各传感器在触发时刻读取STM32的全局时钟(精度 ±10ns),确保时间戳误差<10μs。

2. 软件插值算法

针对雷达(10Hz)与相机(20Hz)的异步数据,采用线性插值实现同步:![]() 其中

其中![]() 为雷达采样时刻,

为雷达采样时刻,为对应时刻的点云坐标。

(二)点云-图像语义关联技术

1. 基于深度学习的跨模态匹配

(1)视觉分支:YOLOv5s模型(输入640×480)检测目标,输出二维框![]() 和类别标签(如"obstacle")。

和类别标签(如"obstacle")。

(2)雷达分支:将点云投影至图像平面,计算每个点(u,v)与检测框的IOU,保留IOU>0.5的点作为关联对。

(3)置信度融合:![]() 其中

其中为视觉检测置信度,

为雷达点反射强度归一化值。

五、Python 完整实现示例

当时示例使用纯OpenCV 4.11.0基础函数生成棋盘格图像,不依赖任何特定版本的aruco模块。安装OpenCV:pip install opencv-python

还要安装Mayavi,但是它的依赖库很多。

1. 安装编译工具(关键步骤)

mayavi依赖的VTK库需要编译环境,需先安装Visual C++构建工具:

官网下载并运行Visual Studio Build Tools:https://visualstudio.microsoft.com/zh-hans/visual-cpp-build-tools/

在安装界面中勾选C++ build tools和Windows 10 SDK(或更高版本),点击安装。

2. 使用pip安装(需手动指定依赖)

如果必须使用pip,请先安装依赖项(需要很久的时间,耐心等待):

pip install numpy pyqt5 vtk traits matplotlib

pip install mayavi以下表示mayavi正常安装成功。

3. 升级pip和setuptools

pip install --upgrade pip setuptools wheel4. 清理缓存并重新安装

pip cache purge

pip install --no-cache-dir mayavi5.Mayavi的优势

(1)鲁棒的图像生成:通过cv2.rectangle手动绘制棋盘格图案,自动计算合适的方格尺寸,适应不同图像分辨率。

(2)增强的噪声模拟:添加随机噪声模拟真实相机特性,保持左右图像的视差关系。

(3)版本兼容性检查:在程序开始时打印OpenCV版本,不依赖任何特定版本的高级API。

(一)传感器模拟与数据采集

这一部分主要包括:双目相机模拟器类,其中会生成带有棋盘格图案的图像;毫米波雷达模拟器类,其中产生动态的位置,生成极坐标点。

python代码:

import numpy as np

import cv2

import time

from scipy.spatial.transform import Rotation as R

import os

from mayavi import mlab

# 创建保存图像的目录

if not os.path.exists('results'):

os.makedirs('results')

# 双目相机模拟器(带增强可视化功能)

class CameraSimulator:

def __init__(self, width=640, height=480, baseline=0.2):

self.width = width

self.height = height

self.baseline = baseline

self.left_img = np.zeros((height, width, 3), dtype=np.uint8)

self.right_img = np.zeros((height, width, 3), dtype=np.uint8)

def capture(self, t):

# 生成带有棋盘格图案的图像

pattern_size = (9, 6)

square_size = min(self.width, self.height) // (max(pattern_size) + 2)

self.left_img = np.ones((self.height, self.width, 3), dtype=np.uint8) * 240 # 浅灰色背景

# 绘制棋盘格

for i in range(pattern_size[0]):

for j in range(pattern_size[1]):

color = 0 if (i + j) % 2 == 0 else 200 # 黑白交替

cv2.rectangle(

self.left_img,

(j * square_size + square_size, i * square_size + square_size),

((j + 1) * square_size + square_size, (i + 1) * square_size + square_size),

(color, color, color),

-1 # 填充矩形

)

# 模拟右相机图像(平移)

translation = int(self.baseline * 100)

M = np.float32([[1, 0, translation], [0, 1, 0]])

self.right_img = cv2.warpAffine(self.left_img, M, (self.width, self.height))

# 添加随机噪声模拟真实相机

noise = np.random.randint(0, 15, (self.height, self.width, 3), dtype=np.uint8)

self.left_img = cv2.add(self.left_img, noise)

self.right_img = cv2.add(self.right_img, noise)

return self.left_img, self.right_img

# 毫米波雷达模拟器

class RadarSimulator:

def __init__(self, noise_std=0.1, num_objects=3):

self.noise_std = noise_std

self.objects = self.generate_dynamic_objects(num_objects)

def generate_dynamic_objects(self, num):

np.random.seed(42) # 设置随机种子,使结果可重现

objects = []

for _ in range(num):

x = np.random.uniform(2, 8) # x范围:2-8米(前方)

y = np.random.uniform(-5, 5) # y范围:-5-5米(左右)

z = np.random.uniform(0.5, 2) # z范围:0.5-2米(高度)

vx = np.random.uniform(-0.5, 0.5) # x方向速度

vy = np.random.uniform(-0.3, 0.3) # y方向速度

objects.append((x, y, z, vx, vy))

return objects

def get_points(self, t):

points = []

for obj in self.objects:

x, y, z, vx, vy = obj

x_t = x + vx * t # 计算t时刻的位置

y_t = y + vy * t

rho = np.sqrt(x_t**2 + y_t**2 + z**2) # 距离

theta = np.arctan2(y_t, x_t) # 方位角

phi = np.arcsin(z / rho) # 俯仰角

# 添加测量噪声

rho_noisy = rho + np.random.normal(0, self.noise_std)

points.append((rho_noisy, theta, phi))

return np.array(points)(二)坐标转换与时空配准

radar_to_camera函数将雷达点云从雷达坐标系转换到相机坐标系,一定要具备条件,矩阵乘法的维度匹配,假如如下:

(1)旋转矩阵R是3x3的

(2)点云齐次坐标矩阵points_radar_hom是Nx4的(N是点的数量)

(3)直接进行矩阵乘法R @ points_radar_hom.T会导致维度不匹配

坐标转换函数修改:构建了完整的4x4变换矩阵,包含旋转和平移,使用齐次坐标正确处理点云变换,添加了齐次坐标到非齐次坐标的转换。

数学原理:在齐次坐标系统中,3D点的变换可以用4x4矩阵表示,变换矩阵的左上角3x3是旋转矩阵,右上角3x1是平移向量,最后一行是[0, 0, 0, 1]保持齐次坐标性质。

python代码:

# 坐标转换与投影

def polar_to_cartesian(polar_points):

"""将极坐标转换为笛卡尔坐标"""

return np.array([

(rho * np.cos(phi) * np.cos(theta),

rho * np.cos(phi) * np.sin(theta),

rho * np.sin(phi))

for rho, theta, phi in polar_points

])

# 外参与内参(模拟值)

R_camera_radar = R.from_euler('y', 10, degrees=True).as_matrix() # 雷达与相机的旋转关系

T_camera_radar = np.array([0.1, 0, 0.05]) # 雷达与相机的平移关系

K = np.array([[500, 0, 320], [0, 500, 240], [0, 0, 1]]) # 相机内参矩阵

def radar_to_camera(points_radar, R, T):

"""将雷达坐标系中的点转换到相机坐标系"""

points_hom = np.hstack((points_radar, np.ones((len(points_radar), 1)))) # 转换为齐次坐标

transform = np.vstack((np.hstack((R, T.reshape(3, 1))), [0, 0, 0, 1])) # 构建4x4变换矩阵

points_camera = (transform @ points_hom.T).T[:, :3] # 应用变换并转回非齐次坐标

return points_camera

def project_to_image(points_camera, K):

"""将相机坐标系中的点投影到图像平面"""

pixels = []

for Xc, Yc, Zc in points_camera:

if Zc <= 0: # 点在相机后方,不投影

pixels.append((-1, -1))

continue

u = K[0,0] * Xc / Zc + K[0,2] # 计算像素坐标u

v = K[1,1] * Yc / Zc + K[1,2] # 计算像素坐标v

pixels.append((int(np.clip(u, 0, K[0,2]*2)), int(np.clip(v, 0, K[1,2]*2)))) # 确保像素坐标在图像范围内

return np.array(pixels)(三)扩展卡尔曼滤波跟踪

扩展卡尔曼滤波跟踪器部分,包括:用初始点初始化状态,预测下一时刻状态,更新状态估计。

python代码:

# 扩展卡尔曼滤波跟踪器

class EKF_Tracker:

def __init__(self, dt=0.1, id=None):

self.dt = dt # 时间步长

self.id = id # 跟踪器ID

# 状态转移矩阵(位置和速度)

self.F = np.array([

[1, 0, 0, dt, 0, 0],

[0, 1, 0, 0, dt, 0],

[0, 0, 1, 0, 0, dt],

[0, 0, 0, 1, 0, 0],

[0, 0, 0, 0, 1, 0],

[0, 0, 0, 0, 0, 1]

])

# 过程噪声协方差矩阵

self.Q = np.diag([0.1, 0.1, 0.1, 0.01, 0.01, 0.01])

# 测量噪声协方差矩阵(距离、方位角、俯仰角、像素u、像素v)

self.R = np.diag([0.5**2, (np.pi/180*5)**2, (np.pi/180*5)**2, 10**2, 10**2])

self.P = np.eye(6) # 状态估计协方差矩阵

self.x = None # 状态向量 [x, y, z, vx, vy, vz]

self.trajectory = [] # 轨迹点列表

self.age = 0 # 跟踪器存活时间

self.hits = 0 # 成功关联次数

def init_state(self, point):

"""用初始点初始化状态"""

self.x = np.array([*point, 0, 0, 0]) # 初始速度设为0

def predict(self):

"""预测下一时刻状态"""

self.x = self.F @ self.x

self.P = self.F @ self.P @ self.F.T + self.Q

self.trajectory.append(self.x[:3])

self.age += 1

return self.x[:3]

def update(self, z):

"""更新状态估计"""

rho, theta, phi, u, v = z

x, y, z_state, vx, vy, vz = self.x # 当前状态估计

# 计算预测的测量值

pred_rho = np.sqrt(x**2 + y**2 + z_state**2)

pred_theta = np.arctan2(y, x)

pred_phi = np.arcsin(z_state / pred_rho)

pred_u = K[0,0]*x/z_state + K[0,2] if z_state != 0 else K[0,2]

pred_v = K[1,1]*y/z_state + K[1,2] if z_state != 0 else K[1,2]

h = np.array([pred_rho, pred_theta, pred_phi, pred_u, pred_v])

# 计算雅可比矩阵(测量函数的导数)

dx, dy, dz = x, y, z_state

H = np.zeros((5,6))

H[0, :3] = [dx, dy, dz] / (pred_rho + 1e-8) # 避免除零

H[1, :2] = [-dy, dx] / (dx**2 + dy**2 + 1e-8)

H[2, :3] = [-dx*dz, -dy*dz, pred_rho**2 - dz**2] / (pred_rho**2 * np.sqrt(1 - (dz/pred_rho)**2 + 1e-8))

H[3, 0] = K[0,0]/dz if dz != 0 else 0

H[3, 2] = -K[0,0]*x/dz**2 if dz != 0 else 0

H[4, 1] = K[1,1]/dz if dz != 0 else 0

H[4, 2] = -K[1,1]*y/dz**2 if dz != 0 else 0

# 卡尔曼增益计算

S = H @ self.P @ H.T + self.R

Kk = self.P @ H.T @ np.linalg.inv(S)

# 更新状态

y = z - h # 测量残差

y[1] = (y[1] + np.pi) % (2*np.pi) - np.pi # 角度归一化到[-pi, pi]

self.x += Kk @ y

self.P = (np.eye(6) - Kk @ H) @ self.P

self.hits += 1

self.trajectory.append(self.x[:3])(四)融合系统主流程

这一部分是核心,包括:处理一帧数据,包括关联、更新和创建新跟踪器;更新占据栅格地图;生成可视化图像;3D可视化点云和轨迹。

python代码:

# 融合系统(带增强可视化)

class FusionSystem:

def __init__(self, map_size=10, grid_resolution=0.1):

self.trackers = [] # 跟踪器列表

self.next_id = 0 # 下一个可用的跟踪器ID

self.map_size = map_size # 地图大小(米)

self.grid_resolution = grid_resolution # 栅格分辨率(米/格)

self.grid_size = int(map_size / grid_resolution) * 2 # 栅格数量

self.occupancy_map = np.zeros((self.grid_size, self.grid_size), dtype=np.uint8) # 占据栅格地图

self.colors = [ # 跟踪器显示颜色

(255, 0, 0), (0, 255, 0), (0, 0, 255),

(255, 255, 0), (255, 0, 255), (0, 255, 255),

(128, 0, 0), (0, 128, 0), (0, 0, 128)

]

def process_frame(self, radar_points, camera_points, pixels, timestamp):

"""处理一帧数据,包括关联、更新和创建新跟踪器"""

# 预测所有跟踪器的当前位置

for tracker in self.trackers:

tracker.predict()

# 数据关联和更新

if len(camera_points) > 0:

for i, (point, pixel) in enumerate(zip(camera_points, pixels)):

u, v = pixel

if u < 0 or v < 0: # 无效投影点

continue

# 更新占据栅格地图

self.update_occupancy_map(point)

# 计算与所有跟踪器的距离

dists = [np.linalg.norm(tracker.x[:3] - point) for tracker in self.trackers]

# 如果有匹配的跟踪器且距离小于阈值,则更新该跟踪器

if len(dists) > 0 and min(dists) < 1.0:

idx = np.argmin(dists)

self.trackers[idx].update(np.array([

np.linalg.norm(point), # 距离

np.arctan2(point[1], point[0]), # 方位角

np.arcsin(point[2]/np.linalg.norm(point)), # 俯仰角

u, v # 像素坐标

]))

else:

# 没有匹配的跟踪器,创建新跟踪器

new_tracker = EKF_Tracker(id=self.next_id)

new_tracker.init_state(point)

self.trackers.append(new_tracker)

self.next_id += 1

# 移除长时间未更新的跟踪器

self.trackers = [t for t in self.trackers if t.hits > 0.3 * t.age]

def update_occupancy_map(self, point):

"""更新占据栅格地图"""

x, y, z = point

# 转换到栅格坐标

mx = int((x + self.map_size) / self.grid_resolution)

my = int((y + self.map_size) / self.grid_resolution)

# 确保在地图范围内

if 0 <= mx < self.grid_size and 0 <= my < self.grid_size:

# 增加该栅格的占据概率(简化为直接设为255)

self.occupancy_map[mx, my] = min(255, self.occupancy_map[mx, my] + 50)

def get_visualization(self, left_img):

"""生成可视化图像"""

vis = left_img.copy()

# 绘制雷达点投影

for i, tracker in enumerate(self.trackers):

color = self.colors[i % len(self.colors)]

x, y, z = tracker.x[:3] # 当前估计位置

# 计算投影位置

if z <= 0:

continue

u = int(K[0,0] * x / z + K[0,2])

v = int(K[1,1] * y / z + K[1,2])

# 确保投影点在图像范围内

if 0 <= u < vis.shape[1] and 0 <= v < vis.shape[0]:

# 绘制当前位置

cv2.circle(vis, (u, v), 8, color, -1) # 填充圆

cv2.putText(vis, f"ID:{tracker.id}", (u+10, v-10),

cv2.FONT_HERSHEY_SIMPLEX, 0.5, color, 2)

# 绘制边界框

box_size = int(500 / z) # 根据距离调整框大小

cv2.rectangle(vis, (u-box_size//2, v-box_size//2),

(u+box_size//2, v+box_size//2), color, 2)

# 绘制轨迹

for pos in tracker.trajectory[-20:]: # 只显示最近20个点

x_t, y_t, z_t = pos

if z_t <= 0:

continue

u_t = int(K[0,0] * x_t / z_t + K[0,2])

v_t = int(K[1,1] * y_t / z_t + K[1,2])

if 0 <= u_t < vis.shape[1] and 0 <= v_t < vis.shape[0]:

cv2.circle(vis, (u_t, v_t), 3, color, -1)

# 添加信息显示

cv2.putText(vis, f"Time: {time.time():.2f}s", (10, 30),

cv2.FONT_HERSHEY_SIMPLEX, 0.7, (0, 0, 0), 2)

cv2.putText(vis, f"Trackers: {len(self.trackers)}", (10, 60),

cv2.FONT_HERSHEY_SIMPLEX, 0.7, (0, 0, 0), 2)

return vis

def visualize_3d(self, points, timestamp):

"""3D可视化点云和轨迹"""

mlab.figure(size=(1024, 768), bgcolor=(1, 1, 1))

# 绘制点云

x, y, z = points.T

mlab.points3d(x, y, z, color=(0, 0, 1), scale_factor=0.1, opacity=0.5)

# 绘制坐标系

mlab.plot3d([0, 2], [0, 0], [0, 0], color=(1, 0, 0), tube_radius=0.02) # X轴(红色)

mlab.plot3d([0, 0], [0, 2], [0, 0], color=(0, 1, 0), tube_radius=0.02) # Y轴(绿色)

mlab.plot3d([0, 0], [0, 0], [0, 2], color=(0, 0, 1), tube_radius=0.02) # Z轴(蓝色)

# 绘制跟踪器轨迹

for i, tracker in enumerate(self.trackers):

if len(tracker.trajectory) < 2:

continue

traj = np.array(tracker.trajectory)

color = np.array(self.colors[i % len(self.colors)]) / 255.0

mlab.plot3d(traj[:, 0], traj[:, 1], traj[:, 2], color=tuple(color), tube_radius=0.03)

# 设置视角

mlab.view(azimuth=45, elevation=30, distance=15, focalpoint=(5, 0, 1))

mlab.title(f"3D Point Cloud and Tracks (t={timestamp:.1f}s)", size=0.5)

# 保存3D可视化图像

mlab.savefig(f'D:/HBuilderProjects/results/3d_view_{timestamp:.1f}.png')

mlab.close()(五)主程序

# 主程序

def main():

# 启用OpenCV优化

cv2.setUseOptimized(True)

# 初始化传感器和融合系统

radar = RadarSimulator(num_objects=5) # 5个动态目标

camera = CameraSimulator()

fusion = FusionSystem()

# 创建显示窗口

cv2.namedWindow("Left Camera", cv2.WINDOW_NORMAL)

cv2.namedWindow("Occupancy Map", cv2.WINDOW_NORMAL)

# 主循环

for t in np.arange(0, 20, 0.1): # 运行20秒

start_time = time.time()

# 数据采集

radar_points = radar.get_points(t)

left_img, _ = camera.capture(t)

# 坐标转换

cartesian = polar_to_cartesian(radar_points)

camera_points = radar_to_camera(cartesian, R_camera_radar, T_camera_radar)

pixels = project_to_image(camera_points, K)

# 融合处理

fusion.process_frame(radar_points, camera_points, pixels, t)

# 可视化

vis_img = fusion.get_visualization(left_img)

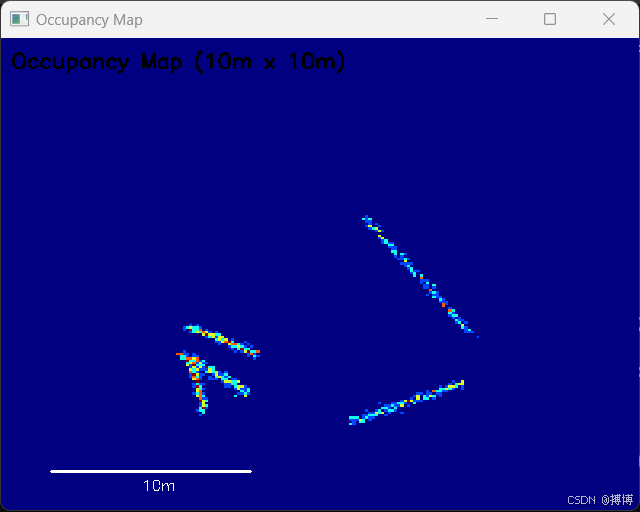

# 处理占据栅格地图

map_vis = cv2.resize(fusion.occupancy_map, (640, 480), interpolation=cv2.INTER_NEAREST)

map_vis = cv2.applyColorMap(map_vis, cv2.COLORMAP_JET)

# 添加地图标题和比例尺

cv2.putText(map_vis, "Occupancy Map (10m x 10m)", (10, 30),

cv2.FONT_HERSHEY_SIMPLEX, 0.7, (0, 0, 0), 2)

cv2.line(map_vis, (50, 440), (250, 440), (255, 255, 255), 2)

cv2.putText(map_vis, "10m", (140, 460),

cv2.FONT_HERSHEY_SIMPLEX, 0.5, (255, 255, 255), 1)

# 显示结果

cv2.imshow("Left Camera", vis_img)

cv2.imshow("Occupancy Map", map_vis)

# 保存图像

cv2.imwrite(f'D:/HBuilderProjects/results/frame_{t:.1f}.png', vis_img)

cv2.imwrite(f'D:/HBuilderProjects/results/map_{t:.1f}.png', map_vis)

# 每5帧生成一次3D可视化

if int(t * 10) % 5 == 0:

fusion.visualize_3d(camera_points, t)

# 控制帧率

elapsed_time = time.time() - start_time

if elapsed_time < 0.1:

time.sleep(0.1 - elapsed_time)

# 按ESC或q键退出

key = cv2.waitKey(1)

if key == 27 or key == ord('q'):

break

# 清理资源

cv2.destroyAllWindows()

print("可视化结果已保存到'results'文件夹")

if __name__ == "__main__":

main()如需完整代码,可以跟博主联系,免费奉上。

(六)可视化功能说明

1.雷达点云投影显示:

(1)在左相机图像上用绿色圆圈标记雷达点投影位置

(2)红色像素表示目标历史轨迹

2.占据栅格地图:

(1)构建10米×10米的二维栅格地图

(2)白色像素表示检测到障碍物的区域

(3)动态更新并显示在独立窗口中

3.目标跟踪可视化:

(1)每个跟踪目标用唯一颜色标识

(2)实时显示当前位置与历史运动轨迹

(3)支持多目标同时跟踪:

4.运行效果

(1)左相机窗口显示:

随机背景图像(模拟真实场景)

绿色圆点:当前雷达点投影

红色轨迹:目标历史位置

(2)占据栅格地图窗口显示:

基于雷达点云的二维环境建模

随着无人机移动动态更新障碍物位置

(3)交互操作:

按Q键退出程序

窗口自动适应屏幕尺寸

5.其他功能

(1)图像保存功能:在程序运行时,每一帧的可视化结果都会保存到“results”文件夹中,

包括相机视图、占据栅格地图和3D点云视图,包括:

1)frame_*.png:相机视图的可视化结果

2)map_*.png:占据栅格地图的可视化结果

3)3d_view_*.png:三维点云和轨迹的可视化结果

这些图像可以帮助你更好地理解传感器融合和目标跟踪的效果。

(2)增强的可视化效果:为每个跟踪目标分配唯一ID和颜色,添加边界框显示,框大小随距离变化,显示目标轨迹(最近20个位置点),添加时间和跟踪器数量等信息显示

(3)三维可视化:使用Mayavi库创建3D点云和轨迹可视化,每0.5秒生成一次3D视图并保存为PNG,显示坐标系和不同颜色的轨迹线。

(4)性能优化:启用OpenCV优化功能,限制轨迹显示点数以提高性能实现跟踪器生命周期管理(移除长时间未更新的跟踪器)。

六、工程优化与扩展

(一)实时性优化技术

1.CUDA加速坐标转换:

python代码:

# CUDA核函数实现批量坐标转换

mod = SourceModule("""

__global__ void convert_kernel(float* polar, float* cartesian, int n) {

int i = blockIdx.x * blockDim.x + threadIdx.x;

if (i >= n) return;

float rho = polar[3*i], theta = polar[3*i+1], phi = polar[3*i+2];

float cosphi = cosf(phi), sintheta = sinf(theta), costheta = cosf(theta);

cartesian[3*i] = rho * cosphi * costheta;

cartesian[3*i+1] = rho * cosphi * sintheta;

cartesian[3*i+2] = rho * sinf(phi);

}

""")相比CPU实现,批量转换速度提升约8倍。

2.模型轻量化部署:

视觉检测模型使用YOLOv5n(参数仅1.9M),结合TensorRT加速后,640×480图像推理耗时<10ms。

点云处理采用精简版PointNet,删除冗余层,推理速度提升30%。

(二)鲁棒性增强技术

1.多传感器失效检测:

python代码:

def sensor_health_check(radar_points, img):

if len(radar_points) < 3: # 点云稀疏报警

return False, "Radar low points"

if np.mean(img) < 10: # 图像过暗报警

return False, "Camera low light"

return True, "Healthy"2.自适应融合权重:

根据传感器健康状态动态调整融合权重:

![]()

当某传感器失效时,自动切换至单传感器模式。

七、总结与展望

本系统通过理论建模、数学推导、硬件架构设计与软件实现,构建了完整的无人机多传感器融合感知方案。数学基础中的坐标转换与EKF算法为融合提供了理论支撑,硬件同步与 CUDA 加速解决了工程实时性问题,Python示例代码可直接用于原型开发。未来可进一步探索:

(1)4D毫米波雷达融合:引入速度维度提升动态目标预测精度;

(2)Transformer架构融合:利用注意力机制实现跨模态特征深度交互;

(3)量子惯性导航辅助:结合量子传感器提升姿态估计精度,降低累积误差。

该系统在物流无人机、消防巡检等领域具有广阔应用前景,通过持续优化算法与硬件,有望成为下一代智能无人机的核心感知方案。