1、运行本地模型

1.1、下载Ollama

官网下载:Ollama

1.2、安装LLM大模型

Ollama官网搜索模型,复制命令:

在终端中粘贴下载,下载完成后可以输入对话,表示安装成功。

使用命令:ollama list 可以列出已经安装的大模型,NAME后面有用。

1.3、设置模型供应商

首先编辑dify/docker/.env文件,在文件末尾添加:

# 启用自定义模型

CUSTOM_MODEL_ENABLED=true

# 指定 Olama 的 API地址(根据部署环境调整IP)

OLLAMA_API_BASE_URL=host.docker.internal:11434然后在dify/docker目录下打开终端管理员,输入命令启动dify。

docker compose up -d打开:http://localhost/install,登录Dify,点击用户设置。

点击“模型供应商”,选择ollama,点击安装。

安装成功后,点击添加模型。

弹出的对话框中填入ollama list中的模型NAME,基础URL填入:http://host.docker.internal:11434

随后保存。

1.4、添加模型成功后但不成功

保存后,Ollama下显示模型为0个,重启Dify多次,重新添加模型多次仍一样。

中间尝试多种办法,比如在.env文件末尾添加:

PLUGIN_WORKING_PATH=/app/cwd # --无效!

又如在dify/docker/docker-compose.yaml的plugin_daemon下修改以下代码:

PYTHON_ENV_INIT_TIMEOUT: ${PYTHON_ENV_INIT_TIMEOUT:-640}

PLUGIN_MAX_EXECUTION_TIMEOUT: 2400

PIP_MIRROR_URL: https://mirrors.aliyun.com/pypi/simple

然后重新执行docker compose up -d,也没有效果。

最后在docker-compose.yml文件中的worker,api和plugin_daemon 添加配置:

REMOTE_INSTALL_URL: http://${EXPOSE_PLUGIN_DEBUGGING_HOST:-localhost}:${EXPOSE_PLUGIN_DEBUGGING_PORT:-5003}

并在dify/docker/.env 最后一行添加配置:

REMOTE_INSTALL_URL=http://${EXPOSE_PLUGIN_DEBUGGING_HOST:-localhost}:${EXPOSE_PLUGIN_DEBUGGING_PORT:-5003}

最后重启Dify,居然就可以了!

将Ollama的模型设置系统模型中去。

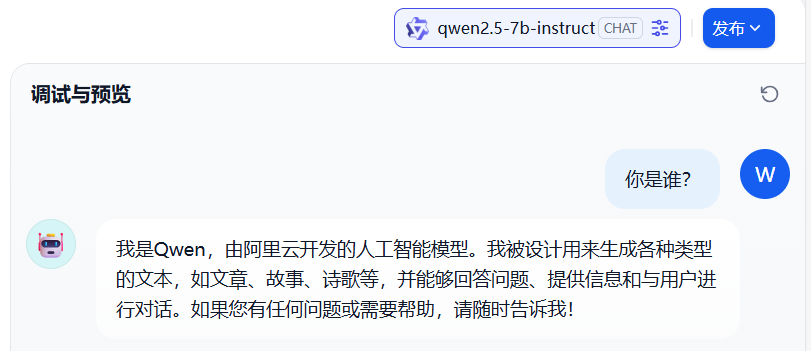

然后新建聊天应用,成功启动了聊天窗口!

2、添加在线大模型

首先要获取大模型的API-key,比如阿里的通义千问:

然后在Dify中的模型供应商中安装通义千问,再添加模型时粘贴API-KEY,就可以加入通义千问的所有大模型了:

刚开始在系统模型设置中设置在线大模型时,也不能使用,总是显示internal error什么的。

按前文1.4修改dify的docker配置后,居然就可以了!