<测量透明液体折射率的深度学习方法>论文总结

00摘要

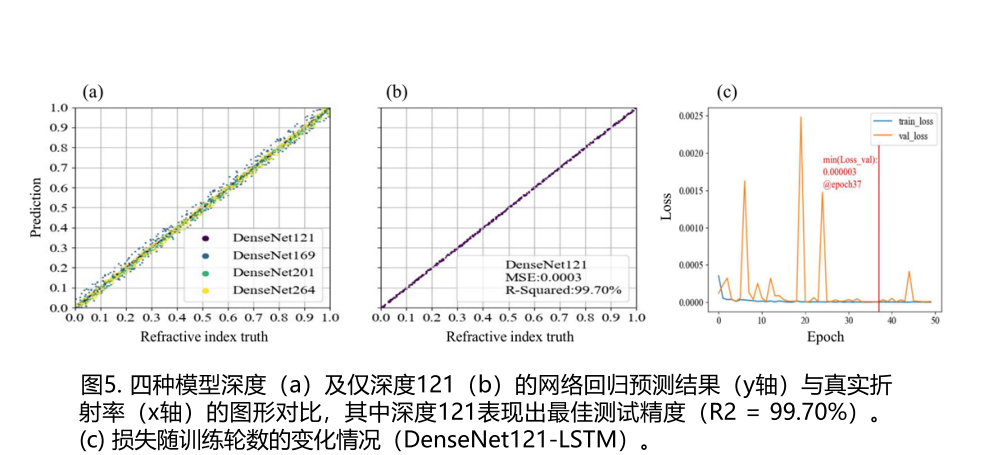

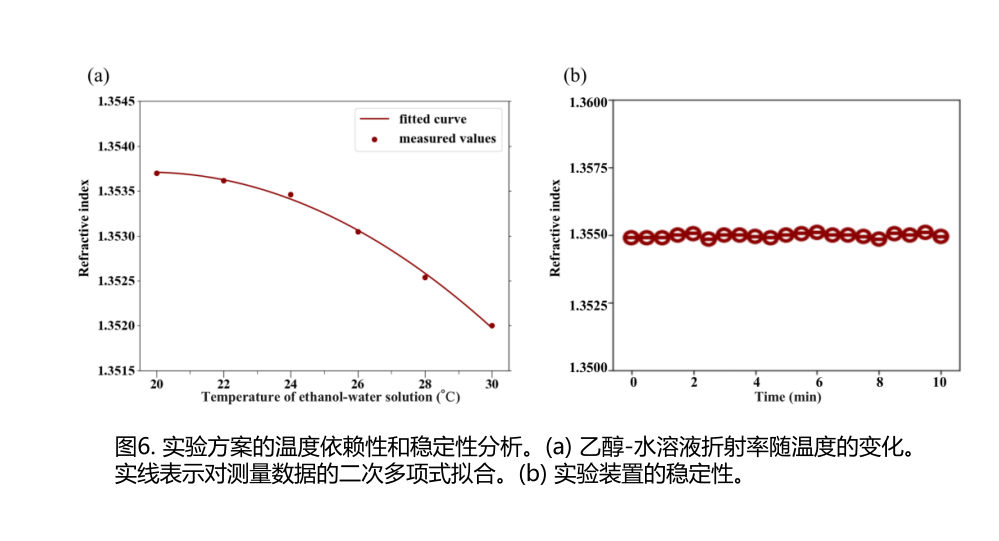

提出一种基于超平滑干涉条纹位移变化的深度学习方法,用于确定透明液体的折射率。通过群相位拟合分析和建模视频数据中这些条纹变化的相位特性。随后开发并训练了一个结合密集卷积网络与长短期记忆网络的神经网络模型,用于高精度液体折射率测量。实验表明,R2精度达到99.70%,均方误差为0.0003。该方法已被证实具有温度依赖性,对外部干扰具有较强稳定性,精度高,并具备实时处理能力。

01引言

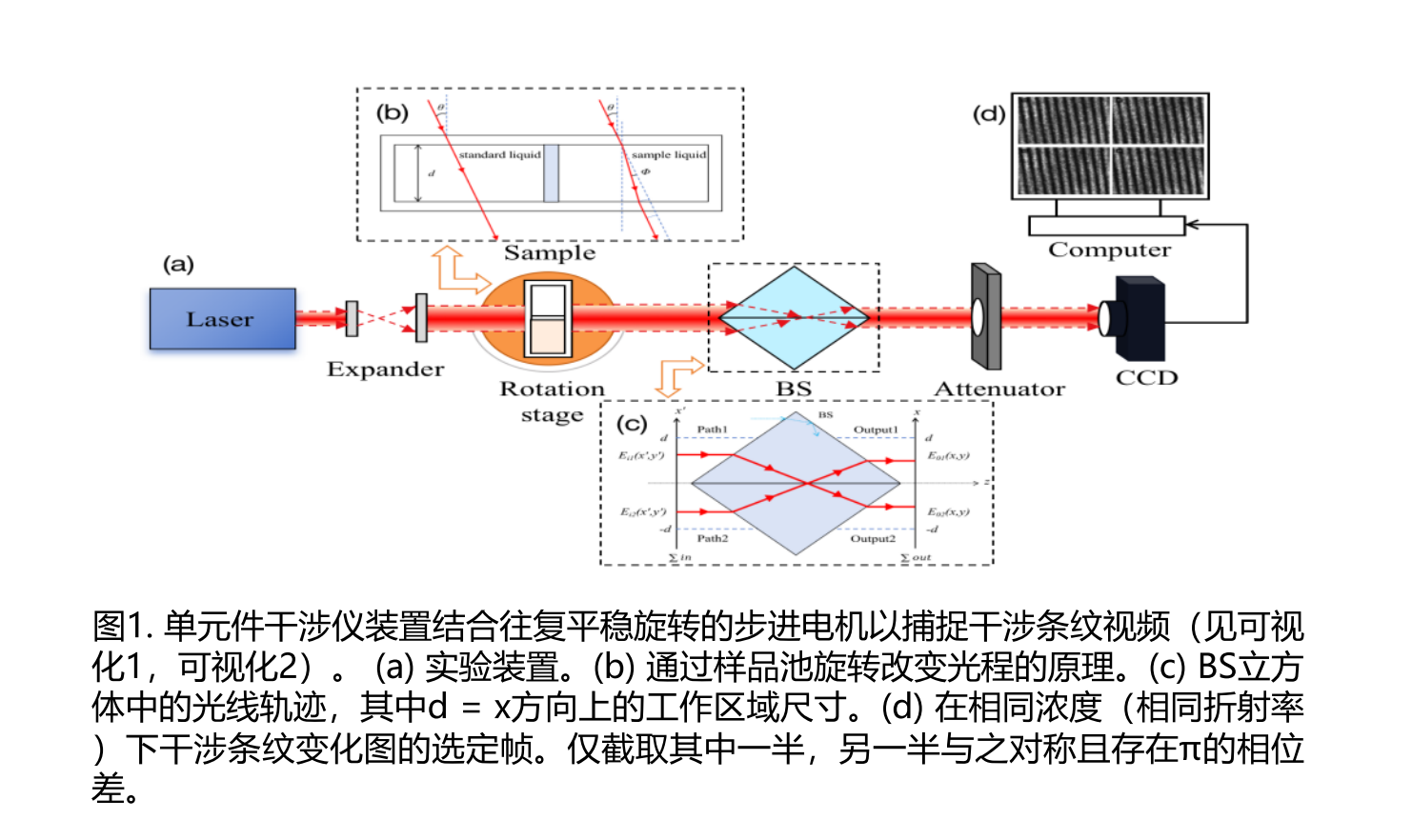

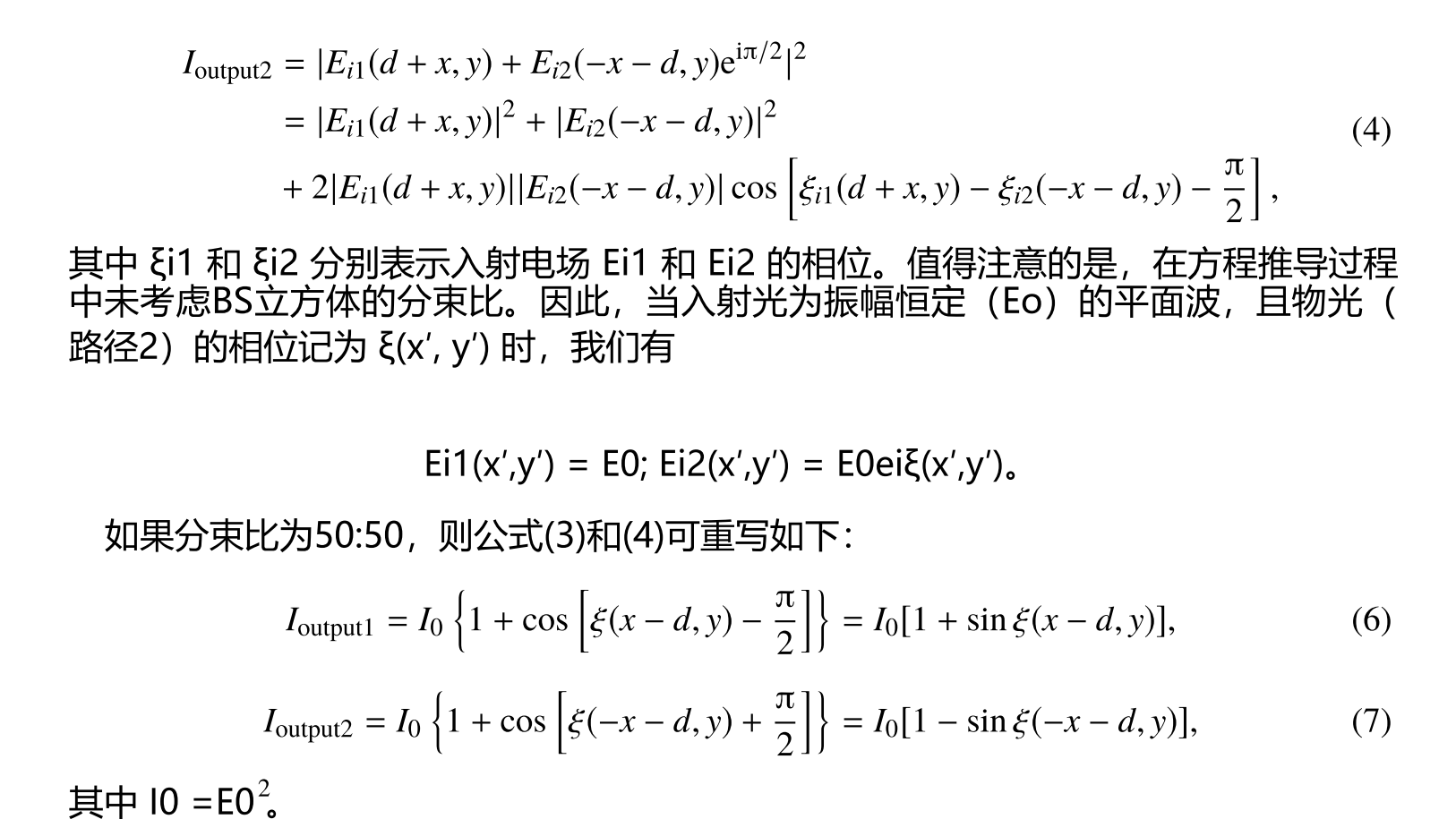

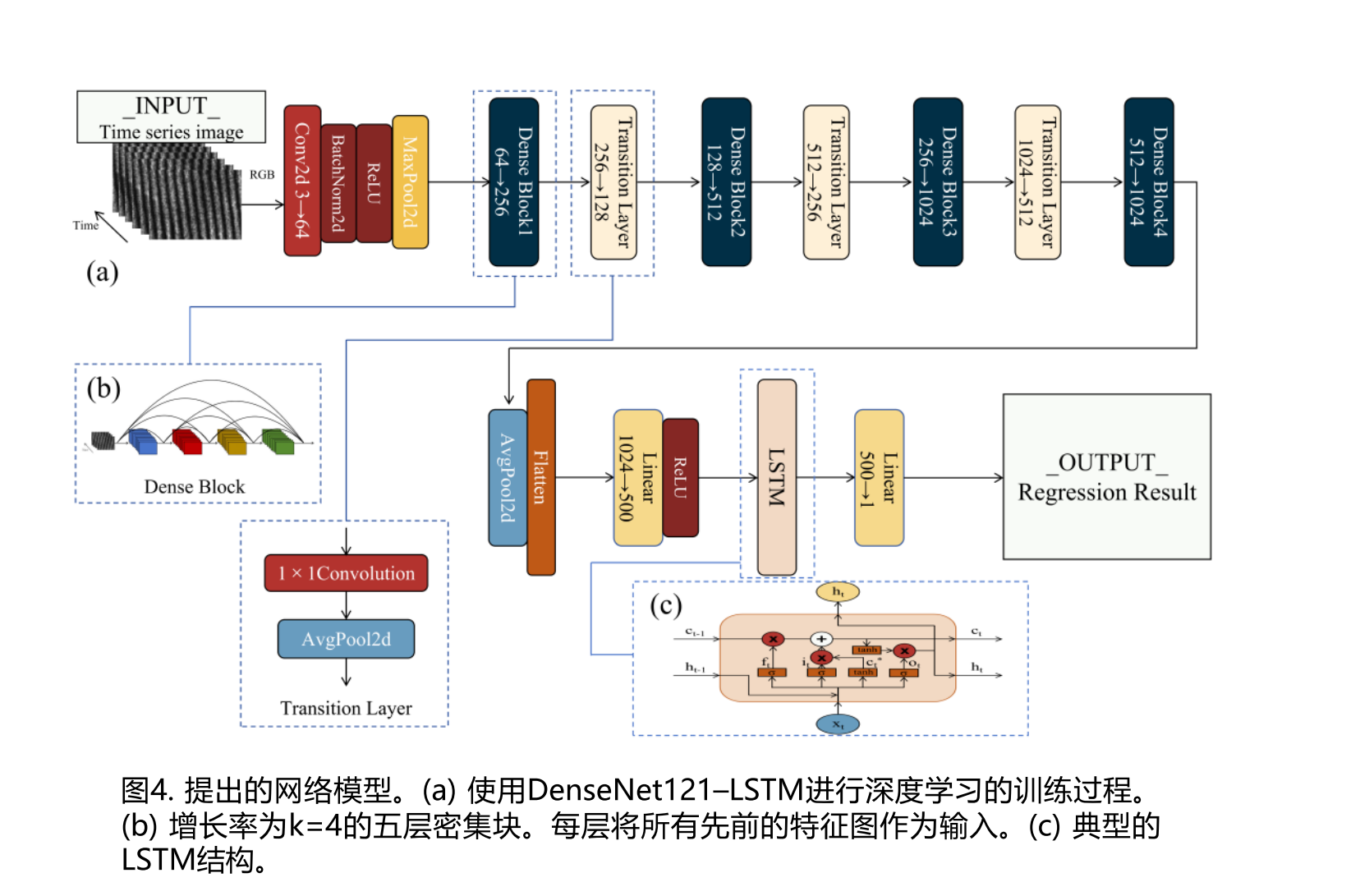

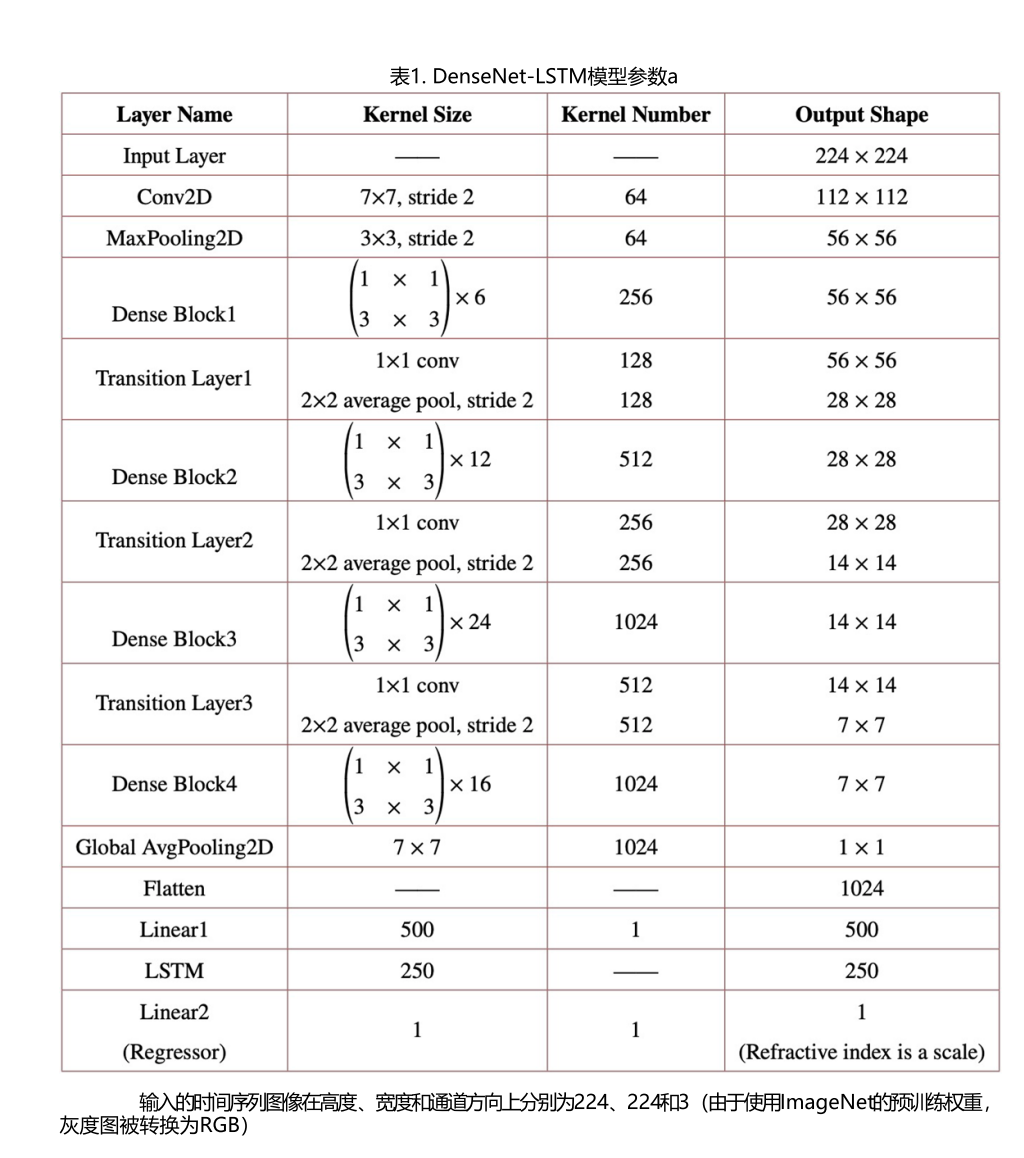

在本研究中,我们首先获取了样本液体中超平滑干涉条纹位移的视频数据。这是通过使用安装在往复高精度旋转步进电机(旋转角度范围为−9°至9°)上的激光束照射样品和标准液体,并利用分束器立方体实现的。在开发深度网络之前,我们确认了液体浓度与干涉条纹变化相位之间的相关性。我们引入了群相位概念来建模每个平面点的相位变化,并验证了其物理合理性。DenseNet以其强大的特征提取能力和互联的卷积层著称,有助于避免深层网络中的梯度消失问题,从而高效捕捉干涉条纹图像的空间特征[14],而长短期记忆(LSTM)网络适合捕捉条纹变化的时间特征。Song等人成功使用CNN–LSTM网络结构进行教学视频评估,并证明了其实用有效性[15]。因此,我们设计了DenseNet121与LSTM串联的网络结构,分别处理条纹位移数据的空间和时间特征。这种方法在测量透明液体折射率方面取得了显著的回归结果,评估指标为R2 = 99.70%,均方误差(MSE)= 3.0 ×10−4,平均绝对误差(MAE)= 7.2 ×10−3。为了简化模型训练,我们首先对视频进行间隔帧提取,然后进行预处理和数据清洗以构建样本库。网络模型随后以一系列时间序列图像作为输入。该方法有效测量了透明液体的折射率,同时在准确性和实时性能之间实现了平衡。

02方法

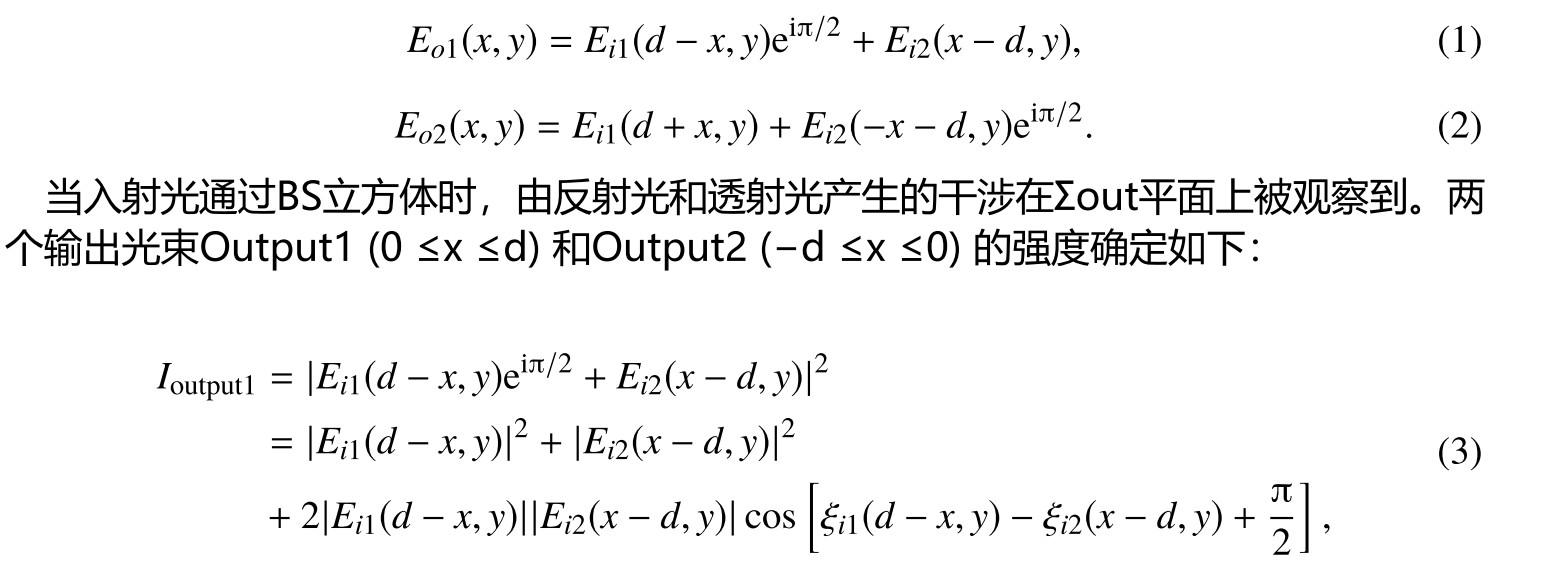

在本实验中该比值假定为50:50。因此,BS立方体的半反射半透射膜应沿z轴对齐。这种对齐确保了当光束沿此轴传播时,一半的光透过标准介质(液体或空气)作为参考光束(路径1),而另一半则穿过样品液体作为物光束(路径2)。由于准直光束的宽度和比色皿的宽度均为2d(即20 mm),BS立方体在x轴方向的有效工作范围约为d(即10 mm),或约为立方体边长的30%。根据折射定律,超出此有效范围的光将完全被BS立方体内部壁面反射。在立方体内部分光的讨论中,主要涉及能量的分配,从而导致光束强度的特定变化。设Ei1和Ei2表示在Σin平面上两束光的电场。当入射光遇到BS立方体时,同时发生折射和反射,使得每个入射光束在输出表面产生折射光和反射光。透射光通过半反射半透射膜时相位保持不变,而反射光经历π的相位变化,导致反射光电场产生π/2的相位偏移。因此,Σout平面上两束光的电场可轻易确定:

实验测试中明显观察到,条纹移动数N从角度零点向极端角度变化时,变化速度越来越快,即旋转角度越大,N的变化斜率越大。由此可见,旋转角度范围越大,测量精度越高。

3. 基于深度学习的超稳态条纹变化视频数据处理与学习

数据集按0.8:0.2的比例划分为训练集和测试集。为增强样本数据,采用随机扰动和翻转等操作,显著提升了模型的鲁棒性。这些增强处理后进一步进行数据清洗,以构建模型的样本库。然后构建一个结合密集卷积网络(DenseNet)与LSTM网络的DenseNet–LSTM网络模型

4. 结果与分析

5. 结论

在本研究中,我们开发了一种基于深度学习的回归方法,用于分析时间序列图像,以实时精确测定透明液体的折射率。该方法利用了通过往复循环旋转平台和单元件干涉仪实验装置获得的超平滑干涉条纹位移变化的视频数据。首先,在数据清洗后,我们处理并分析了干涉条纹变化图的相位变化特征。该过程验证了分别提取数据空间和时间特征的可行性。随后,我们构建了一个DenseNet121–LSTM模型,作为输入干涉条纹位移时间序列图像的特征识别器。由121层DenseNet与LSTM结合的模型在220个样本的测试数据上表现最佳,R2达到99.7%,均方误差(MSE)为3.0×10−4。结果证实,该模型能够精确提取干涉条纹的空间和时间特征。

参考文献:Deep-learning approach to measuring the refractive index of transparent liquids

声明:作者水平有限,如有错误,务必留言指正,共同学习进步!(如有帮助,不妨点赞评论)。