合集 ChatGPT 通过图形化的方式来理解 Transformer 架构

- 翻译: 什么是ChatGPT 通过图形化的方式来理解 Transformer 架构 深度学习一

- 翻译: 什么是ChatGPT 通过图形化的方式来理解 Transformer 架构 深度学习二

- 翻译: 什么是ChatGPT 通过图形化的方式来理解 Transformer 架构 深度学习三

- 翻译: 什么是ChatGPT 通过图形化的方式来理解 Transformer 架构 深度学习四

- 翻译: 什么是ChatGPT 通过图形化的方式来理解 Transformer 架构 深度学习五

- 翻译: 什么是ChatGPT 通过图形化的方式来理解 Transformer 架构 深度学习六

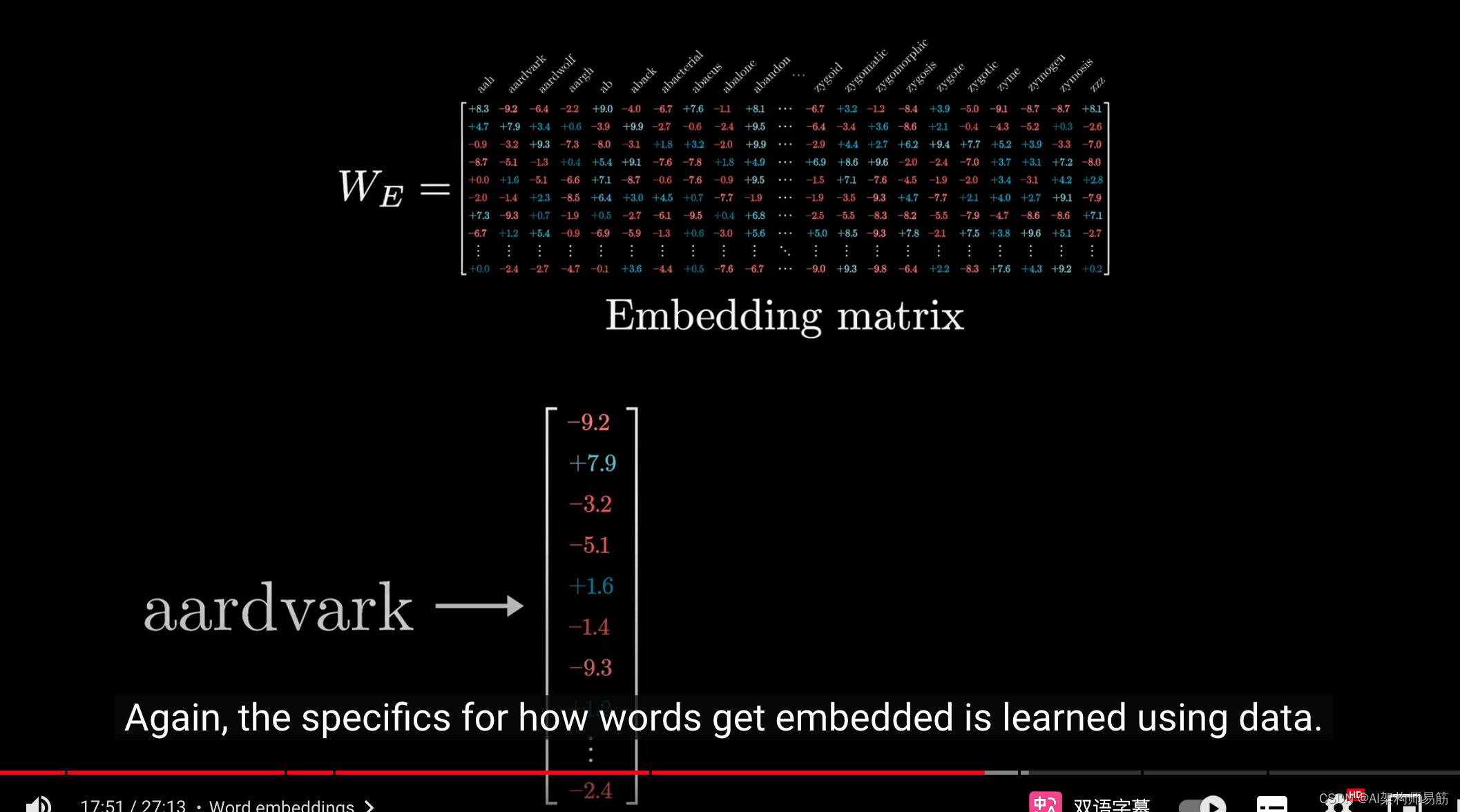

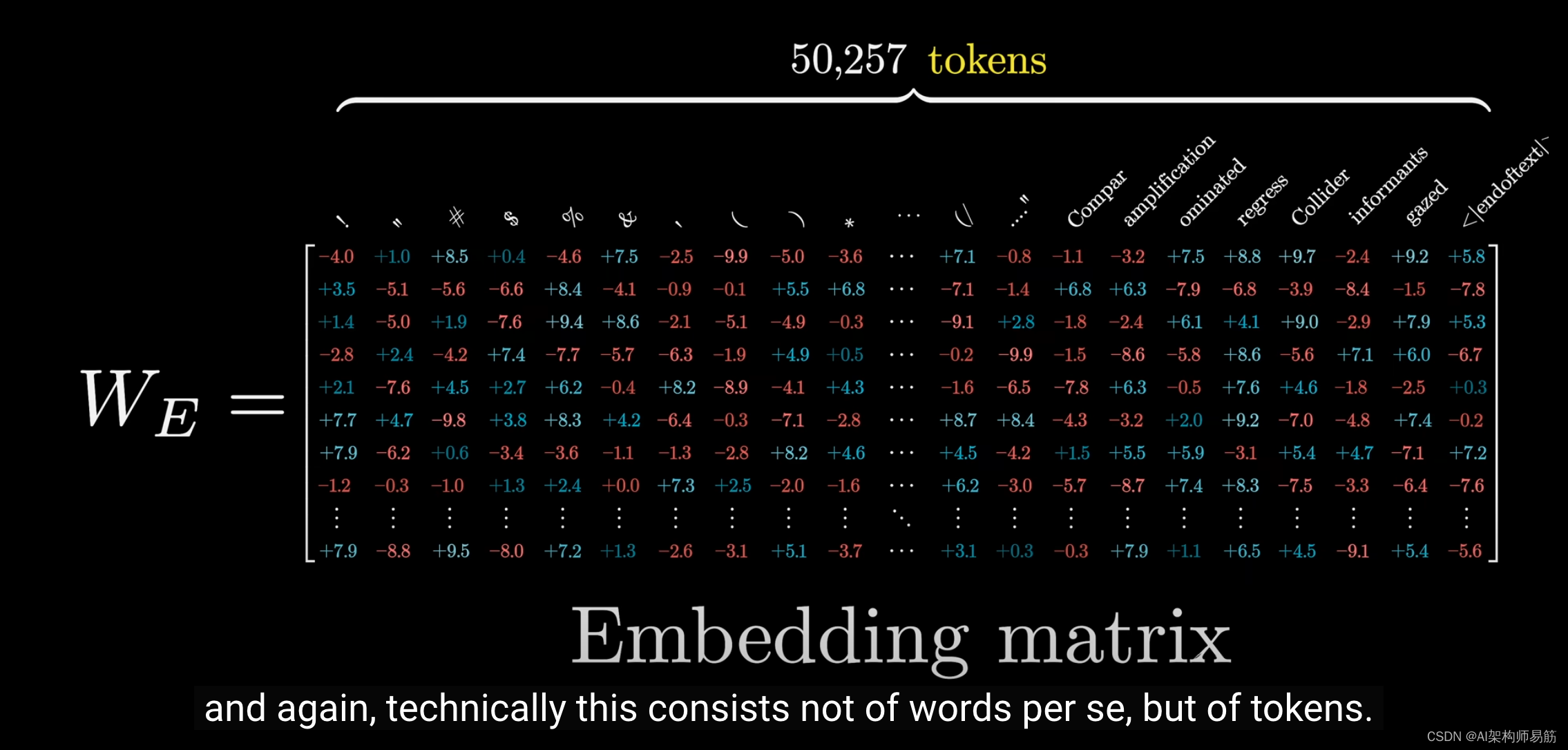

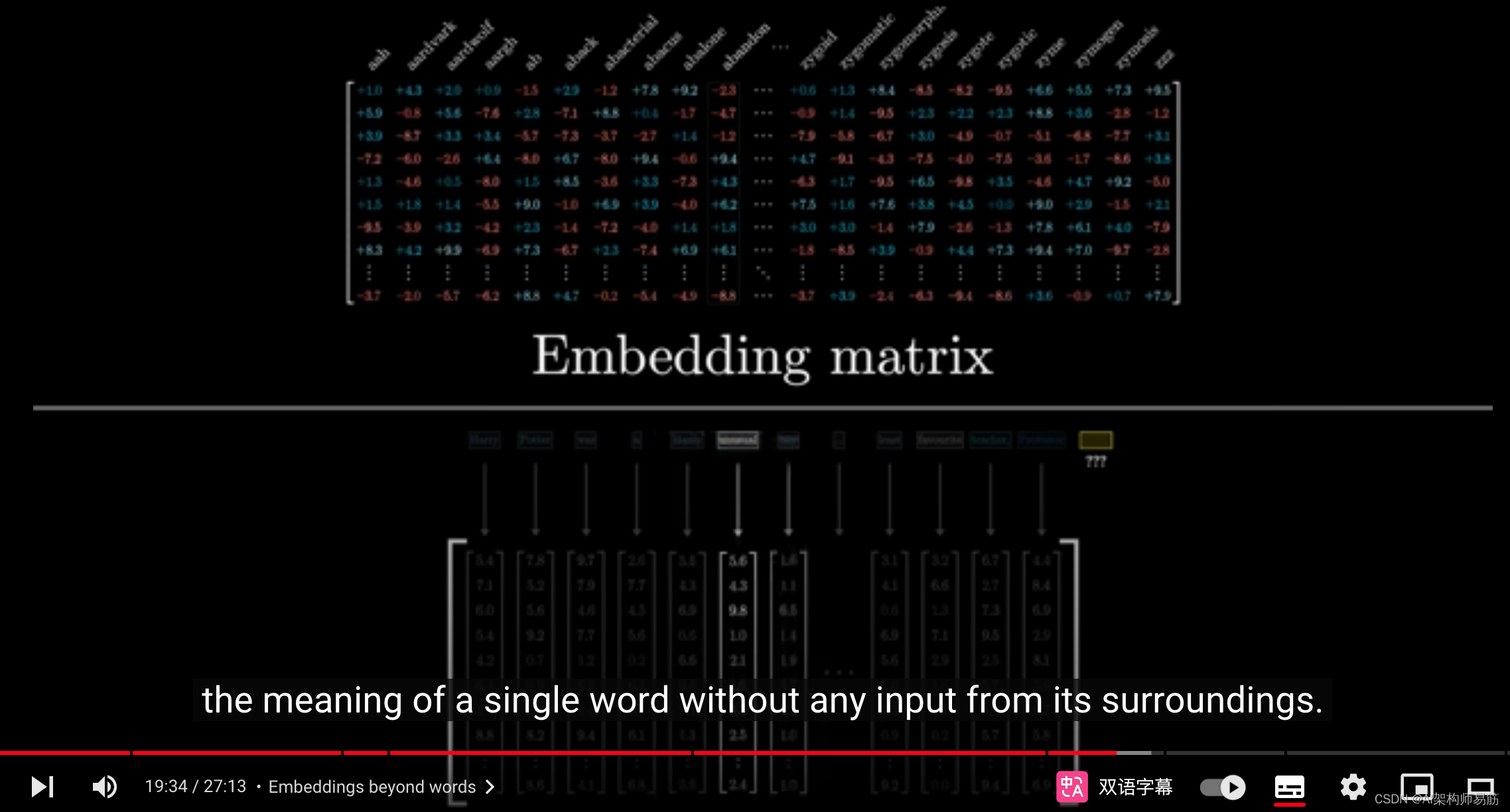

同样,词的嵌入方式是通过数据学习的。

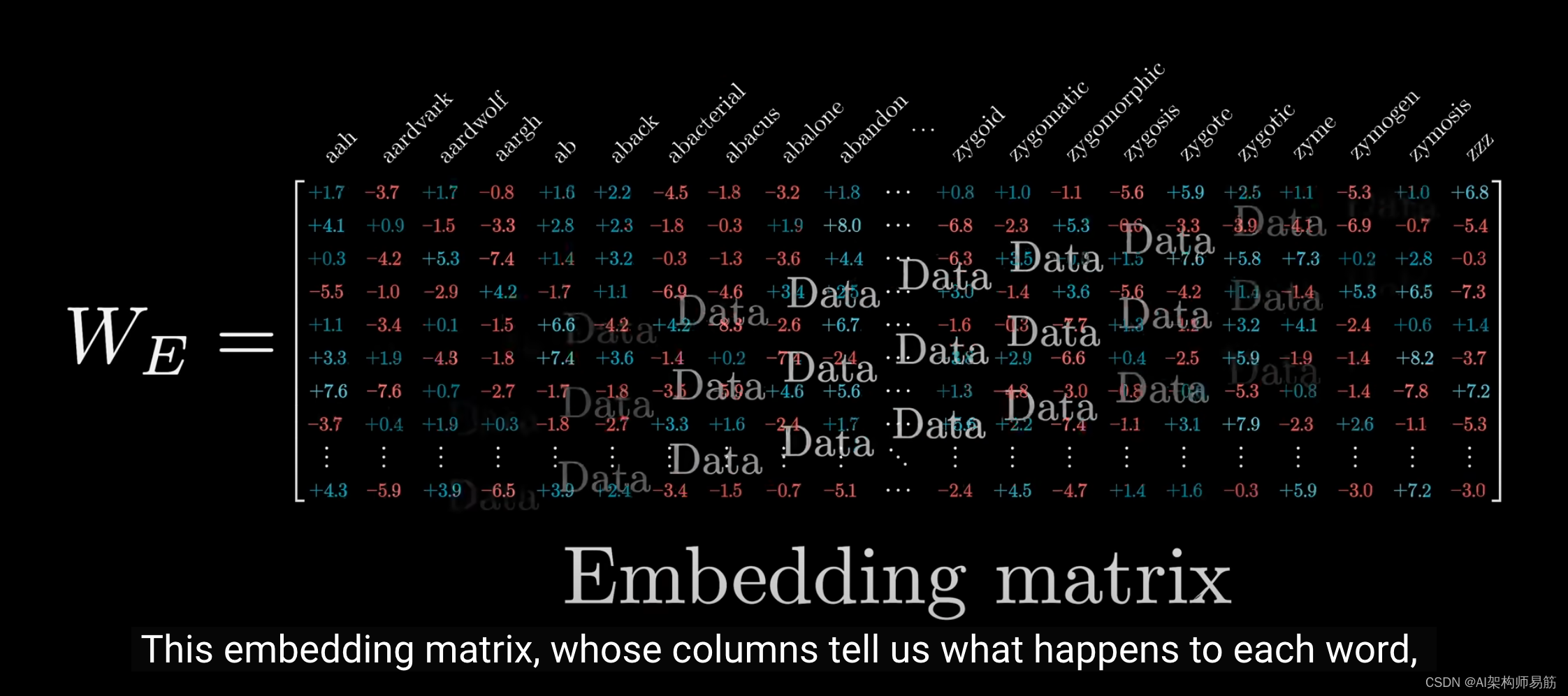

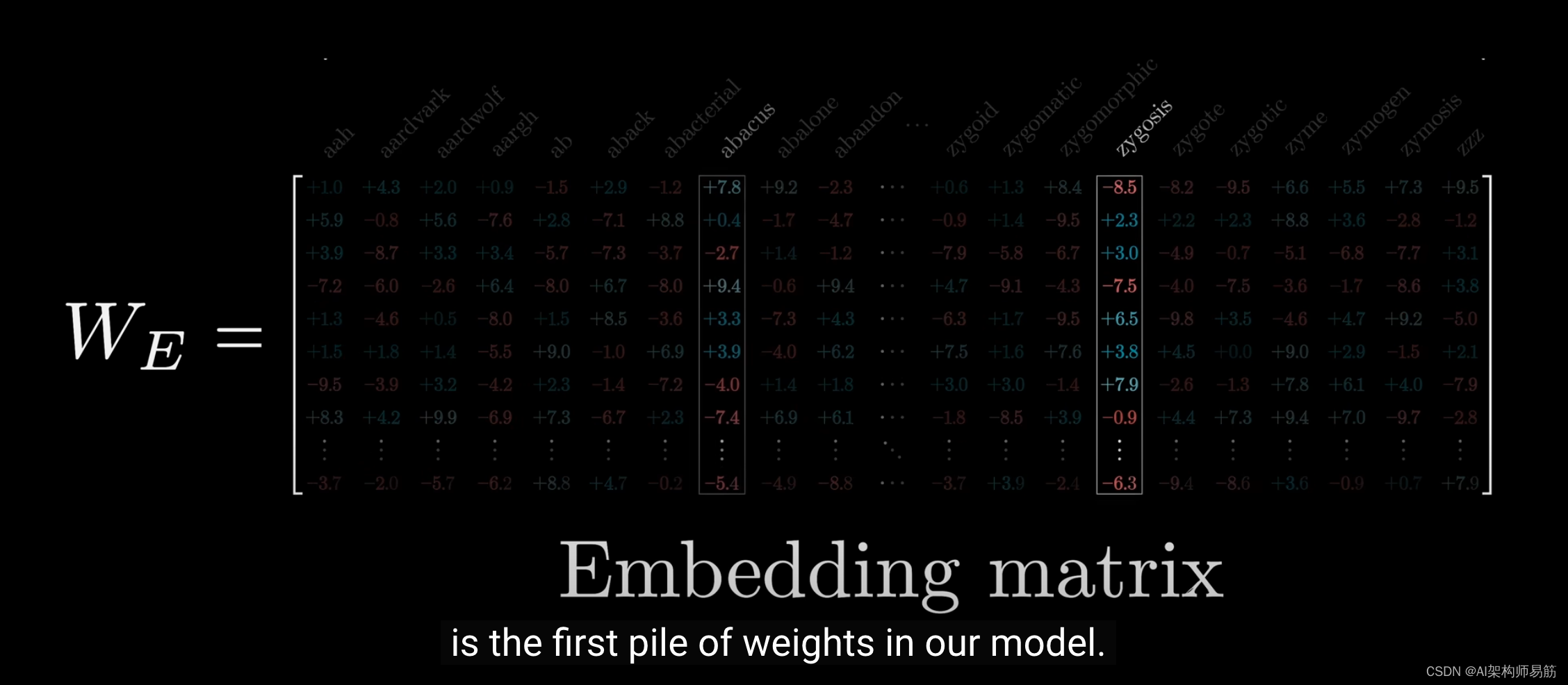

这个嵌入矩阵揭示了每个词的变化过程,

它是我们模型中的第一批权重,

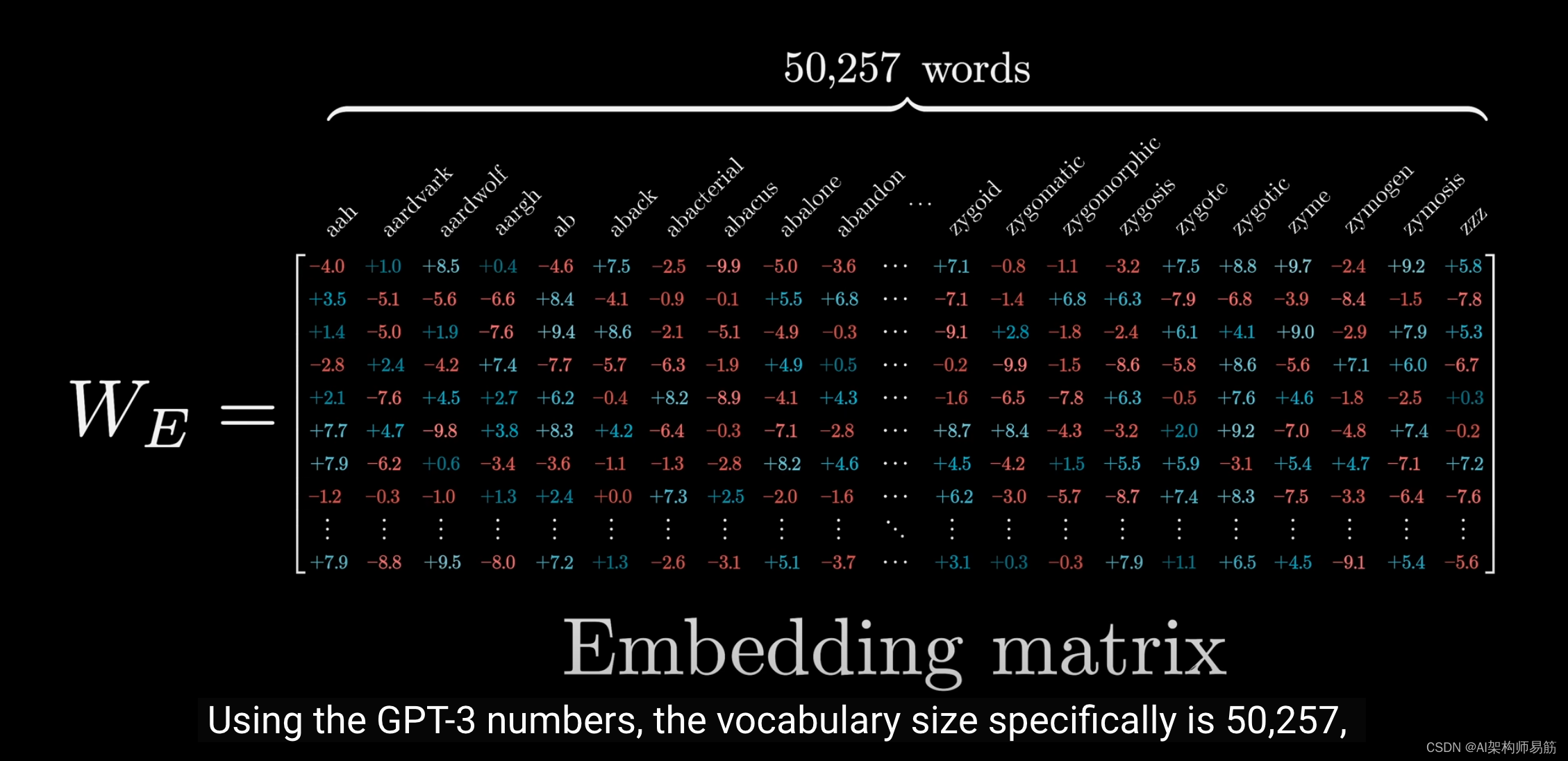

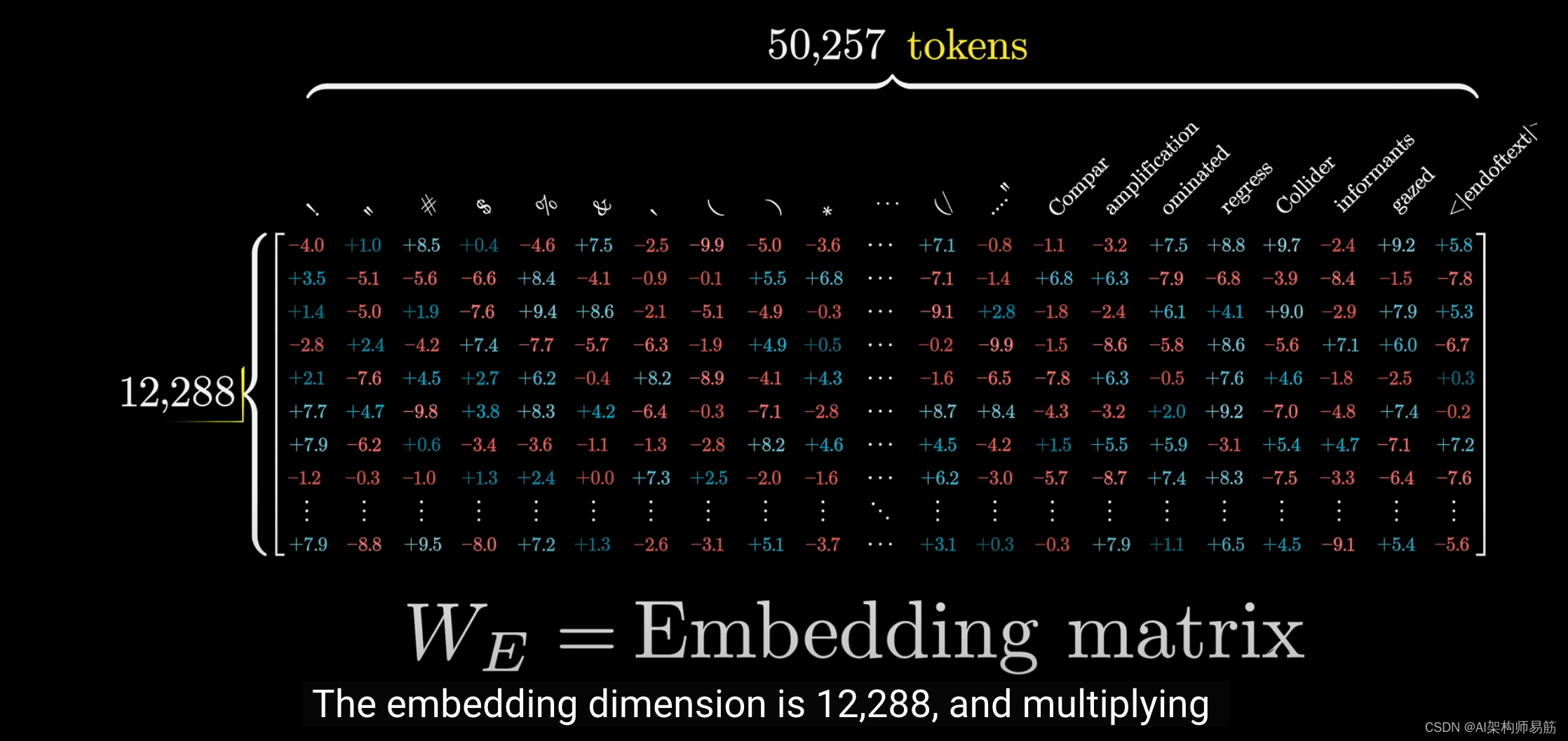

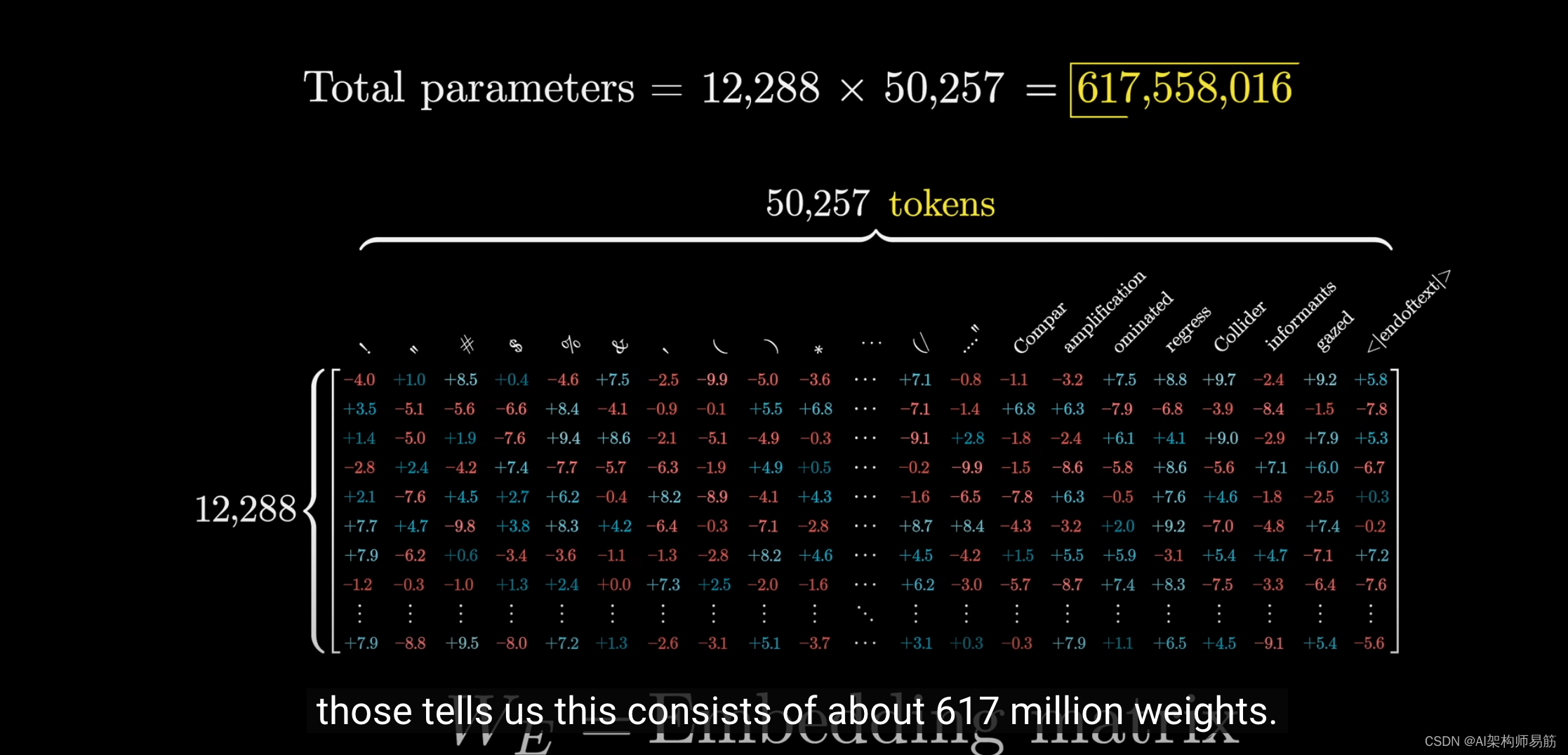

根据GPT-3,其词汇量具体为50,257 tokens,

但请注意,它实际上并不指单词本身,而是指tokens。

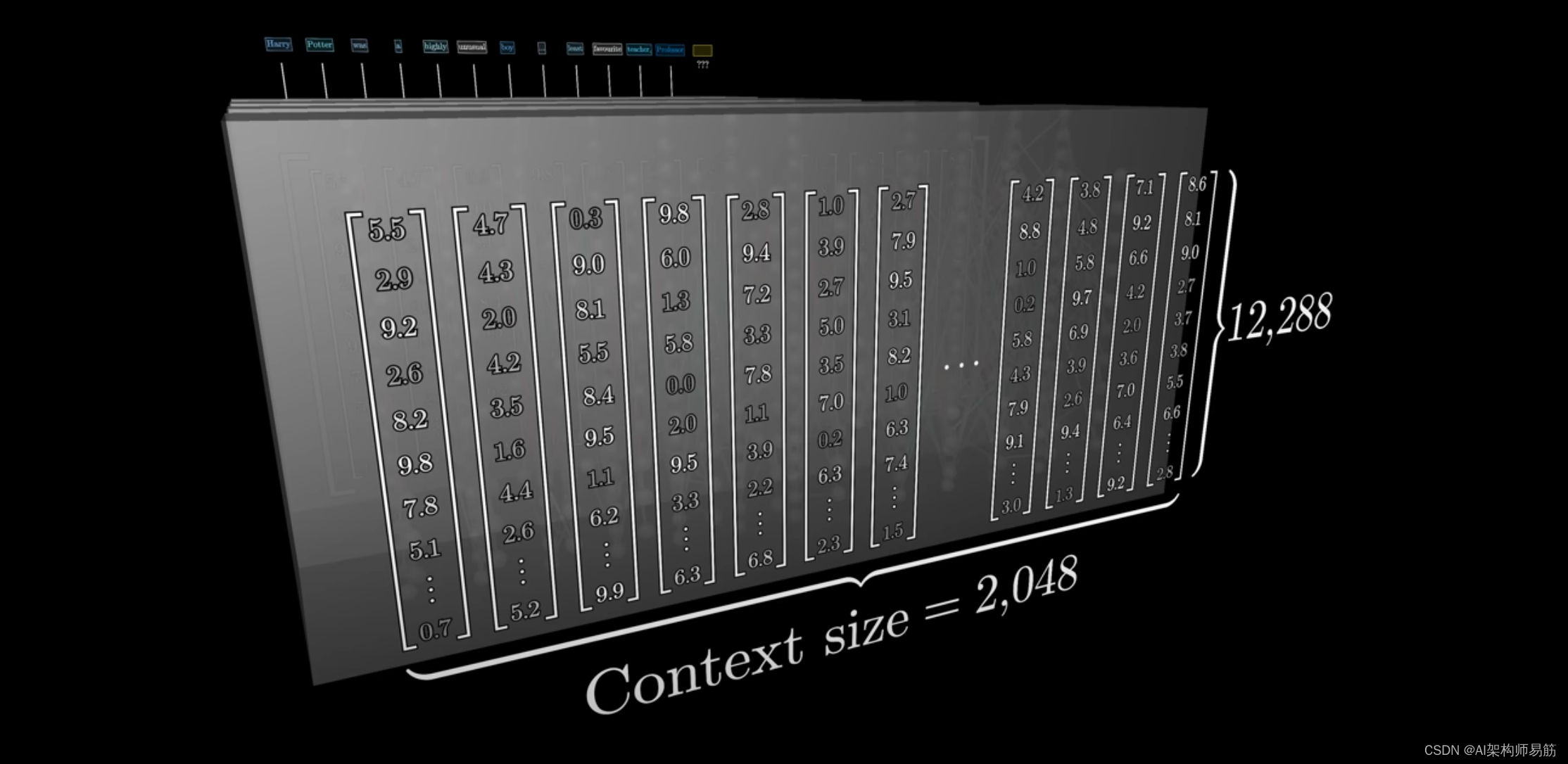

嵌入维度为12,288。

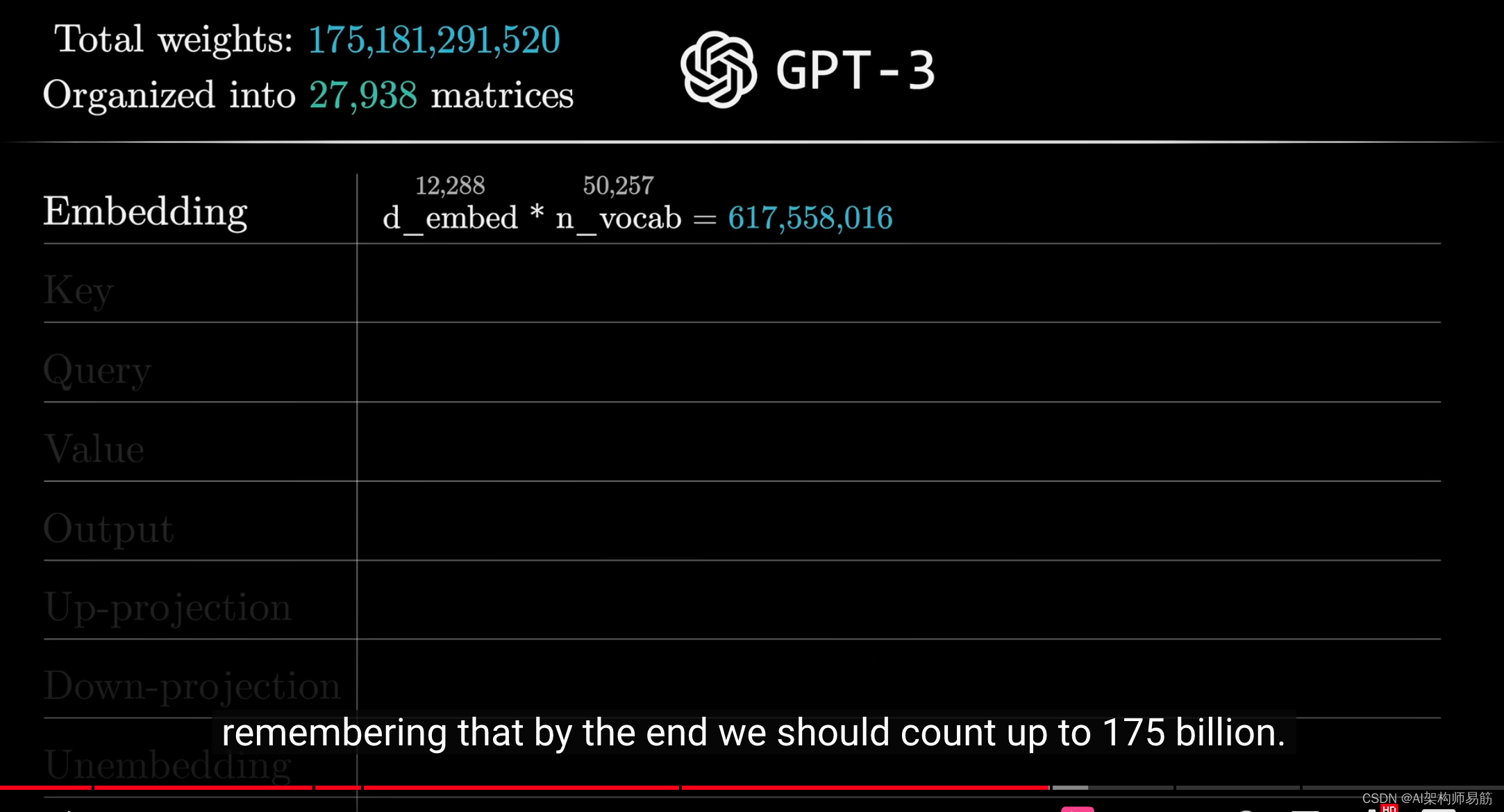

将两者相乘,我们得到大约6.17亿个权重。

我们将这个数字添加到我们的累计计数中,最终,我们应该得到1750亿个权重。

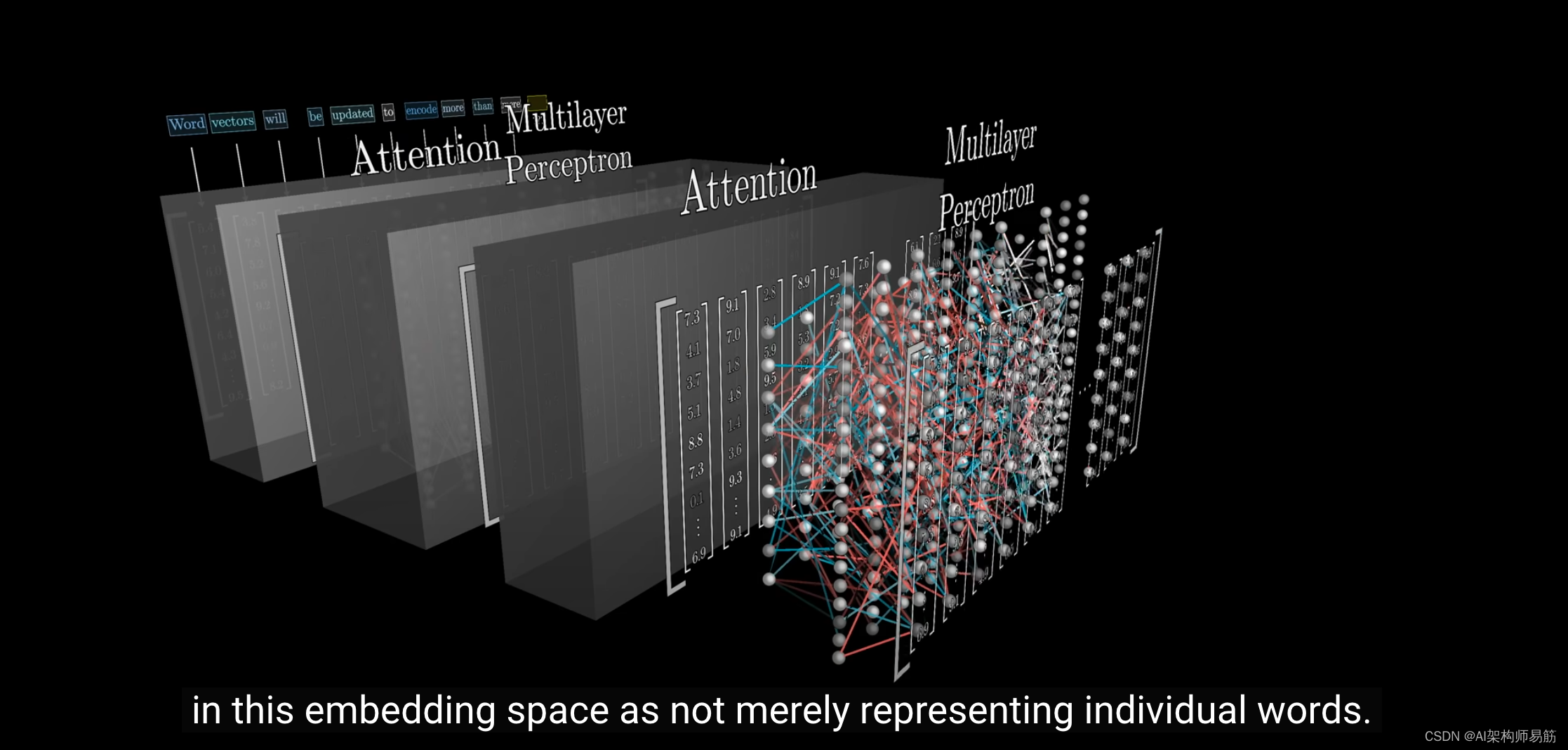

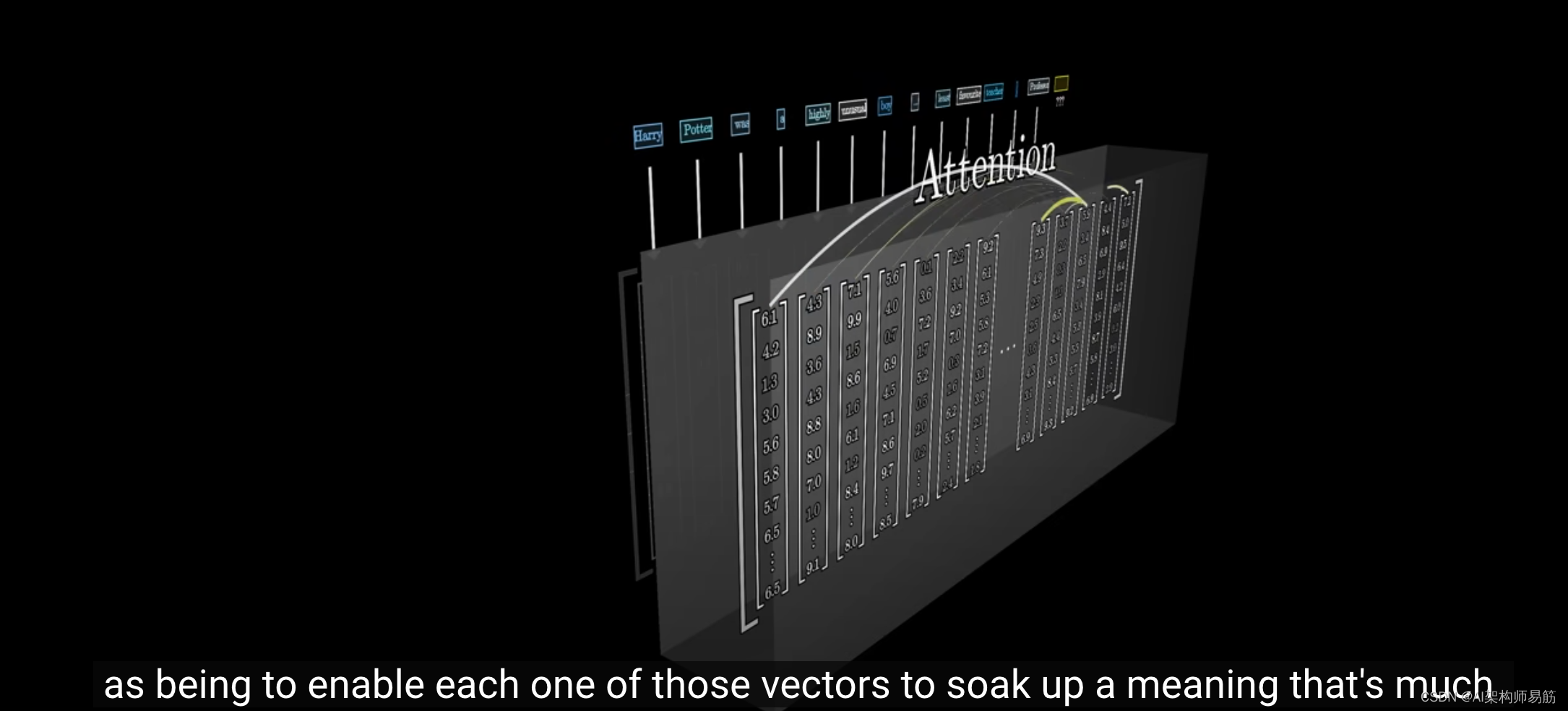

当你谈论transformers时,你会想到这些嵌入在空间中的向量不仅代表单个单词。

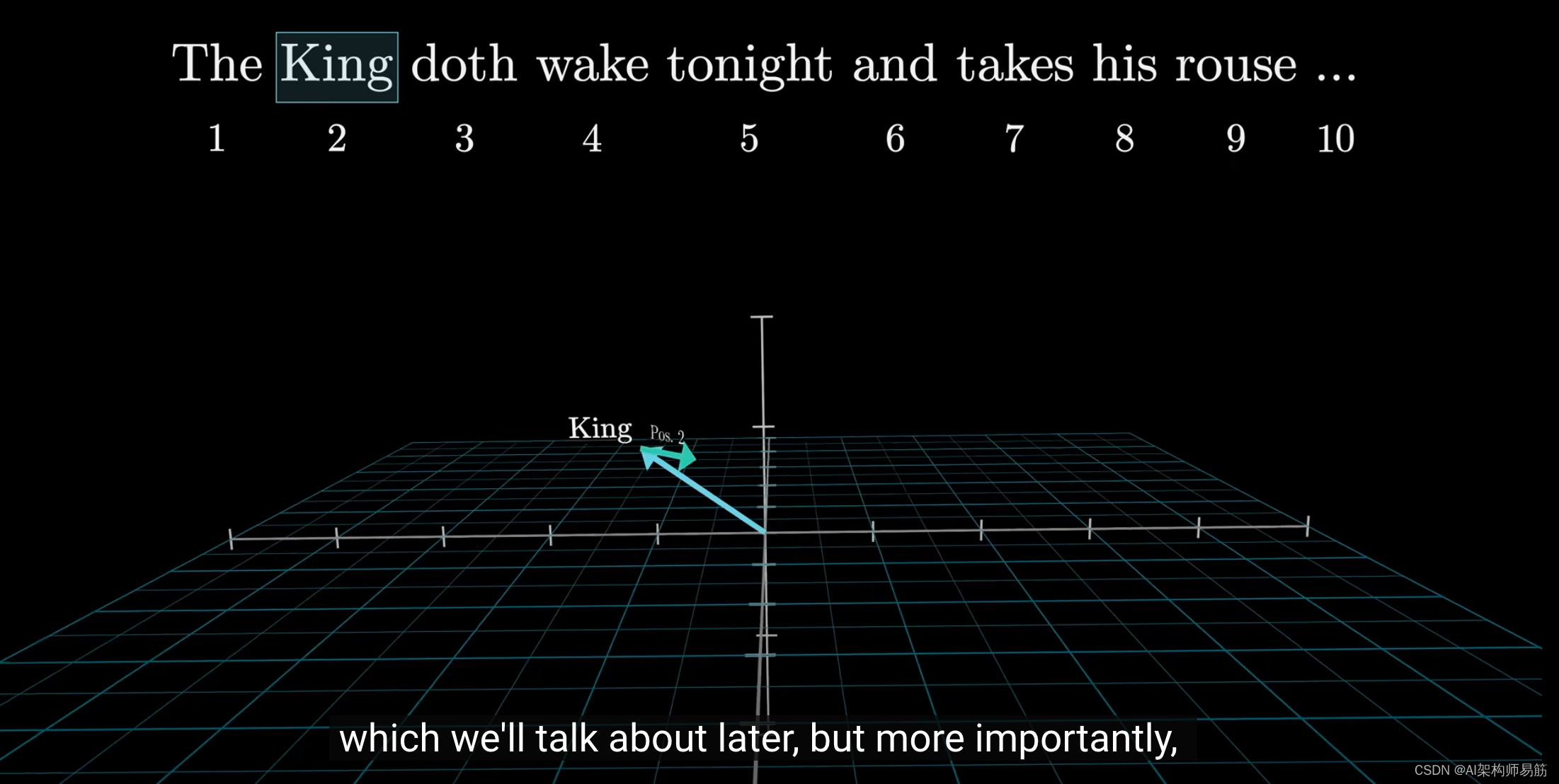

它们还携带有关单词位置的信息,我们将在后面更详细地解释。

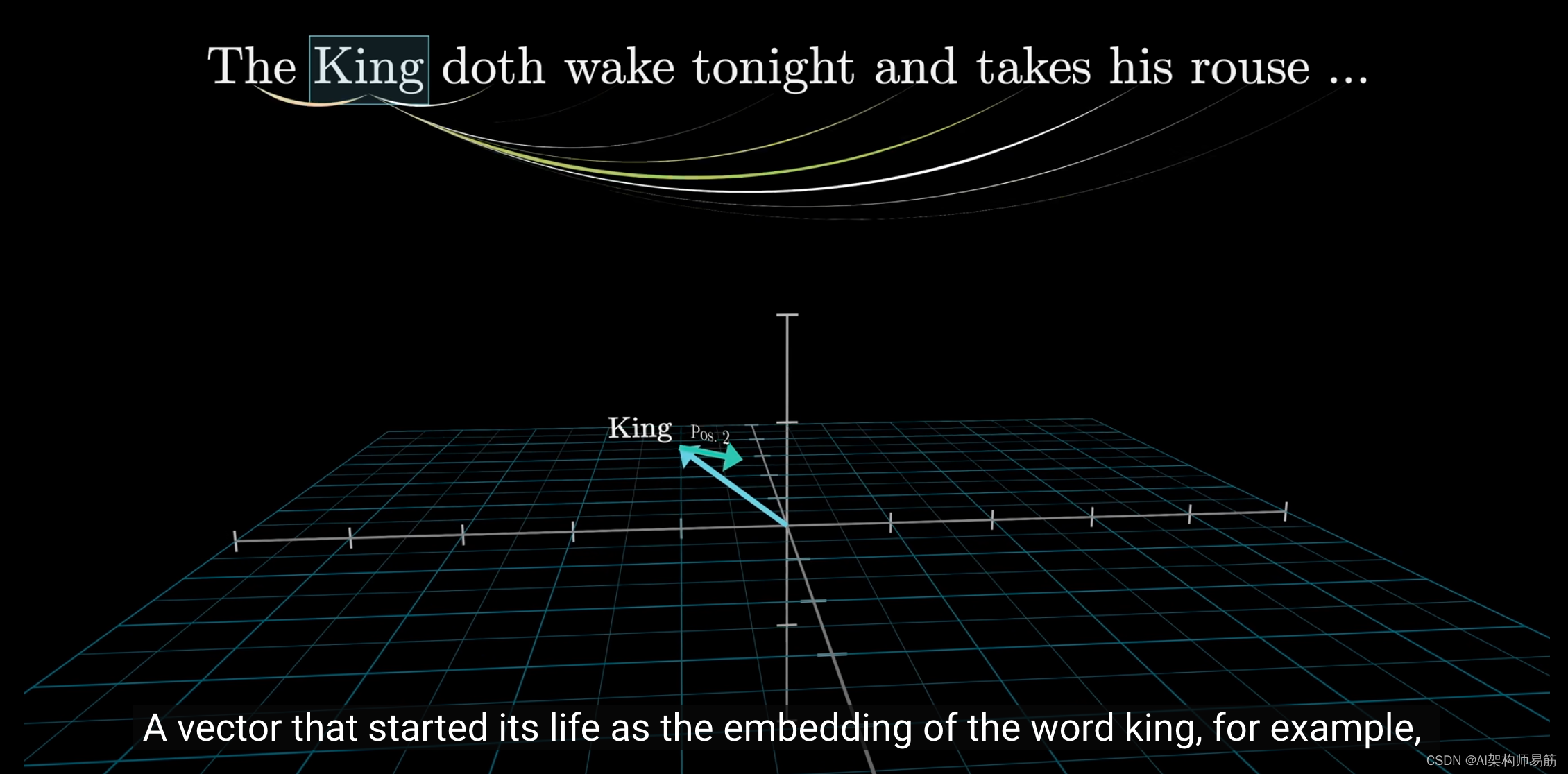

但更重要的是,这些向量吸收并反映上下文。

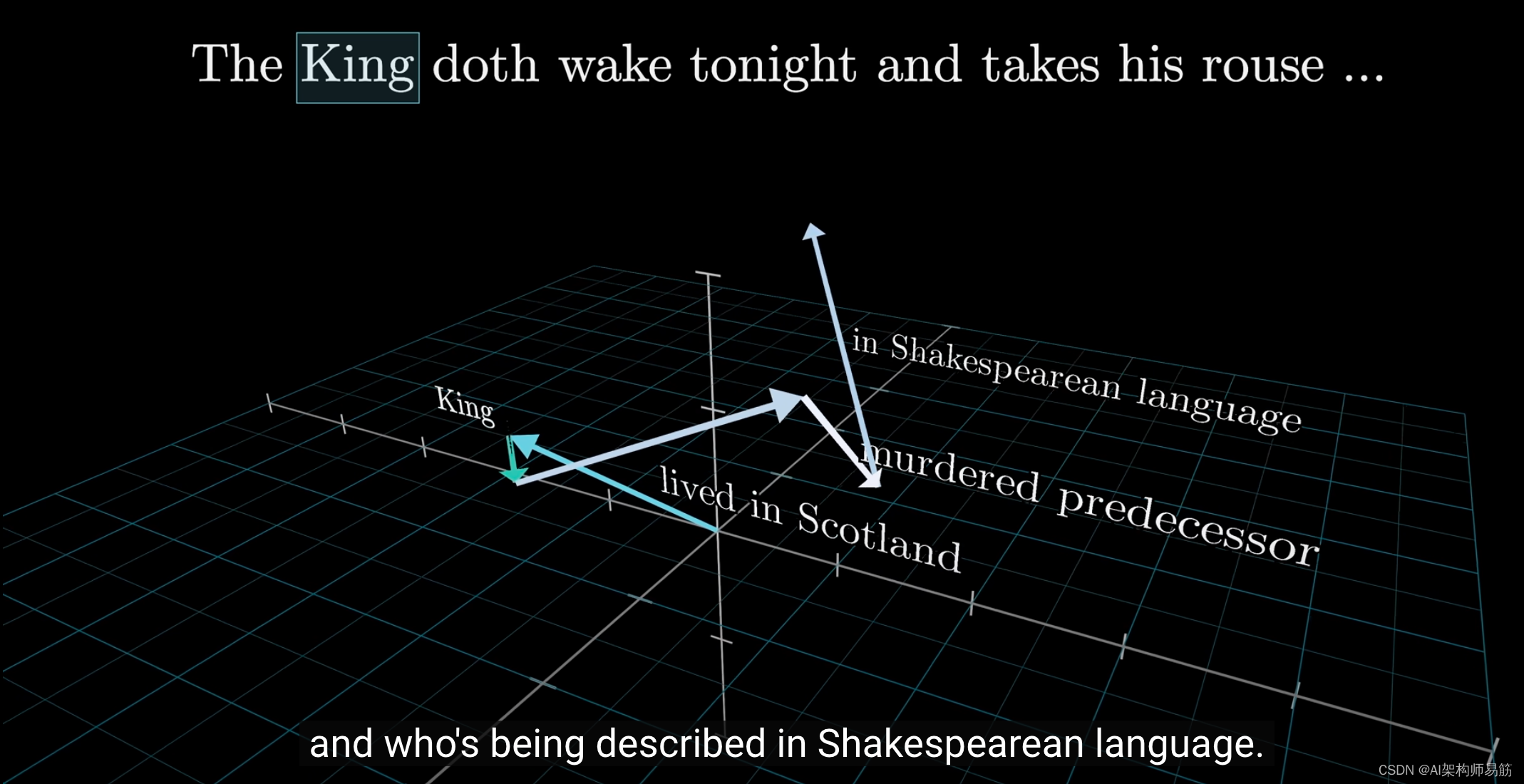

例如,一个最初代表"king"的向量可能会随着它与网络中各个点的交互而逐渐变化,所以最后,它指向一个更具体、更微妙的方向,

以某种方式编码了一个生活在苏格兰的国王,他在杀死前任国王后获得了这个位置,并以充满莎士比亚语言的方式被描绘。

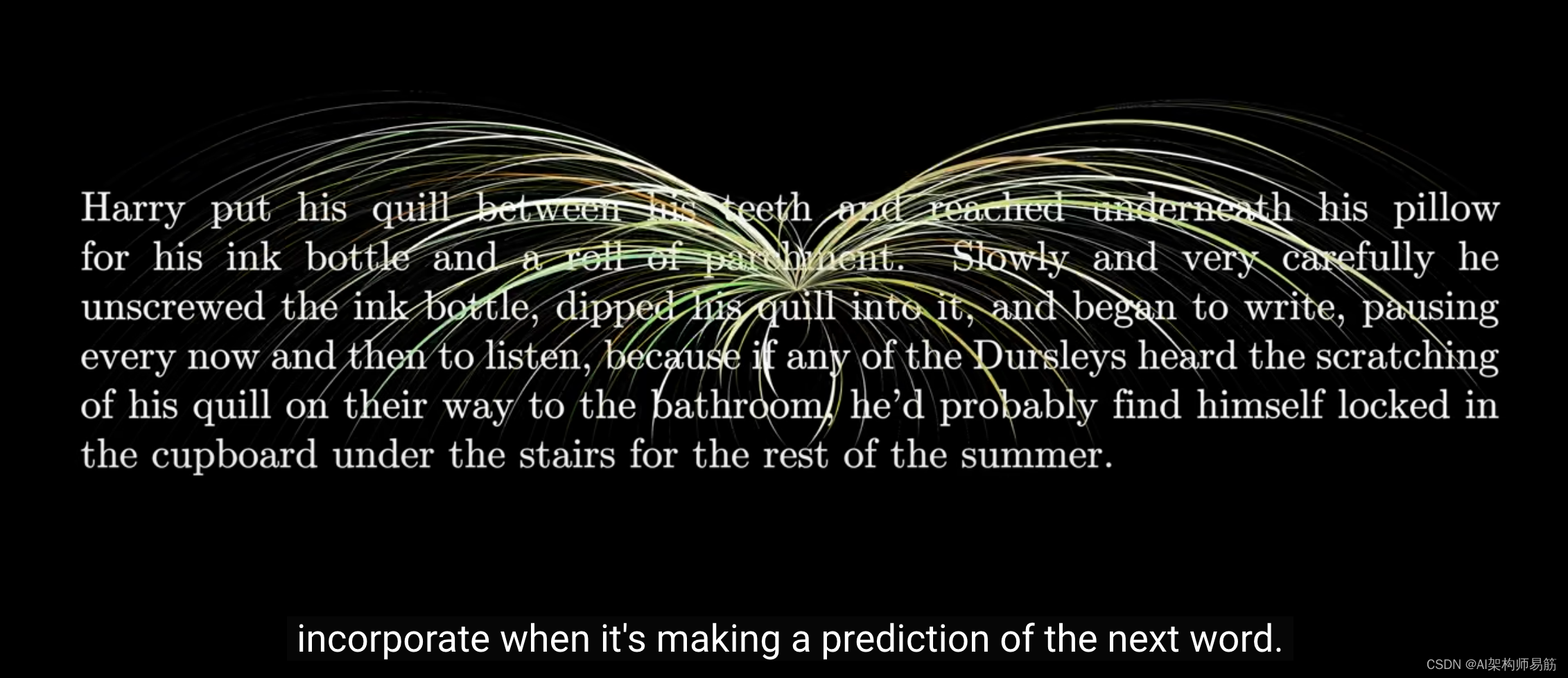

想想你对一个词的理解通常是如何形成的。

这个词的意义在很大程度上取决于它所处的上下文,

有时甚至来自遥远的上下文。

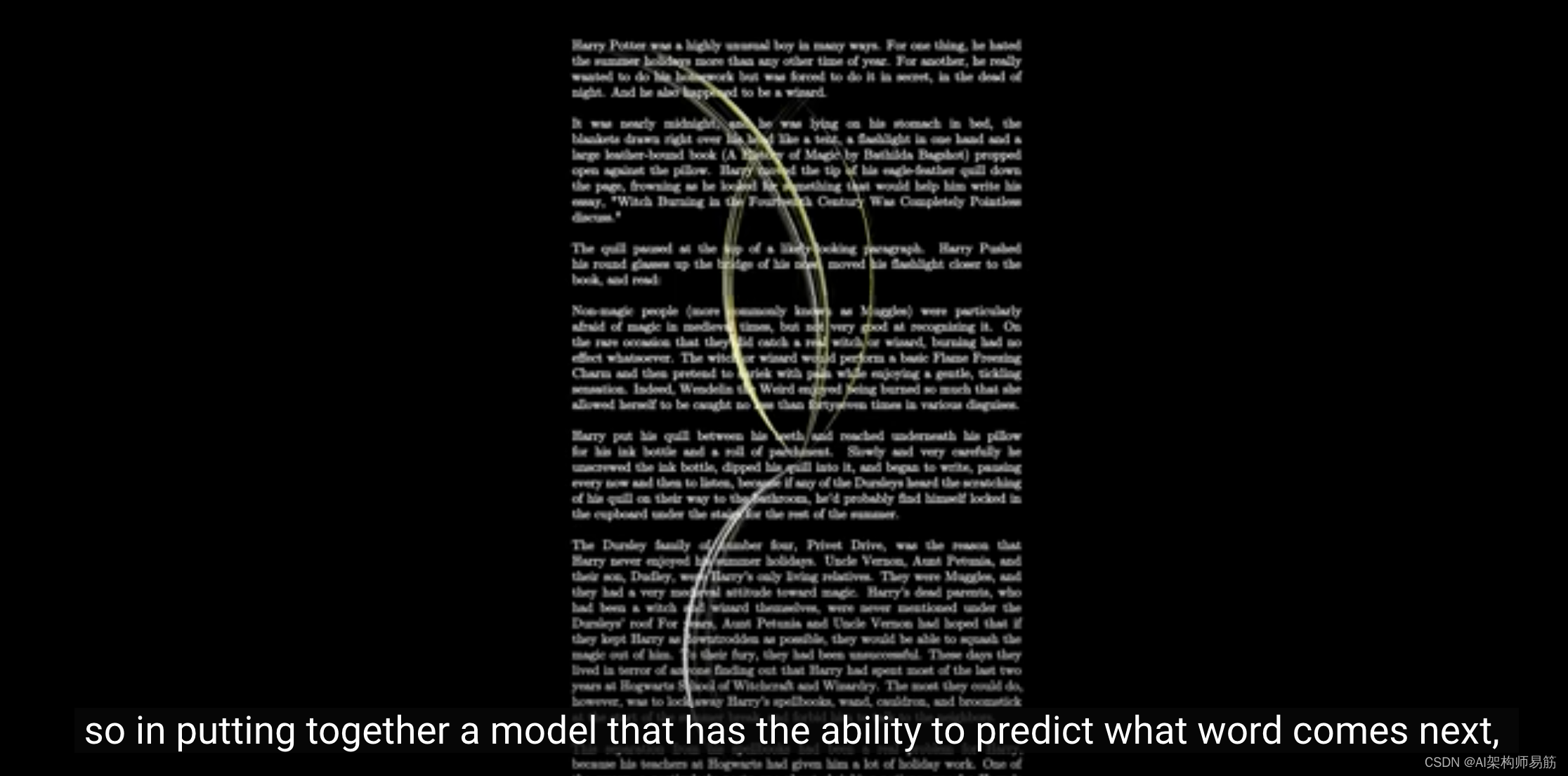

因此,在构建预测下一个词的模型时,关键目标是使其能够有效地整合上下文信息。

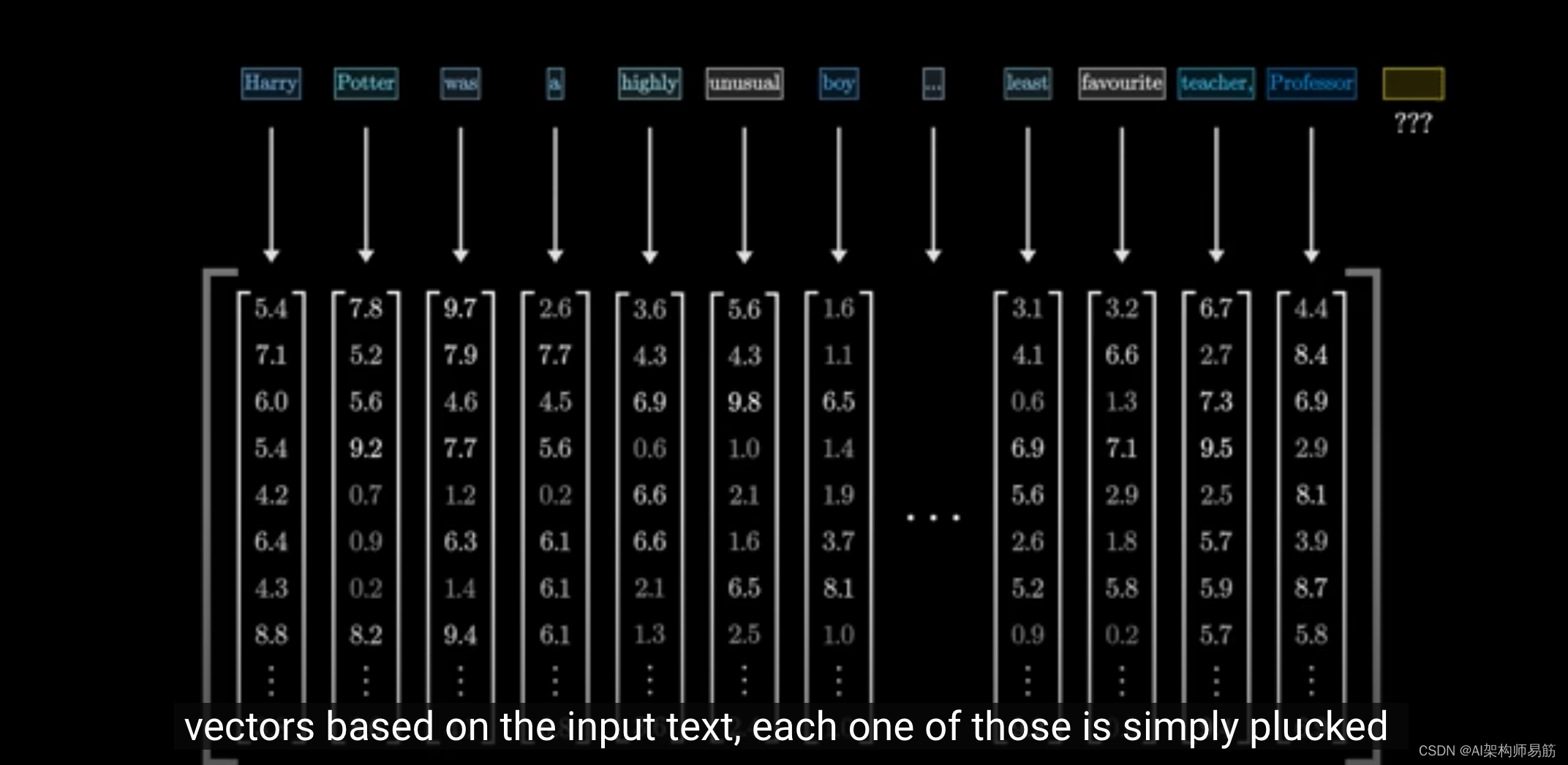

需要明确的是,在第一步中,当我们根据输入文本创建一个向量数组时,每个向量都是直接从嵌入矩阵中挑选出来的。

这意味着,起初,每个向量只代表一个词的意义,并不涉及其周围的信息。

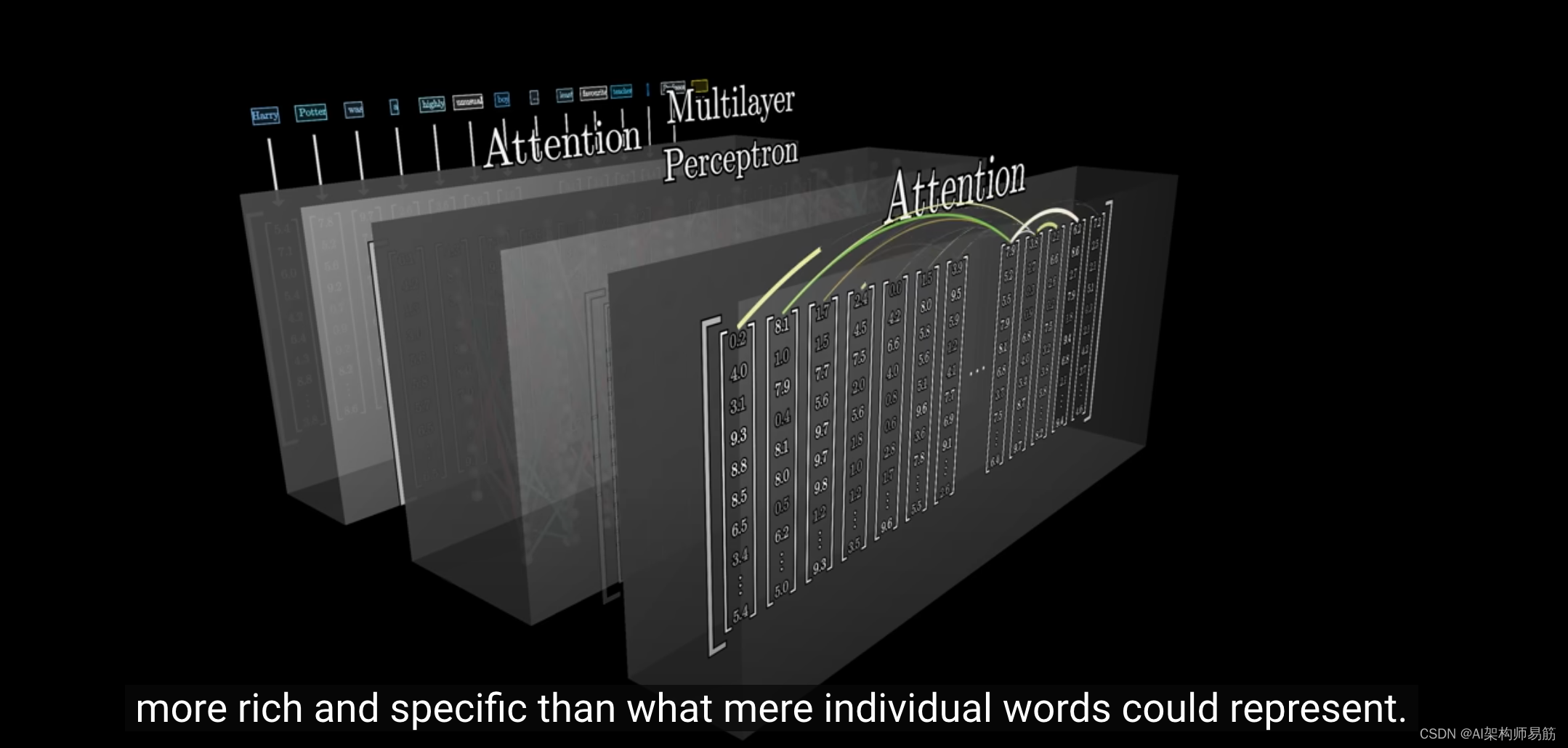

但我们的主要目标是让这些向量通过网络,

使每个向量获得比单个词更丰富、更具体的含义。

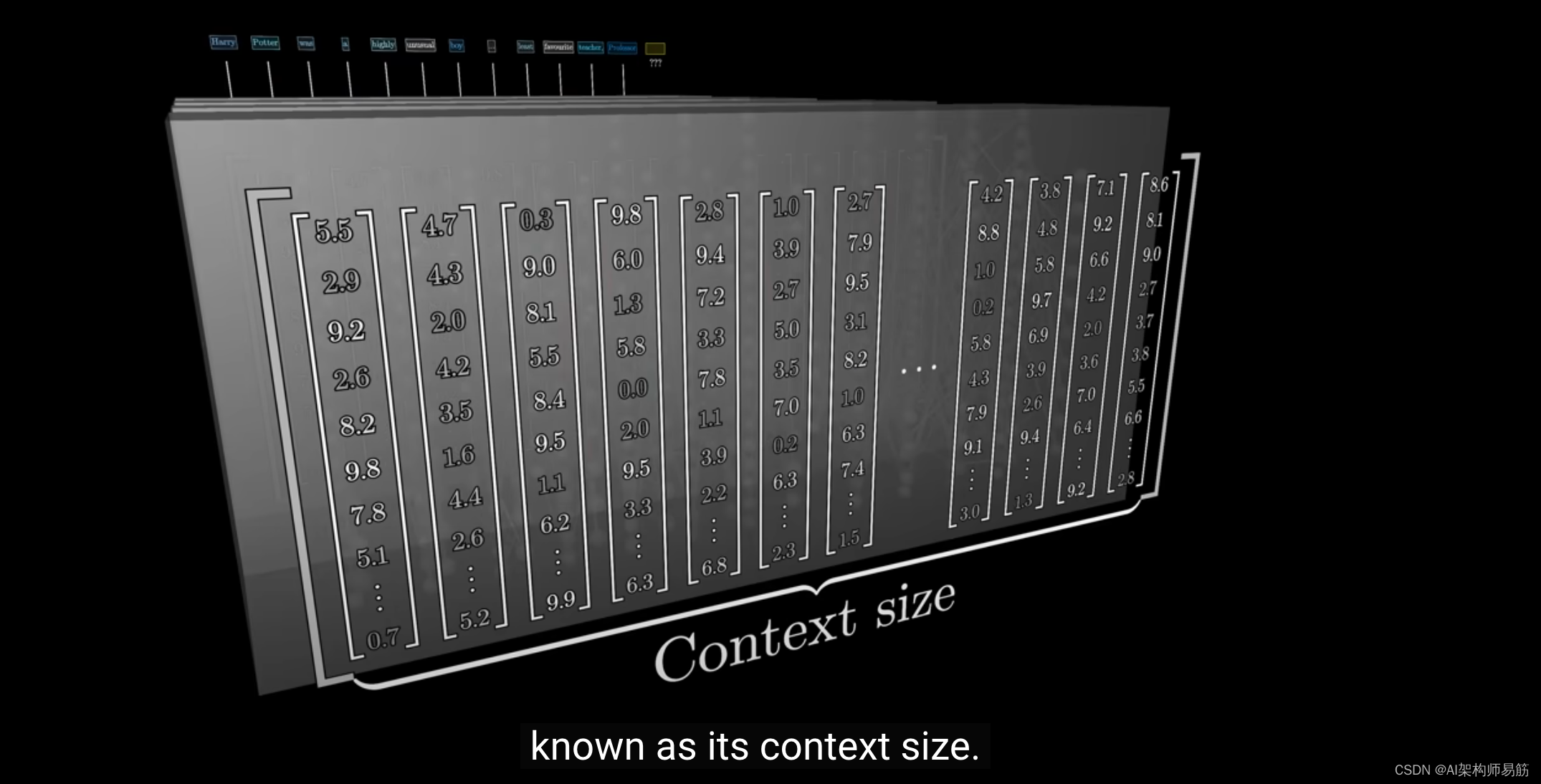

这个网络一次只能处理一定数量的向量,这被称为上下文大小(context size)。

对于GPT-3,它的训练上下文大小为2048,这意味着当数据流经网络时,它总是看起来像一个有2048列的数组,每列有12,288个维度。

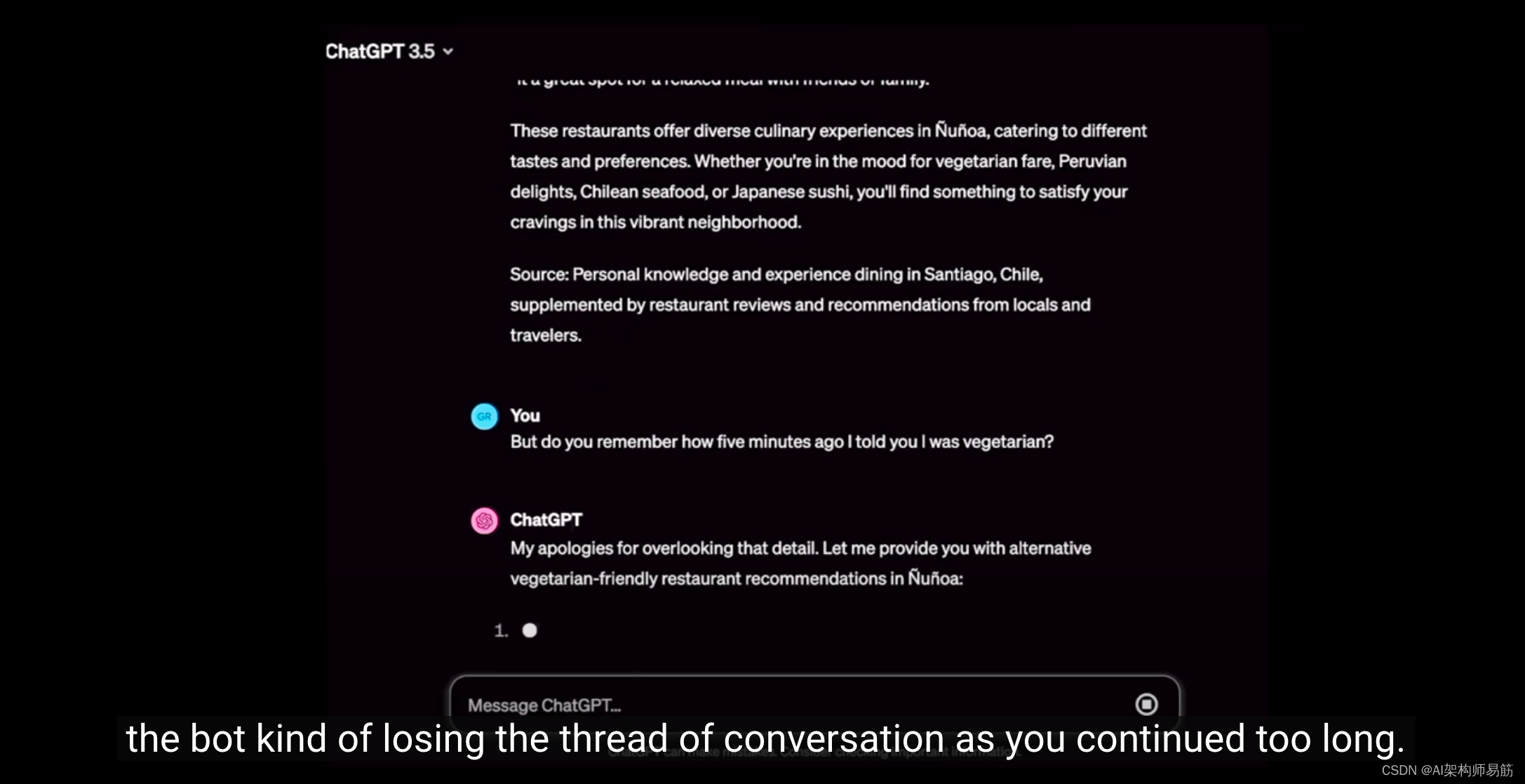

这个上下文大小2048限制了Transformer在预测下一个词时可以包含的文本量。

这解释了为什么,如果你与某些聊天机器人(如早期版本的ChatGPT)进行长时间对话,你可能会感觉机器人在对话中迷失了方向,特别是如果对话持续时间过长。

我们将在适当的时候更详细地讨论注意力机制,但让我们简要地看一下最后阶段。

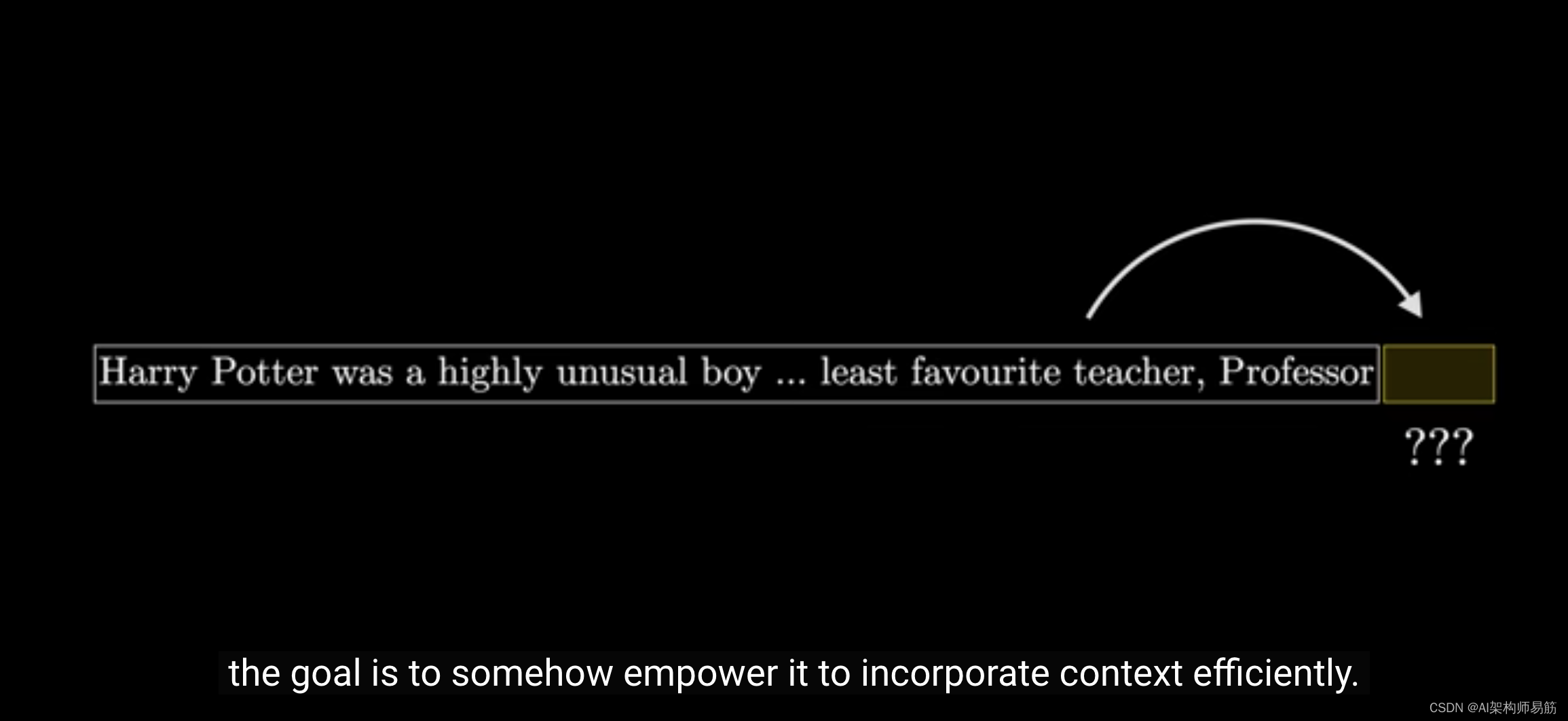

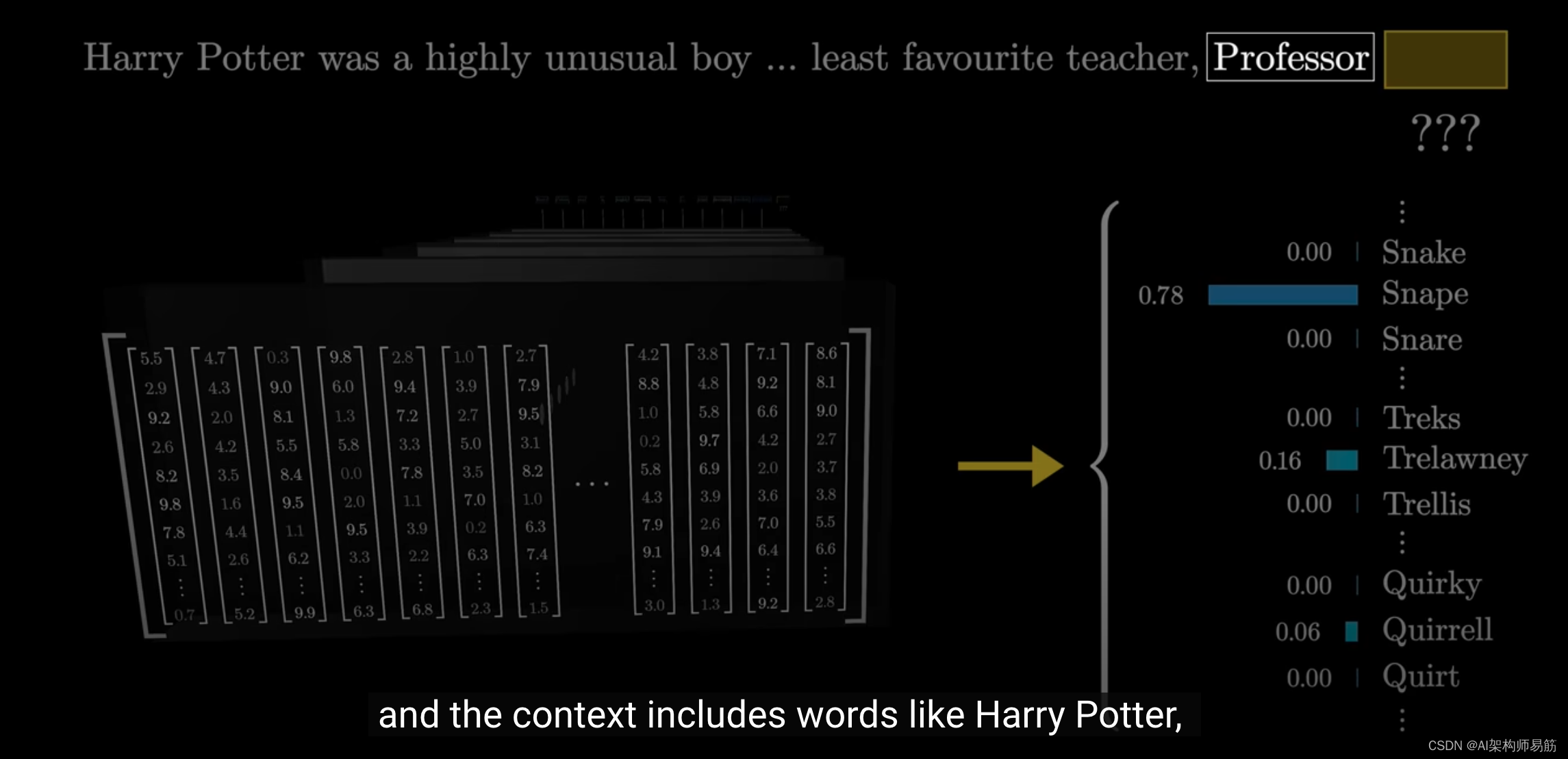

请记住,最终目标是生成一个概率分布,预测下一个可能的token。

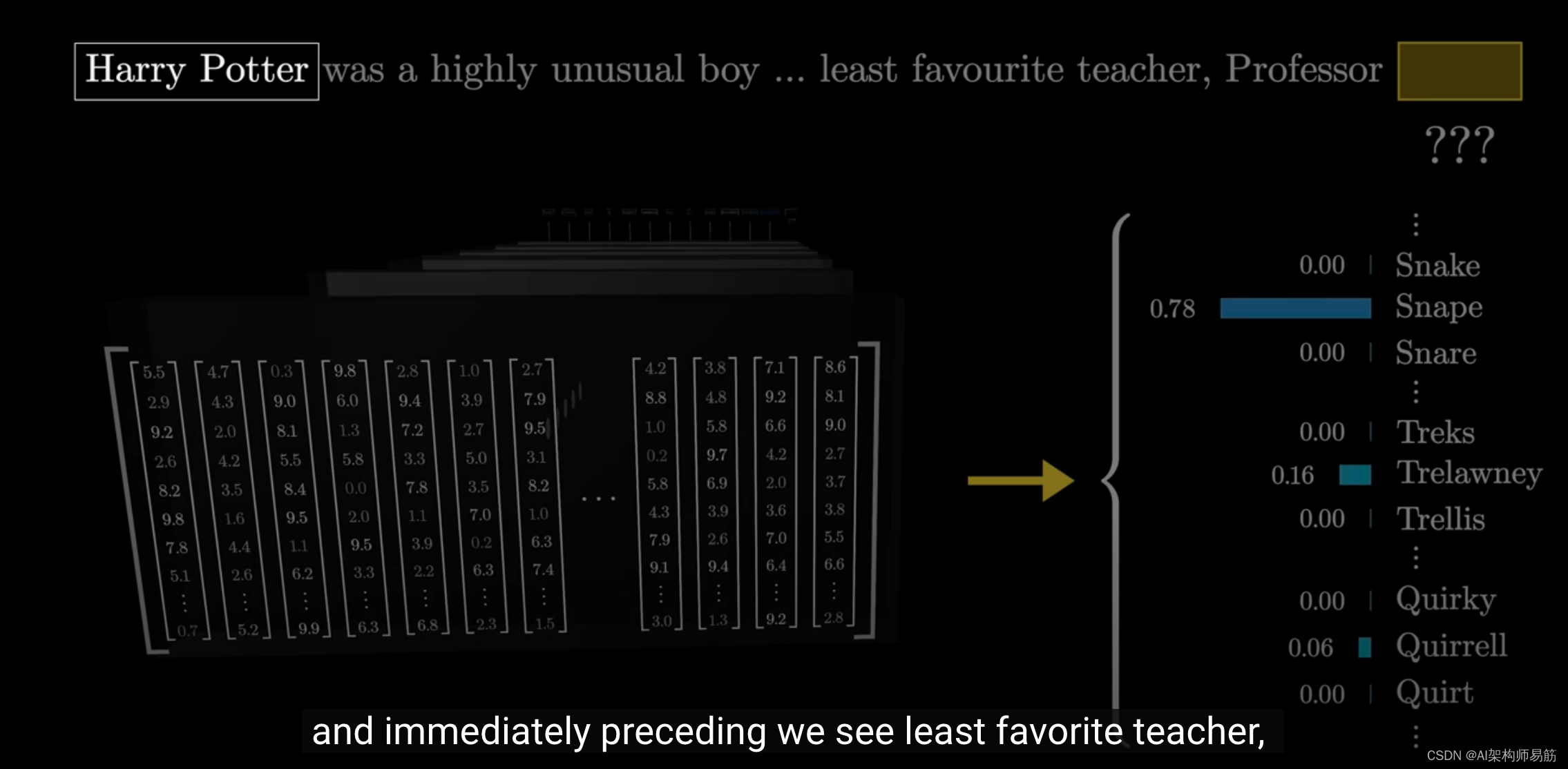

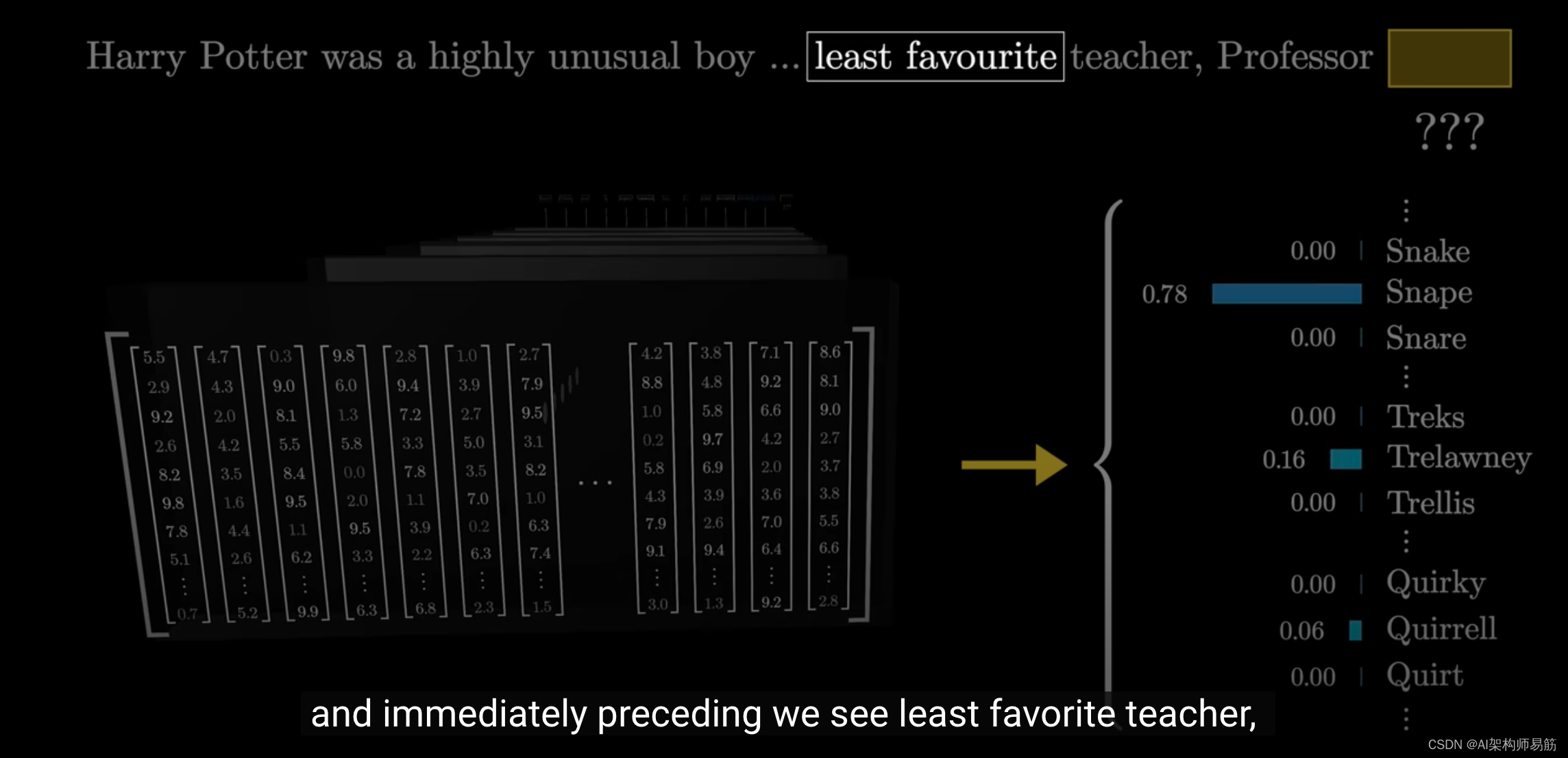

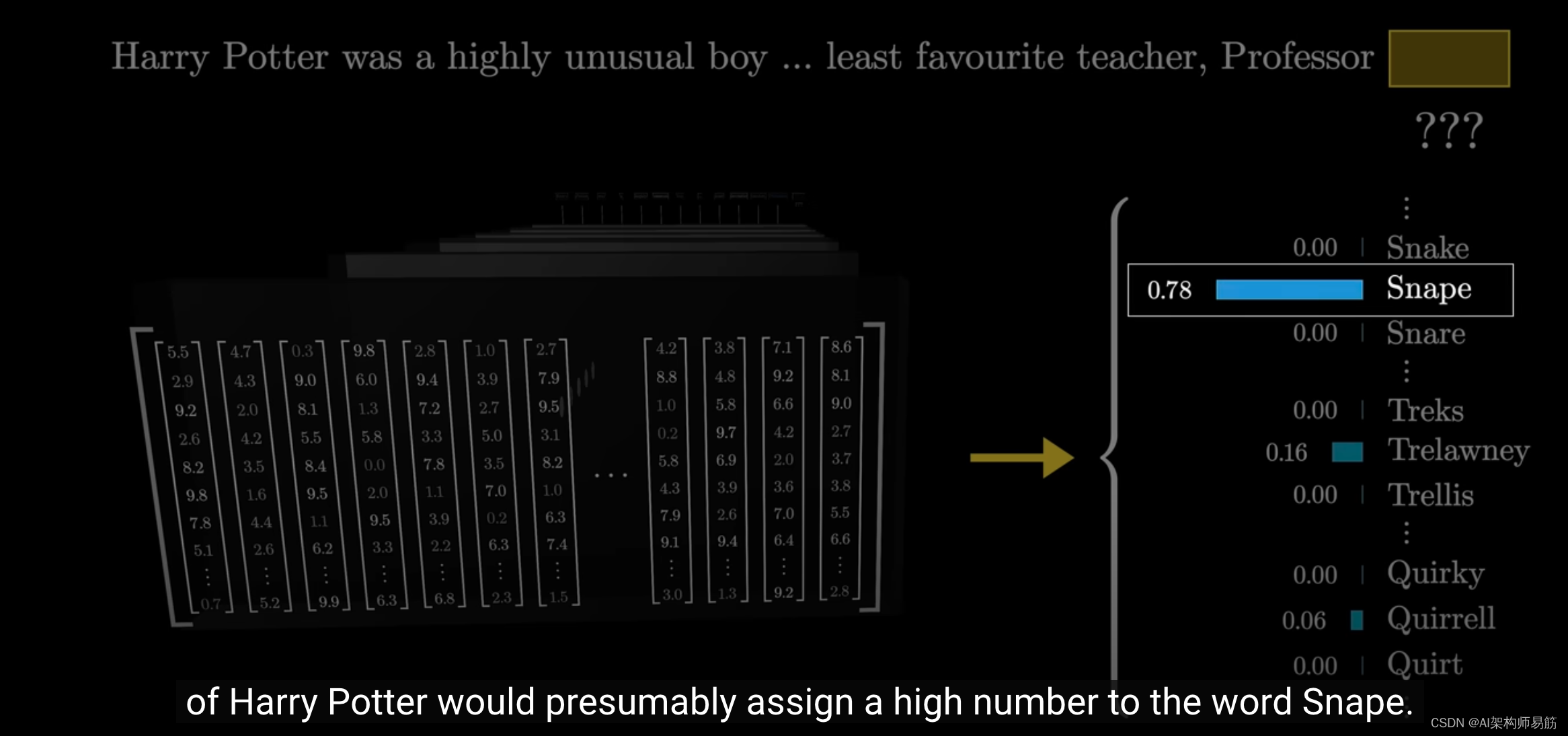

例如,如果最后一个词是"professor",

并且上下文包含诸如"Harry Potter"之类的词,

后面跟着"least favorite teacher",如果我可以稍微玩一下的话,假设tokens是完整的单词。

那么,一个训练有素、了解哈利波特世界的网络很可能会给单词"Snape"一个很高的权重。

参考

https://youtu.be/wjZofJX0v4M?si=DujTHghH5dYM3KpZ